Introduktion til typer af maskinlæringsalgoritmer

Maskinlæringsalgoritmetyper eller AI-beregninger er programmer (matematik og rationale), der ændrer sig selv til at yde bedre, når de præsenteres for mere information. "Tilpasning" af en del af AI indebærer, at disse projekter ændrer, hvordan de behandler information efter et stykke tid, ligesom mennesker ændrer, hvordan de behandler information ved at lære. Så en maskinlæring eller AI-beregning er et program med en bestemt metode til at ændre sine helt egne parametre i betragtning af kritik af dets tidligere udstillingsfremmende forventninger til et datasæt.

Alle typer maskinlæringsalgoritmer

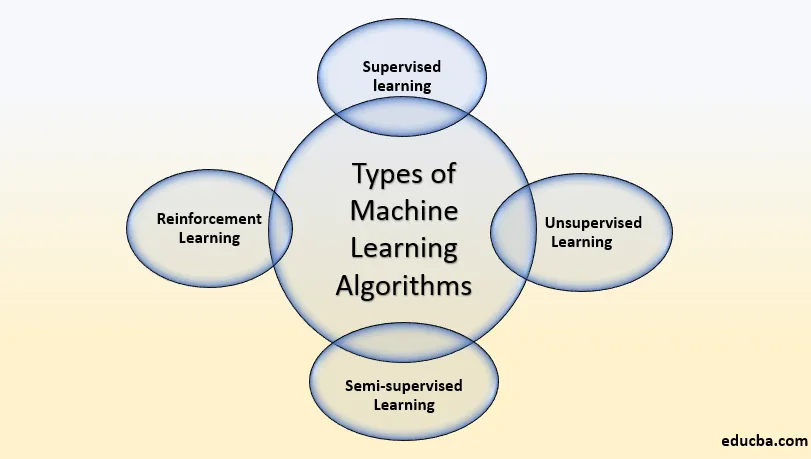

Deres bestemte varianter af, hvordan man karakteriserer typerne af Machine Learning Algorithms-typer, men som regel kan de opdeles i klasser i henhold til deres motivation og de grundlæggende klassifikationer er de ledsagende:

- Overvåget læring

- Uovervåget læring

- Semi-overvåget læring

- Forstærkningslæring

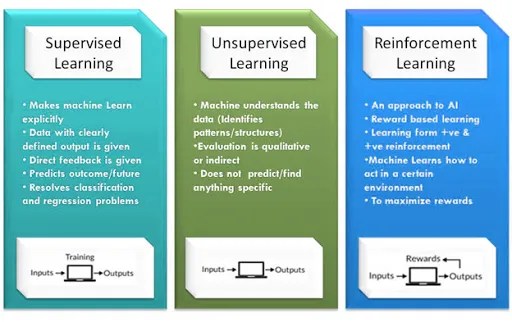

Hvad er Superviseret læring

Vejledt læring er, hvor du kan overveje at læringen styres af en instruktør. Vi har et datasæt, der foregår som underviser, og dets opgave er at forberede modellen eller maskinen. Når modellen bliver forberedt, kan den begynde at slå sig ned fra en forventning eller et valg, når der gives nye oplysninger til den.

Eksempel på Supervised Learning:

- Du får en masse fotografier med data om, hvad der er på dem, og derefter træner du en model til at opfatte nye fotografier.

- Du har en masse data om huspriser på baggrund af deres størrelse og placering, og du indlæser den i modellen og træner den, så kan du forudsige prisen på andre huse baseret på data, du fodrer.

- Hvis du vil forudsige, at din besked er spam eller ikke er baseret på ældre beskeder, du har, kan du forudsige, at en ny meddelelse er spam eller ej.

Den overvågede læringsalgoritme er som følger:

1) Lineær regression

lineær regression er værdifuld til at opdage forbindelsen mellem to vedvarende faktorer. Den ene er en prediktor eller en autonom variabel, og den anden er en reaktions- eller afdelingsvariabel. Det søger efter et målbart forhold, dog ikke efter et deterministisk forhold. Forbindelsen mellem to faktorer siges at være deterministisk for off-chancen for, at den ene variabel nøjagtigt kan kommunikeres af den anden. For eksempel ved anvendelse af temperatur i grad Celsius kan det tænkes at præcist forudse Fahrenheit. Faktisk forhold er ikke præcist i beslutningen om en forbindelse mellem to faktorer. For eksempel forbindelse et eller andet sted i intervallet mellem højde og vægt. Centraltanken er at få en linje, der bedst passer til informationen. Den bedst egnede linje er den, hvorpå alt-out prognoseflat (alle informationsfokus) er så lidt, som man kunne forvente under omstændighederne. Fejlen er adskillelsen mellem punktet til regressionslinjen.

2) Beslutningstræer

Et beslutningstræ er en gadget til beslutningshjælp, der bruger et trælignende diagram eller model af beslutninger og deres potentielle resultater, herunder resultater af tilfældet begivenhed, ressourceomkostninger og nytteværdi. Udforsk billedet for at få et synspunkt om, hvad det ligner.

3) Naive Bayes klassificering

Naive Bayes klassificerer en gruppe af grundlæggende probabilistiske klassifikatorer, der er afhængige af at anvende Bayes 'teori med stærk (usofistikeret) selvstyre egenskaber Naive Bayes. Denne klassificering Nogle af de certificerbare modeller er:

Sådan stempler du en e-mail som spam eller ikke som spam

Bestil en nyhed om innovation, regeringsspørgsmål eller sport

Kontroller et strejf af stof, der bibringer positive følelser eller negative følelser?

Brugt til programmering af ansigtsgenkendelse.

4) Logistisk regression

Logistisk regression er en banebrydende faktuel metode til at demonstrere et binomialt resultat med mindst én informative faktorer. Det kvantificerer forbindelsen mellem den absolutte afdelingsvariabel og mindst én frie faktorer ved at evaluere sandsynligheder ved hjælp af en logistisk kapacitet, som er den kombinerede logistiske bevilling.

Normalt kan regressioner bruges i det virkelige liv som:

Kredit score

Målet på succesraten for marked eller virksomhed

At forudsige indtægterne fra ethvert selskab eller ethvert produkt

Er der et jordskælv på enhver dag?

5) Almindelig mindste kvadratregression

Mindst firkanter er en strategi for at udføre direkte regression. direkte regression er tilsagnet om at montere en linje gennem mange fokus. Der er forskellige mulige procedurer for at gøre dette, og "almindelige mindstekvadrater" -system går sådan: Du kan tegne en linje, og derefter for alle datacentre, måle den lodrette løsrivelse mellem punktet og linjen og inkorporere disse op; den monterede linje ville være det sted, hvor dette aggregat af skillevægge er så mager, som kunne være normalt i lyset af den aktuelle situation.

Hvad er uovervåget læring?

Modellen lærer gennem opfattelse og opdager strukturer i informationen. Når modellen får et datasæt, opdager den følgelig eksempler og forbindelser i datasættet ved at fremstille klaser i det. Hvad det ikke kan gøre, er at tilføje mærker til bundten, ligesom det ikke kan angive dette en samling af æbler eller mango, men det vil isolere hvert enkelt af æblerne fra mango.

Antag, at vi viste billeder af æbler, bananer og mango til modellen, så hvad den gør, i lyset af visse eksempler og forbindelser, gør den bundter og opdeler datasættet i disse grupper. I øjeblikket, hvis en anden information styrkes til modellen, tilføjer den den til en af de foretagne klaser.

Eksempel på uovervåget læring

- Du har en masse fotografier af 6 personer endnu uden data om, hvem der er på, og du skal isolere dette datasæt i 6 dynger, hver med fotografierne fra en person.

- Du har partikler, en del af dem er medicin, og en del er ikke, men du er ikke klar over, hvad der vil være, og du har brug for beregningen for at finde medicinen.

Den uovervågede læringsalgoritme er som følger

clustering

Clustering er en vigtig idé med hensyn til uhjælpet læring. Det lykkes for det meste at finde en struktur eller et eksempel i en indsamling af uklassificeret information. Clustering-beregninger behandler dine oplysninger og finder karakteristiske klynger (grupper) i tilfælde af, at de findes i informationen. Du kan ligeledes ændre, hvor mange klaser dine beregninger burde skelne. Det giver dig mulighed for at ændre granulariteten i disse sammenkomster.

Der er forskellige slags klynger, du kan bruge

- Selektiv (fordeling)

- Model: K-betyder

- agglomerative

- Model: Hierarkisk klynger

- Dækker

- Model: Fuzzy C-Means

- probabilistisk

Clustering algoritmetyper

- Hierarkisk klynge

- K-betyder gruppering

- K-NN (k nærmeste naboer)

- Hovedkomponentanalyse

- Solitær værdi nedbrydning

- Uafhængig komponentanalyse

- Hierarkisk klynge

Hierarkisk klynge

Hierarkisk klyngering er en beregning, der konstruerer en pecking rækkefølge af grupper. Det starter med alle de oplysninger, der uddrives til deres helt egen bunke. Her vil to nære grupper være i en lignende gruppe. Denne beregning lukkes, når der kun er en gruppe tilbage.

K-betyder Clustering

K betyder, at det er en iterativ klyngeberegning, der opfordrer dig til at finde det mest bemærkelsesværdige incitament til hver vægt. Først vælges det ideelle antal grupper. I denne klyngeteknik er du nødt til at samle de oplysninger, der fokuserer på k-samlinger. En større k betyder mindre forsamlinger med større granularitet på lignende måde. En lavere k betyder større sammenkomster med mindre granularitet.

Udbyttet af beregningen er en samling af "navne." Det tillader, at information peger på en af k-samlingerne. I k-betyder-klynge er hver samling karakteriseret ved at lave en centroid til hver samling. Centroids er som kernen i bundten, der fanger fokusene tættest på dem og tilføjer dem til gruppen.

K-middel-gruppering karakteriserer yderligere to undergrupper

- Agglomerativ gruppering

- dendrogram

Agglomerativ gruppering

Denne slags K-betyder-gruppering begynder med et fast antal klaser. Det udpeger al information til et nøjagtigt antal grupper. Denne klyngestrategi kræver ikke antallet af grupper K som info. Agglomerationsproceduren begynder med at udforme ethvert nulpunkt som en ensom bunke.

Denne strategi anvender en vis separationsforanstaltning, mindsker antallet af klaser (en i hver vægt) ved at kombinere proces. Afslutningsvis har vi en større gruppe, der indeholder alle artiklerne.

dendrogram

I Dendrogram-klyngeteknikken taler hvert niveau til en tænkelig flok. Dendrogrammets højde viser graden af ensartethed mellem to sammenføjede bunker. Jo tættere på basen af proceduren er de gradvis sammenlignelige bunke, der finder ud af samlingen fra dendrogram, som ikke er karakteristisk og for det meste abstrakt.

K-nærmeste naboer

K-nærmeste nabo er den mest ligetil af alle AI-klassifikatorer. Det varierer fra andre AI-procedurer, idet det ikke leverer en model. Det er en ligetil beregning, der gemmer hver enkelt tilgængelig sag og karakteriserer nye eksempler, der er afhængige af en lighedstiltag.

Det fungerer meget godt, når der er en adskillelse mellem modeller. Læringshastigheden er moderat, når forberedelsessættet er enormt, og separationsfigureringen er ikke-triviel.

Analyse af hovedkomponenter

Med en chance for, at du har brug for et højere-dimensionelt rum. Du er nødt til at vælge en årsag til det rum og bare de 200 mest markante score på det forudsætning. Denne base er kendt som en hovedkomponent. Den delmængde, du vælger, er et andet rum, der er lidt i størrelse i kontrast til det unikke rum. Det holder dog meget med den mangesidede information af information, som man kunne forvente.

Hvad er forstærkningslæring?

Det er en specialist som kapacitet til at samarbejde med jorden og opdage, hvad der er det bedste resultat. Det forfølger ideen om hit og indledende teknik. Operatøren aflønnes eller straffes med et punkt for et ret eller et off-basissvar, og baseret på den positive belønning er der taget fokus på selve togene. Når den igen er forberedt, forbereder den sig også på at forudse de nye oplysninger, der er introduceret til den.

Eksempel på forstærkningslæring

- Visning af annoncer optimeres i henhold til brugerens lignende ikke i lang tid

- Kend annoncer budgettet brugt i realtid

- omvendt forstærkningslæring til at kende kunder kan lide ikke lide godt

Hvad er semi-superviseret læring?

Semi-overvåget slags indlæring, beregningen er forberedt på en blanding af navngivne og umærkede oplysninger. Normalt vil denne blanding indeholde en begrænset mængde navngivne oplysninger og en masse umærket information. Den grundlæggende metode inkluderet er, at softwareingeniøren først vil gruppere sammenlignelige oplysninger ved hjælp af en uhjælpet beregning af læring og derefter bruge den aktuelle navngivne information til at navngive resten af den umærkede information. De almindelige brugstilfælde til en sådan type beregning har en typisk egenskab blandt dem - Indhentning af umærket information er generelt beskedent, mens navngivningen af nævnte information er over den dyre. Naturligvis kan man forestille sig de tre slags læringsberegninger som Overvåget indse, hvor en underudvikling er under opsyn af en instruktør både hjemme og på skolen, Uovervåget indser, hvor en underudviklet er nødt til at give mening til en idé selv og Semi-Overvåget indse, hvor en underviser viser et par ideer i klassen og giver forespørgsler som skolearbejde, der afhænger af sammenlignelige ideer.

Eksempel på Semi-Supervised Learning

Det er enestående, at mere information = modeller af bedre kvalitet i dybtgående læring (op til et specifikt indeslutningspunkt klart, men oftere end ikke har vi ikke så meget information.) Det er som om det er dyrt at få markeret information. I tilfælde af at du har brug for at forberede en model til at skelne vingede dyr, kan du oprette en masse kameraer til at tage billeder af høns. Det er generelt beskedent. Det er dyrt at kontrahere enkeltpersoner til at markere disse fotos. Overvej muligheden for, at du har et enormt antal billeder af vingerede dyr, men bare kontraher enkeltpersoner for at markere en lille undergruppe af billederne. Som det viste sig, snarere end blot at træne modellerne på det markerede undergruppe, kan du foruddanne modellen på hele træningssættet, før du justerer den med det navngivne undergruppe, og du viser tegn på forbedringskørsel i disse linjer. Det er semi-overvåget læring. Det afsætter dine kontanter.

Konklusion

Der er mange typer maskinlæringsalgoritme der, og baseret på forskellige-forskellige betingelser er vi nødt til at bruge den bedst egnede algoritme til det bedste resultat. Der er mange algoritmer, der finder den bedste nøjagtighed af hver maskinlæringsalgoritmetyper, og som er den højeste nøjagtige, vi har til at bruge denne algoritme. Vi kan minimere fejlen i hver algoritme ved at reducere støj i data. Til sidst vil jeg sige, at der ikke er en enkelt maskinlæringsalgoritme, der kan give dig 100 procent nøjagtighed, selv ikke den menneskelige hjerne kan gøre det, så find den bedste granalgoritme til dine data.

Anbefalede artikler

Dette er en guide til typer af maskinlæringsalgoritmer. Her diskuterer vi Hvad er maskinlæringsalgoritme ?, og dens typer inkluderer Overvåget læring, Uovervåget læring, semi-overvåget læring, forstærkningslæring. Du kan også se på de følgende artikler for at lære mere -

- Metoder til maskinindlæring

- Maskinlæringsbiblioteker

- Maskinlæringsmodeller

- Rammer for maskinlæring

- Hyperparameter-maskinlæring

- Hierarkisk klynge | Agglomerativ og opdelende klynge

- Opret beslutningstræ | Sådan oprettes | Fordele

- Maskinlæring livscyklus | Top 8 faser