Introduktion til tilbagestående eliminering

Som menneske og maskine banker på digital udvikling, regnskaber forskellige teknikmaskiner for at få dem ikke kun uddannet, men intelligent trænet til at komme ud med bedre genkendelse af genstande i den virkelige verden. En sådan teknik, der blev introduceret tidligere kaldet “Backward Elimination”, der havde til formål at favorisere uundværlige funktioner samtidig med at udrydde nugatoriske funktioner for at forkæle bedre optimering i en maskine. Maskinens samlede færdigheder inden for genkendelse af objekter står i forhold til hvilke funktioner den overvejer.

Funktioner, der ikke har nogen henvisning til det forudsagte output, skal udledes fra maskinen, og det afsluttes ved bagudgående eliminering. God præcision og tidskompleksitet ved anerkendelse af ethvert ægte ordobjekt fra maskine afhænger af dets læring. Så bagud eliminere spiller sin stive rolle for valg af funktion. Den beregner hastigheden for funktionernes afhængighed til den afhængige variabel finder betydningen af dens tilhørighed i modellen. For at godkende dette kontrollerer den den regnede rente med et standardvigtighedsniveau (f.eks. 0, 06) og tager en beslutning om valg af funktion.

Hvorfor begrænser vi tilbageudskillelse ?

Uundværlige og overflødige egenskaber fremdrager kompleksiteten af maskinens logik. Det fortærer unødvendigt tid og modellens ressourcer. Så den ovennævnte teknik spiller en kompetent rolle for at smede modellen til enkel. Algoritmen dyrker den bedste version af modellen ved at optimere dens ydeevne og afkorte dens forbrugsbestemte udpegede ressourcer.

Det begrænser de mindst bemærkelsesværdige træk fra modellen, der forårsager støj i beslutningen af regressionslinjen. Irrelevante genstandstræk kan medføre misklassificering og forudsigelse. Urelevante træk ved en enhed kan udgøre en ubalance i modellen med hensyn til andre væsentlige træk ved andre objekter. Den bagudgående eliminering fremmer montering af modellen i bedste fald. Derfor anbefales eliminering af bagudgående anvendelse til en model.

Sådan anvendes baguddeliminering?

Den bagudgående eliminering begynder med alle funktionsvariabler og tester den med den afhængige variabel under en valgt tilpasning af modelkriteriet. Det begynder at udrydde de variabler, der forværrer den passende regressionslinje. Gentag denne sletning, indtil modellen har fået en god pasform. Nedenfor er trinnene til at øve den tilbagestående eliminering:

Trin 1: Vælg det relevante niveau af betydning, der skal findes i maskinens model. (Tag S = 0, 06)

Trin 2: Fed alle de tilgængelige uafhængige variabler til modellen med hensyn til den afhængige variabel og computere hældningen og afskærmningen for at tegne en regressionslinje eller en passende linje.

Trin 3: Kryds med alle de uafhængige variabler, der har den højeste værdi (Tag I), én efter én, og fortsæt med følgende toast: -

a) Hvis I> S, skal du udføre det fjerde trin.

b) Ellers afbrydes, og modellen er perfekt.

Trin 4: Fjern den valgte variabel, og øg gennemgangen.

Trin 5: Smed modellen igen og beregne hældningen og afskærmningen af monteringslinjen igen med restvariabler.

Ovennævnte trin opsummeres i afvisning af de træk, hvis signifikationsgrad er over den valgte signifikansværdi (0, 06) for at undgå overklassificering og overudnyttelse af ressourcer, der blev observeret som høj kompleksitet.

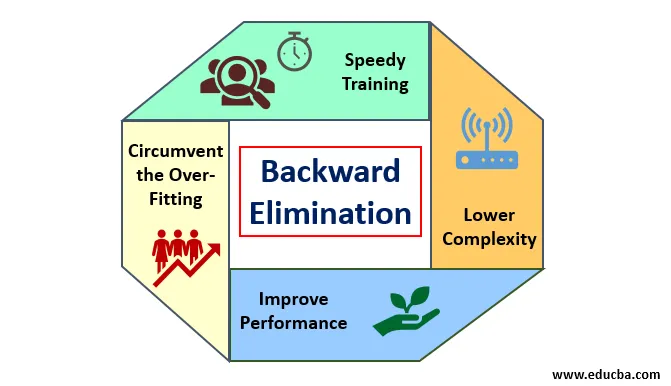

Fortjeneste og begrænsninger ved tilbagestående eliminering

Her er nogle fordele og underskud ved bagudgående eliminering, der er beskrevet nedenfor i detaljer:

1. Fortjeneste

Fortjeneste ved bagudgående eliminering er som følger:

- Hurtig træning: Maskinen er trænet med et sæt tilgængelige mønstrefunktioner, der udføres på meget kort tid, hvis uvæsentlige funktioner fjernes fra modellen. Hurtig træning af datasættet kommer kun i billedet, når modellen beskæftiger sig med væsentlige funktioner og ekskluderer alle støjvariabler. Det tegner en simpel kompleksitet til træning. Men modellen skal ikke gennemgå undermontering, som opstår på grund af manglende egenskaber eller utilstrækkelige prøver. Prøvefunktionen skal være rigeligt i en model for den bedste klassificering. Tiden, der kræves for at træne modellen, skal være mindre, mens klassificeringsnøjagtigheden opretholdes og uden nogen underforudsigelsesvariabel.

- Lavere kompleksitet: Kompleksiteten af modellen er tilfældigvis høj, hvis modellen overvejer omfanget af funktioner inklusive støj og ikke-relaterede funktioner. Modellen bruger meget plads og tid på at behandle en sådan række funktioner. Dette kan øge hastigheden af nøjagtighed af mønstergenkendelse, men hastigheden kan også indeholde støj. For at slippe af med en så høj kompleksitet af modellen spiller den tilbagevendende eliminationsalgoritme en nødvendig rolle ved at vende tilbage til de uønskede funktioner fra modellen. Det forenkler processens logik for modellen. Kun få vigtige funktioner er rigelige for at tegne en god pasform, der indeholder tilstrækkelig nøjagtighed.

- Forbedring af ydelsen: Modelydelsen afhænger af mange aspekter. Modellen gennemgår optimering ved hjælp af bagudgående eliminering. Optimering af modellen er optimering af datasættet, der bruges til træning af modellen. Modelens ydelse er direkte proportional med dens optimeringshastighed, der er afhængig af hyppigheden af betydelige data. Den baglængende eliminationsproces er ikke beregnet til at starte ændring fra nogen lavfrekvent predikator. Men det starter kun ændring fra højfrekvente data, fordi hovedsageligt modellens kompleksitet afhænger af denne del.

- Omgå overpassningen: Den alt for passende situation opstår, når modellen fik for mange datasæt, og der udføres klassificering eller forudsigelse, hvor nogle predikatorer fik støj fra andre klasser. I dette montering skulle modellen give uventet høj nøjagtighed. Ved overdreven montering kan modellen muligvis ikke klassificere variablen på grund af forvirring oprettet i logik på grund af for mange forhold. Den bagudgående elimineringsteknik begrænser det fremmede træk for at omgå situationen med overdreven montering.

2. Fald

Afgrænsninger for baglæns eliminering er som følger:

- I den baglængende eliminationsmetode kan man ikke finde ud af, hvilken predikator der er ansvarlig for afvisning af en anden predikator på grund af dens rækkevidde til ubetydelighed. For eksempel, hvis predikator X har en vis betydning, som var god nok til at opholde sig i en model efter tilføjelse af Y-predikatoren. Men betydningen af X bliver forældet, når en anden predikator Z kommer ind i modellen. Så den baglængende elimineringsalgoritme er ikke synlig om nogen afhængighed mellem to prediktorer, der sker i “Fremadvalgsteknikken”.

- Efter bortkastning af en funktion fra en model ved hjælp af en bagudgående eliminationsalgoritme, kan denne funktion ikke vælges igen. Kort sagt, eliminering af bagud har ikke en fleksibel tilgang til at tilføje eller fjerne funktioner / forudsigere.

- Normerne for at vælge signifikansværdien (0, 06) i modellen er ufleksible. Den bagudgående eliminering har ikke en fleksibel procedure til ikke kun at vælge, men også ændre den ubetydelige værdi som krævet for at hente den bedste pasform under et passende datasæt.

Konklusion

Backward-elimineringsteknikken indså, at modellen forbedrer ydeevnen og optimerer dens kompleksitet. Det bruges levende i flere regressioner, hvor modellen beskæftiger sig med det omfattende datasæt. Det er en nem og enkel tilgang i sammenligning med fremadvalg og krydsvalidering, hvor overbelastning af optimering er fundet. Den baglængende elimineringsteknik initierer eliminering af funktioner med højere betydning. Dets grundlæggende mål er at gøre modellen mindre kompleks og forbyde alt for passende situation.

Anbefalede artikler

Dette er en guide til tilbagestående eliminering. Her diskuterer vi, hvordan man anvender baglæns eliminering sammen med fordele og bagvær. Du kan også se på de følgende artikler for at lære mere-

- Hyperparameter-maskinlæring

- Klynge i maskinlæring

- Java Virtual Machine

- Uovervåget maskinlæring