Deep Learning Interview spørgsmål og svar

I dag ses Deep Learning som en af de hurtigst voksende teknologier med en enorm kapacitet til at udvikle en applikation, der er blevet betragtet som hård for nogen tid tilbage. Talegenkendelse, billedgenkendelse, finde mønstre i et datasæt, objektklassificering i fotografier, generering af karaktertekst, selvkørende biler og mange flere er blot et par eksempler, hvor Deep Learning har vist sin betydning.

Så du har endelig fundet dit drømmejob i Deep Learning, men spekulerer på, hvordan du knækker Deep Learning Interview og hvad der kan være de sandsynlige spørgsmål om Deep Learning Interview. Hver samtale er forskellig, og omfanget af et job er også anderledes. Med dette i tankerne har vi designet de mest almindelige Deep Learning Interview-spørgsmål og svar for at hjælpe dig med at få succes i dit interview.

Nedenfor er der nogle få Deep Learning Interview-spørgsmål, som ofte stilles i Interview og vil også hjælpe med at teste dine niveauer:

Del 1 - Interview om spørgsmål om dyb læring (grundlæggende)

Denne første del dækker grundlæggende Deep Learning Interview spørgsmål og svar

1. Hvad er dyb læring?

Svar:

Området med maskinlæring, der fokuserer på dybe kunstige neurale netværk, som løst er inspireret af hjerner. Alexey Grigorevich Ivakhnenko offentliggjorde den første general om at arbejde Deep Learning-netværk. I dag har det sin anvendelse inden for forskellige områder såsom computersyn, talegenkendelse, naturlig sprogbehandling.

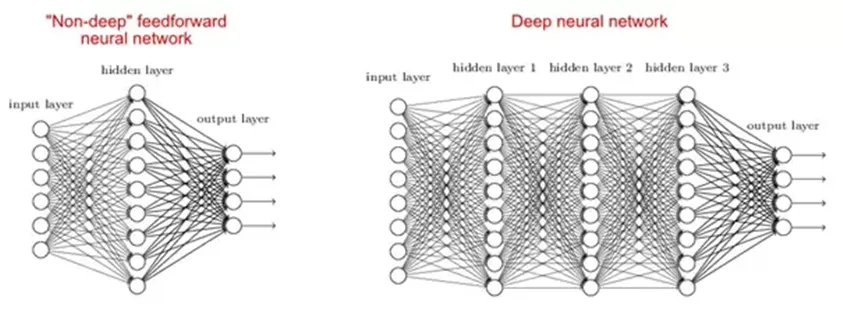

2. Hvorfor er dybe netværk bedre end lavvandet?

Svar:

Der er undersøgelser, der siger, at både lavt og dybt netværk kan passe til enhver funktion, men da dybe netværk har flere skjulte lag ofte af forskellige typer, så de er i stand til at opbygge eller udtrække bedre funktioner end lavvandede modeller med færre parametre.

3. Hvad er omkostningsfunktionen?

Svar:

En omkostningsfunktion er et mål for nøjagtigheden af det neurale netværk med hensyn til den givne træningsprøve og forventede output. Det er en enkelt værdi, ikke-vektor, da det giver ydeevnen på det neurale netværk som helhed. Det kan beregnes som nedenfor gennemsnitlig kvadratfunktion: -

MSE = 1nΣi = 0n (Y i-Yi) 2

Hvor Y og ønsket værdi Y er det, vi vil minimere.

Lad os gå til de næste spørgsmål om Deep Learning Interview.

4. Hvad er gradientafstamning?

Svar:

Gradient nedstigning er dybest set en optimeringsalgoritme, der bruges til at lære værdien af parametre, der minimerer omkostningsfunktionen. Det er en iterativ algoritme, der bevæger sig i retning af den stejleste nedstigning som defineret af det negative af gradienten. Vi beregner gradientafstamningen af omkostningsfunktionen for en given parameter og opdaterer parameteren med nedenstående formel: -

Θ: = Θ-αd∂ΘJ (Θ)

Hvor Θ - er parametervektoren, er α - indlæringshastighed, J (Θ) - en omkostningsfunktion.

5. Hvad er bagpropagering?

Svar:

Backpropagation er en træningsalgoritme, der bruges til et flerlagigt neuralt netværk. I denne metode flytter vi fejlen fra en ende af netværket til alle vægte inde i netværket og tillader således effektiv beregning af gradienten. Det kan opdeles i flere trin som følger:

Fremadrettet udbredelse af træningsdata for at generere output.

Derefter kan brug af målværdi og outputværdifejlderivat beregnes med hensyn til outputaktivering.

Derefter backpagneres vi til beregning af derivat af fejlen med hensyn til outputaktivering på tidligere og fortsætter dette for alle skjulte lag.

Brug af tidligere beregnede derivater til output og alle skjulte lag beregner vi fejlderivater med hensyn til vægte.

Og så opdaterer vi vægterne.

6. Forklar følgende tre varianter af gradientafstamning: batch, stokastisk og mini-batch?

Svar:

Stokastisk gradientafstigning : Her bruger vi kun et enkelt træningseksempel til beregning af gradient- og opdateringsparametre.

Batch Gradient Descent : Her beregner vi gradienten for hele datasættet og udfører opdateringen ved hver iteration.

Mini-batch Gradient Descent : Det er en af de mest populære optimeringsalgoritmer. Det er en variant af Stokastisk gradientafstamning, og her i stedet for et enkelt træningseksempel bruges mini-batch af prøver.

Del 2 - Spørgsmål om dyb læring (avanceret)

Lad os nu se på de avancerede spørgsmål om Deep Learning Interview.

7. Hvad er fordelene ved mini-batch gradientafstamning?

Svar:

Nedenfor er fordelene ved mini-batch gradientafstamning

• Dette er mere effektivt sammenlignet med stokastisk gradientafstamning.

• Generaliseringen ved at finde de flade minima.

• Mini-batches giver hjælp til at tilnærme gradienten af hele træningssættet, hvilket hjælper os med at undgå lokale minima.

8. Hvad er dataanormalisering, og hvorfor har vi brug for dem?

Svar:

Datanormalisering bruges under backpropagation. Hovedmotivet bag datalormalisering er at reducere eller eliminere dataredundans. Her omskalerer vi værdier for at passe ind i et specifikt interval for at opnå bedre konvergens.

Lad os gå til de næste spørgsmål om Deep Learning Interview.

9. Hvad er vægtinitialisering i neurale netværk?

Svar:

Vægtinitialisering er et af de meget vigtige trin. En dårlig vægtinitialisering kan forhindre, at et netværk lærer, men god vægtinitialisering hjælper med at give en hurtigere konvergens og en bedre samlet fejl. Biases kan generelt initialiseres til nul. Reglen for indstilling af vægtene er at være tæt på nul uden at være for lille.

10. Hvad er en automatisk indkoder?

Svar:

En autoencoder er en autonom maskinlæringsalgoritme, der bruger backpropagation-princippet, hvor målværdierne er indstillet til at være lig med de leverede input. Internt har det et skjult lag, der beskriver en kode, der bruges til at repræsentere input.

Nogle nøglefakta om autoencoderen er som følger: -

• Det er en uovervåget ML-algoritme, der ligner Principal Component Analysis

• Det minimerer den samme objektive funktion som analyse af hovedkomponent

• Det er et neuralt netværk

• Det neurale netværks måloutput er dets input

11. Er det OK at oprette forbindelse fra en Layer 4-udgang tilbage til en Layer 2-indgang?

Svar:

Ja, dette kan gøres i betragtning af at lag 4-output er fra det forrige tidstrin som i RNN. Vi er også nødt til at antage, at den forrige inputbatch undertiden er korreleret med den aktuelle batch.

Lad os gå til de næste spørgsmål om Deep Learning Interview.

12. Hvad er Boltzmann-maskinen?

Svar:

Boltzmann Machine bruges til at optimere løsningen af et problem. Boltzmann-maskinens arbejde er dybest set at optimere vægten og mængden for det givne problem.

Nogle vigtige punkter om Boltzmann Machine -

• Den bruger en tilbagevendende struktur.

• Det består af stokastiske neuroner, der består af en af de to mulige tilstande, enten 1 eller 0.

• Neuronerne i dette er enten i en adaptiv (fri tilstand) eller fastklemt (frosset tilstand).

• Hvis vi anvender simuleret udglødning på diskret Hopfield-netværk, ville det blive Boltzmann Machine.

13. Hvad er aktiveringsfunktionens rolle?

Svar:

Aktiveringsfunktionen bruges til at introducere ikke-linearitet i det neurale netværk, hvilket hjælper den med at lære mere komplekse funktioner. Uden som det neurale netværk kun ville være i stand til at lære lineær funktion, der er en lineær kombination af dens inputdata.

Anbefalede artikler

Dette har været en guide til Liste over Deep Learning Interview spørgsmål og svar, så kandidaten let kan nedbryde disse Deep Learning Interview spørgsmål. Du kan også se på de følgende artikler for at lære mere

- Lær de 10 mest nyttige HBase-interviewspørgsmål

- Nyttige maskinindlæringsspørgsmål og svar

- Top 5 mest værdifulde spørgsmål om datavidenskab

- Vigtige Ruby Interview spørgsmål og svar