Forskellen mellem Hadoop og MapReduce

Hadoops rødder går helt tilbage til året 2002, da Dough Cutting arbejdede på et open source-projekt ved navn Nutch (som blev brugt til at indeksere websiderne og bruge de indekserede websider til søgning, det samme som Google gør). Han stod over for skalerbarhedsspørgsmål både med hensyn til opbevaring og computing. I 2003 offentliggjorde Google GFS (google-filsystem), og i 2004 oprettede Nutch NDFS (Nutch distribueret filsystem). Efter at Google annoncerede MapReduce som deres beregningshjerne bag deres sorteringsalgoritmer, var Dough i stand til at køre Nutch på NDFS og brugte MapReduce i 2005 og i 2006 blev Hadoop født.

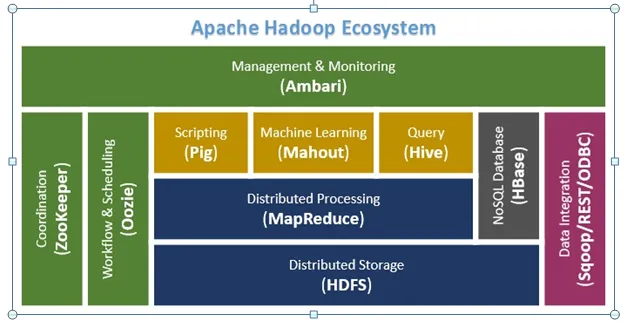

Hadoop og MapReduce! Hadoop er et økosystem med open source-projekter som Hadoop Common, Hadoop distribueret filsystem (HDFS), Hadoop YARN, Hadoop MapReduce. Hadoop er som sådan en open source ramme til lagring og behandling af enorme datasæt. Opbevaring udføres af HDFS, og behandlingen tages af MapReduce. MapReduce er på den anden side en programmeringsmodel, der giver dig mulighed for at behandle enorme data, der er gemt i Hadoop. Lad os forstå Hadoop og MapReduce i en detalje i dette indlæg.

Sammenligning mellem hoved og hoved mellem Hadoop mod MapReduce (Infographics)

Nedenfor er Top 5 sammenligningen mellem Hadoop vs MapReduce

Vigtige forskelle mellem Hadoop vs MapReduce

Følgende er forskellen mellem Hadoop og MapReduce

- Hvis vi ønsker at differentiere Hadoop og MapReduce i lægmandsbetingelser, kan vi sige det, Hadoop er som den bil, hvor du har alt, hvad der er nødvendigt for at rejse afstand, men MapReduce er som bilens motor, så uden en bil kan en motor ” t findes, men det ydre af bilen kan ændres (andre DFS (distribuerede filsystemer)).

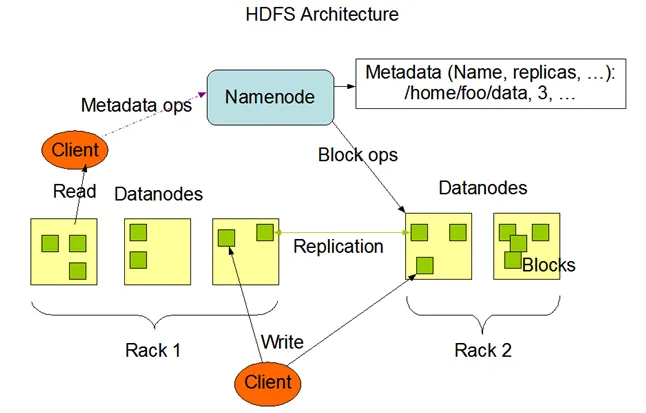

- Den grundlæggende idé bag Hadoop er, at dataene skal være pålidelige og skalerbare, pålidelige, da i tilfælde af en katastrofe eller netværksfejl skal dataene være tilgængelige hele tiden, og dette opnås ved Hadoops rammer ved hjælp af Navnekoder og Datakoder.

- Nogle grundlæggende idéer om datanoder og navneknudepunkter

- Den grundlæggende idé bag arkitekturen i dataknudepunktet og navneknudepunktet er master- / slavearkitekturen, hvor den ene gemmer placeringen af dataene (Navneknudepunkt) og den anden gemmer selve dataen (Dataknudepunkt). Dataene er opdelt i bunter på 64 MB og gemmes i datablokkene, og registreringsdatabasen for disse opretholdes på Navnekoden. Dataene replikeres tre gange som standard for pålidelighed. Når vi taler om skalerbarheden, kan hardware øges, mens du er på farten, og det hjælper med at øge lagringen og gøre systemet skalerbart.

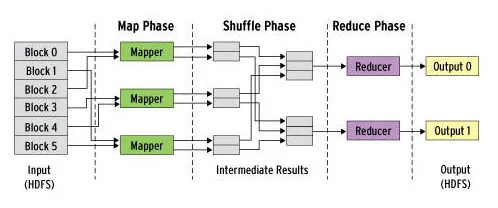

- Nu kommer til MapReduce der er tre faser

- Kortfase

- Bland fase

- Reducer fase

Lad os tage et eksempel for at forstå det bedre. MapReduce er en programmeringsramme har også et hej verdensprogram, men det er kendt som ordtællingsprogram i MapReduce.

Word Count-programmet giver os nøgleværdipar af ordet og dets hyppighed i et afsnit / artikel eller en hvilken som helst datakilde. For at være i stand til at forstå det let, lad os tage nedenstående som eksempeldata.

I datasættet, som vi kan se, har vi tre ord bus, bil og tog. Kolonnen med navnet Input har de data, som vi har i datasættet, kolonnen Output har dataene i det mellemliggende trin, hvor blandingen vil finde sted.

Her tager vi splitteren som komma (, ) for at opdele ordene. Opdeleren kan være komma eller mellemrum eller en ny linje osv.

| Input | Sæt med data | caR, BIL, bil, BUS, TOG, bus, tog, bus, TOG, BUS, buS, Bil, bus, bil, tog, bil, bus, bil |

| Produktion | Konverter til et andet datasæt

(Nøgle, værdi) | (Bus, 1), (Bil, 1), (bus, 1), (bil, 1), (tog, 1),

(bil, 1), (bus, 1), (bil, 1), (tog, 1), (bus, 1), (TOG, 1), (BUS, 1), (buS, 1), (caR, 1), (CAR, 1), (bil, 1), (BUS, 1), (TRAIN, 1) |

Og output fra ovennævnte mellemtrin er givet til reduceren, og nedenfor er den endelige output af programmet.

| Input

(output af kortfunktion) | Sæt med tuples | (Bus, 1), (Bil, 1), (bus, 1), (bil, 1), (tog, 1),

(bil, 1), (bus, 1), (bil, 1), (tog, 1), (bus, 1), (TOG, 1), (BUS, 1), (buS, 1), (caR, 1), (CAR, 1), (bil, 1), (BUS, 1), (TRAIN, 1) |

| Produktion | Konverteres til et mindre sæt tupler | (BUS, 7),

(CAR, 7), (TOG, 4) |

- En af de vigtigste forskelle i Hadoop med andre big data-behandlingsrammer er, at Hadoop sender koden (MapReduce-kode) til de klynger, hvor dataene er gemt i stedet for at sende dataene til kode, som datasættene vil i TB'er eller sommetider i PB'er det vil være en kedelig opgave at gøre.

Hadoop vs MapReduce sammenligningstabel

| Grundlag for sammenligning | Hadoop | MapReduce |

|

Betyder | Navnet “Hadoop” var navnet på legetøjselefanten til Doug Cuttings søn. Han udnævnte dette projekt til “Hadoop”, da det var let at udtale det. | Navnet "MapReduce" kom til i henhold til selve funktionaliteten ved kortlægning og reduktion i nøgleværdipar. |

|

Koncept | Apache Hadoop er et økosystem, der giver et miljø, der er pålideligt, skalerbart og klar til distribueret computing. | MapReduce er en submodule til dette projekt, som er en programmeringsmodel og bruges til at behandle enorme datasæt, der sidder på HDFS (Hadoop distribuerede filsystem). |

|

Forudsætninger | Hadoop kører på implementeringer HDFS (Hadoop Distribueret filsystem) | MapReduce kan køre på HDFS / GFS / NDFS eller et hvilket som helst andet distribueret filsystem, for eksempel MapR-FS |

|

Sprog | Hadoop er en samling af alle moduler og kan derfor også omfatte andre programmerings- / scripting-sprog | MapReduce er dybest set skrevet på Java-programmeringssprog |

|

Framework | Hadoop har ikke kun lagerrammer, der lagrer dataene, men skaber navneknudepunkter og dataknudepunkter, det har også andre rammer, der inkluderer MapReduce selv. | MapReduce er en programmeringsramme, der bruger en nøgleværdikortlægning til at sortere / behandle dataene |

Nedenstående figur vil hjælpe med at differentiere MapReduce fra Hadoop.

MapReduce Framework

- Som vi kan se af ovenstående billede, at MapReduce er en distribueret behandlingsramme, hvorimod Hadoop er en samling af alle rammer.

Konklusion - Hadoop vs MapReduce

Hadoop, der var open source, fik popularitet, da det var gratis at bruge, og programmererne kan ændre koden efter deres behov. Hadoop Eco-system blev udviklet kontinuerligt i de senere år for at gøre Eco-systemet så bugfrit som muligt.

Med verdens stadigt skiftende behov ændres teknologien hurtigt, og det bliver vanskeligt at holde styr på ændringerne. De data, der genereres om en måned, bliver fordoblet / tredoblet, når du læser denne artikel, og behovet for hurtigere behandling af datasæt førte til mange andre programmeringsrammer som MapReduce 2, Spark osv.

Anbefalede artikler

Dette har været en guide til Hadoop vs MapReduce, deres betydning, sammenligning mellem hoved og hoved, nøgleforskelle, sammenligningstabel og konklusion. Du kan også se på de følgende artikler for at lære mere -

- Forskellen mellem Hadoop vs Redshift

- Find ud af den 6 bedste forskel mellem Apache Hadoop vs Apache Storm

- Sammenligninger mellem Hadoop Vs SQL

- Vide om MapReduce vs Spark

- Hadoop vs Spark: Funktioner

- Laravel vs Codeigniter: Funktioner