Introduktioner til datavidenskabelige algoritmer

En beskrivelse på højt niveau af de væsentlige algoritmer, der bruges i Data Science. Som du allerede ved, er datavidenskab et studiefelt, hvor beslutninger træffes baseret på den indsigt, vi får fra dataene i stedet for klassiske regelbaserede deterministiske tilgange. Vi kan typisk opdele en maskinlæringsopgave i tre dele

- Indhentning af data og kortlægning af forretningsproblemet,

- Anvendelse af maskinlæringsteknikker og observering af præstationsmetrikken

- Test og implementering af modellen

I hele denne livscyklus bruger vi forskellige datalogi-algoritmer til at løse den aktuelle opgave. I denne artikel deler vi de mest almindeligt anvendte algoritmer baseret på deres læringstyper og vil have en diskussion på højt niveau om dem.

Typer af datavidenskabelige algoritmer

Baseret på indlæringsmetodologier kan vi simpelthen opdele maskinindlæring eller datavidenskabelige algoritmer i følgende typer

- Overvågede algoritmer

- Ikke-overvågede algoritmer

1. Overvågede algoritmer

Som navnet antyder overvågede algoritmer er en klasse af maskinlæringsalgoritmer, hvor modellen trænes med de mærkede data. Baseret på de historiske data vil du for eksempel forudsige, at en kunde vil misligholde et lån eller ej. Efter forarbejdning og funktionsudvikling af de mærkede data, trænes overvågede algoritmer over de strukturerede data og testes over et nyt datapunkt eller i dette tilfælde for at forudsige en låneafskedigelse. Lad os dykke ned i de mest populære overvågede maskinlæringsalgoritmer.

- K Nærmeste naboer

K nærmeste naboer (KNN) er en af de enkleste, men alligevel kraftige maskinlæringsalgoritmer. Det er en overvåget algoritme, hvor klassificeringen udføres baseret på k nærmeste datapunkter. Tanken bag KNN er, at lignende punkter er samlet i hinanden ved at måle egenskaberne for nærmeste datapunkter, vi kan klassificere et testdatapunkt. For eksempel løser vi et standard klassificeringsproblem, hvor vi ønsker at forudsige et datapunkt tilhører klasse A eller klasse B. Lad k = 3, nu tester vi 3 nærmeste datapunkt for testdatapunktet, hvis to af dem hører til klassen A vil vi erklære testdatapunktet som klasse A ellers klasse B. Den rigtige værdi af K findes gennem krydsvalidering. Det har en lineær tidskompleksitet, og kan derfor ikke bruges til applikationer med lav latens.

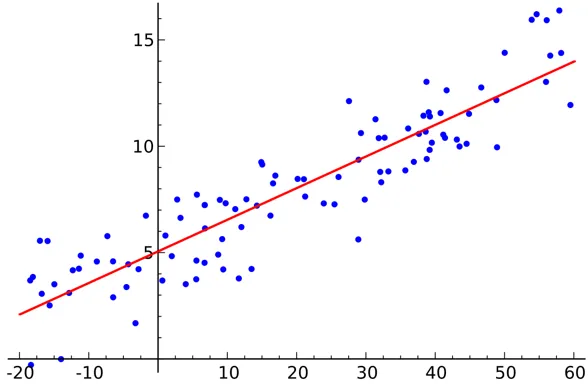

- Lineær regression

Lineær regression er en overvåget datavidenskabelig algoritme.

Produktion:

Variablen er kontinuerlig. Tanken er at finde et hyperplan, hvor det maksimale antal point ligger i hyperplanet. For eksempel er det at forudsige mængden af regn et standard regressionsproblem, hvor lineær regression kan bruges. Lineær regression antager, at forholdet mellem de uafhængige og afhængige variabler er lineær, og at der er meget lidt eller ingen multikollinearitet.

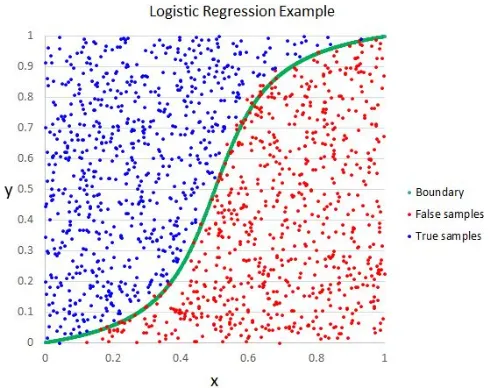

- Logistisk regression

Selvom navnet siger regression, er logistisk regression en overvåget klassificeringsalgoritme.

Produktion:

Den geometriske intuition er, at vi kan adskille forskellige klassetiketter ved hjælp af en lineær beslutningsgrænse. Outputvariablen for logistisk regression er kategorisk. Bemærk, at vi ikke kan bruge gennemsnitlig kvadratisk fejl som en omkostningsfunktion for logistisk regression, da den er ikke-konveks for logistisk regression.

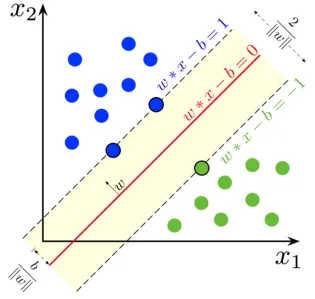

- Support vektormaskine

I logistisk regression var vores vigtigste motto at finde en adskilt lineær overflade.

Produktion:

Vi kan betragte supportvektormaskinen som en udvidelse af denne idé, hvor vi er nødt til at finde et hyperplan, der maksimerer margenen. Men hvad er en margen? For en vektor W (den beslutningsflade, vi har brug for), tegner vi to parallelle linjer på begge sider. Afstanden mellem disse to linjer kaldes margen. SVM antager, at dataene er lineært adskillelige. Selvom vi kan bruge SVM til ikke-lineære data også ved hjælp af Kernel-tricket.

- Beslutningstræ

Beslutningstræ er en indlejret If-Else-baseret klassifikator, der bruger en trælignende grafstruktur til at træffe beslutningen. Beslutningstræer er meget populære og en af de mest anvendte overvågede maskinlæringsalgoritmer inden for hele området videnskab. Det giver bedre stabilitet og nøjagtighed i de fleste tilfælde sammenlignet med andre overvågede algoritmer og robust over for outliers. Outputvariablen for beslutningstræet er normalt kategorisk, men den kan også bruges til at løse regressionsproblemer.

- ensembler

Ensembler er en populær kategori af datavidenskabelege algoritmer, hvor flere modeller bruges sammen for at få bedre ydelse. Hvis du er bekendt med Kaggle (en platform fra google til at øve og konkurrere inden for datavidenskabelige udfordringer), vil du finde de fleste vinderløsninger bruger en slags ensembler.

Vi kan grovt opdele ensembler i følgende kategorier

- afsækningskapacitet

- Øget

- Stacking

- Cascading

Random Forest, Gradient Boosting Decision Træer er eksempler på nogle populære ensemble-algoritmer.

2. Ikke-overvågede algoritmer

Ikke-overvågede algoritmer bruges til de opgaver, hvor dataene er ikke-mærket. Det mest populære anvendelsestilfælde af ikke-overvågede algoritmer er klynger. Clustering er opgaven med at gruppere lignende datapunkter uden manuel indgriben. Lad os diskutere nogle af de populære uovervågede maskinlæringsalgoritmer her

- K betyder

K Means er en randomiseret, ikke-overvåget algoritme, der bruges til gruppering. K Means følger nedenstående trin

1.Initialiser K-point tilfældigt (c1, c2..ck)

2. For hvert punkt (Xi) i datasættet

Vælg nærmeste Ci (i = 1, 2, 3..k)

Tilføj Xi til Ci

3. Beregn centroid ved hjælp af korrekte målinger (dvs. intracluster afstand)

4, Gentag trin (2) (3), indtil det konvergerer

- K betyder ++

Initialiseringstrinnet i K betyder er rent tilfældigt og baseret på initialiseringen ændres klyngen drastisk. K betyder ++ løser dette problem ved at initialisere k på en sandsynlig måde i stedet for ren randomisering. K betyder ++ er mere stabil end klassisk K betyder.

- K Medoids:

K-medoider er også en klynge-algoritme baseret på K-midler. Den største forskel mellem de to er centroiderne af K-midler, der ikke nødvendigvis findes i datasættet, hvilket ikke er tilfældet for K-medoider. K-medoider giver bedre tolkbarhed af klynger. K betyder minimerer den samlede firkantede fejl, mens K-medoider minimerer forskelligheden mellem punkter.

Konklusion

I denne artikel diskuterede vi de mest populære maskinlæringsalgoritmer, der bruges inden for datavidenskab. Efter alt dette kan et spørgsmål komme til dit sind, at ' Hvilken algoritme er den bedste? ” Der er helt klart ingen vinder her. Det afhænger udelukkende af den aktuelle opgave og forretningskrav. Som en bedste praksis starter altid med den enkleste algoritme og øger kompleksiteten gradvist.

Anbefalede artikler

Dette har været en guide til Data Science Algorithms. Her har vi diskuteret en oversigt over data science algoritmer og to typer data science algoritmer. Du kan også gennemgå vores givne artikler for at lære mere-

- Data Science Platform

- Data Science Sprog

- Klassificeringsalgoritmer

- Dataindvindingsalgoritmer

- Mest anvendte teknikker til ensemblæring

- Enkle måder at oprette beslutningstræ på

- Komplet guide til datavidens livscyklus