Introduktion til Hadoop fs kommandoer

I denne artikel vil vi gennemgå filhåndteringskommandoer for HADOOP, som bruges til at styre filerne gennem konsollen.

Du får brug for et Linux-system og den nyeste Hadoop-version. For at udskrive Hadoop-versionen, for at vide, ved hvem udgivelsen blev bygget, er testsummen kun nødt til at udføre nedenstående kommando efter login på Hadoop-platformen.

Kommando: Hadoop version

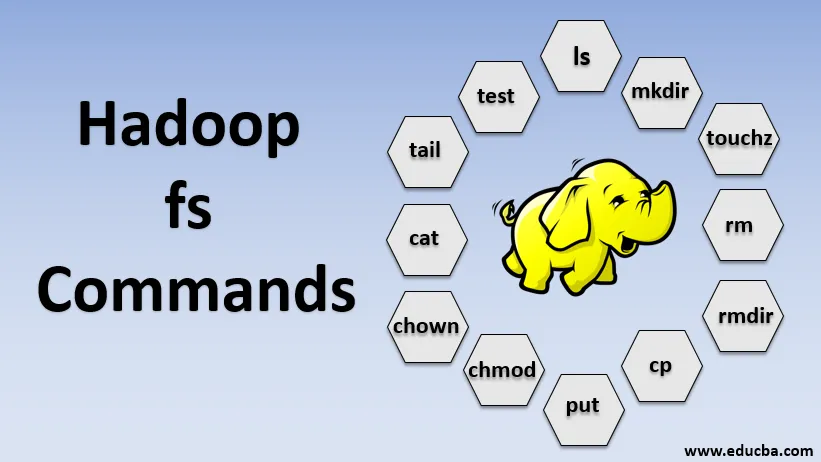

Kommandoer fra Hadoop fs

Lad os nu lære, hvordan du bruger HADOOP fs-kommandoer.

Vi starter med det grundlæggende. Skriv blot disse kommandoer i PUTTY eller en hvilken som helst konsol, du er tilpas med.

1. hadoop fs -ls

For et bibliotek returnerer det listen over filer og mapper, mens det for en fil returnerer statistikken på filen.

hadoop fs -lsr: dette er til rekursivt at liste over mapper og filer under specifikke mapper.

- Eksempel : hadoop fs -ls / eller hadoop fs -lsr

- -d: Dette bruges til at liste kataloger som almindelige filer.

- -h: Dette bruges til at formatere filstørrelserne på en menneskelig læsbar måde end blot antallet af bytes.

- -R: Dette bruges til rekursivt at liste over indhold i mapper.

2. hadoop fs -mkdir

Denne kommando tager stien som et argument og opretter mapper i hdfs.

- Eksempel : hadoop fs -mkdir / bruger / datahub1 / data

3. hadoop fs -ouchouch

Det opretter en tom fil og bruger ikke plads

- Eksempel: hadoop fs -ouchouch URI

4. hadoop fs -rm

Slet filer, der er angivet som argumentet. Vi skal specificere indstillingen -r for at slette hele biblioteket. Og hvis -skipTrash indstillingen er angivet, vil den springe papirkurven over, og filen slettes med det samme.

- Eksempel : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Det fjerner filer og tilladelser for mapper og undermapper. Grundlæggende er det den udvidede version af Hadoop fs-rm.

6. hadoop fs-cp

Den kopierer filen fra det ene sted til det andet

- Eksempel : hadoop fs -cp /user/data/abc.csv / bruger / datahub

7. hadoop fs-kopiFromLocal

Den kopierer filen fra edgenode til HDFS.

8. hadoop fs-output

Det kopierer filen fra edgenode til HDFS, den ligner den forrige kommando, men put læser også input fra standard input stdin og skriver til HDFS

- Eksempel : hadoop fs -put abc.csv / bruger / data

hadoop fs -put -p: Flaget bevarer adgangen, ændringstid, ejerskab og tilstanden.

hadoop fs -put -f: Denne kommando overskriver destinationen, hvis filen allerede findes før kopien.

9. hadoop fs -moveFromLocal

Det ligner kopi fra lokalt bortset fra at kildefilen slettes fra lokal edgenode, efter at den er kopieret til HDFS

- Eksempel : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Den kopierer filen fra HDFS til edgenode.

- Eksempel : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Denne kommando hjælper os med at ændre adgangen til en fil eller bibliotek

- Eksempel : hadoop fs -chmod (-R) (sti)

12. hadoop fs-chown

Denne kommando hjælper os med at ændre ejerskabet af en fil eller et bibliotek

- Eksempel : hadoop fs -chown (-R) (EJER) (:( GROUP)) PATH

13. hadoop fs -kat

Det udskriver indholdet af en HDFS-fil på terminalen

- Eksempel : hadoop fs -cat /user/data/abc.csv

14. hadoop fs-tail

Det viser den sidste KB af HDFS-filen til stdout

- Eksempel : hadoop fs-tail / in / xyzfile

15. hadoop fs-test

Denne kommando bruges til HDFS-filtestoperationer, den returnerer 0, hvis det er sandt.

- - e: kontrollerer, om filen findes.

- -z: kontrollerer, om filen er nul-længde

- -d / -f: kontrollerer, om stien er henholdsvis katalog / fil

Her diskuterer vi et eksempel i detaljer

- Eksempel : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Viser størrelser på filer og mapper, der er indeholdt i det givne bibliotek eller længden af en fil, hvis det er en fil

17. hadoop fs -df

Det viser ledig plads

18. hadoop fs-checkum

Returnerer kontrolsuminformationen for en fil

19. hadoop fs -getfacl

Det viser adgangskontrollisten (ACL'er) for den bestemte fil eller bibliotek

20. hadoop fs-antal

Det tæller antallet af mapper, filer og bytes under den sti, der matcher det specificerede filmønster.

21. hadoop fs -setrep

Ændrer replikationsfaktoren for en fil. Og hvis stien er et bibliotek, ændrer kommandoen replikationsfaktoren for alle filer under biblioteket.

- Eksempel : hadoop fs -setrep -R / bruger / datahub: det bruges til at acceptere bagudkapaciteten og har ingen effekt.

hadoop fs - setrep -w / user / datahub : venter på, at replikationen er afsluttet

22. hadoop fs -getmerge

Det sammenkæder HDFS-filer i kilden i den lokale destinationsfil

- Eksempel : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Tilføjer en enkelt kilde eller flere kilder fra det lokale filsystem til destinationen.

- Eksempel : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Det udskriver statistikkerne om filen eller kataloget.

- Eksempel : hadoop fs -stat (format)

Konklusion - Hadoop fs kommandoer

Så vi har gennemgået næsten alle de kommandoer, der er nødvendige til filhåndtering og se dataene inde i filerne. Du kan ændre dine filer og indtage data i Hadoop-platformen nu.

Anbefalede artikler

Dette er en guide til Hadoop fs kommandoer. Her diskuterer vi introduktionen til Hadoop fs kommandoer sammen med dens eksempel i detaljer. Du kan også se på de følgende artikler for at lære mere-

- Installer Hadoop

- Hadoop Værktøjer

- Hadoop Arkitektur

- Hadoop-komponenter

- Hadoop fs kommandoer