Introduktion til begrænset Boltzmann-maskine

Begrænset Boltzmann-maskine er en metode, der automatisk kan finde mønstre i data ved at rekonstruere vores input. Geoff Hinton er grundlæggeren af dyb læring. RBM er et overfladisk to-lags netværk, hvor det første er det synlige, og det næste er det skjulte lag. Hver enkelt knude i det synlige lag er knyttet til hvert enkelt knudepunkt i det skjulte lag. Begrænset Boltzmann-maskine betragtes som begrænset, fordi to noder i det samme lag ikke danner en forbindelse. En RBM er den numeriske ækvivalent til tovejsoversætter. I fremadstien modtager en RBM input og konverterer den til et sæt numre, der koder input. I den bageste bane tager det dette som et resultat og behandler dette sæt indgange og oversætter dem omvendt for at danne de tilbagetrækkede input. Et supertrænet netværk vil være i stand til at udføre denne omvendte overgang med høj ægthed. I to trin spiller vægt og værdier en meget vigtig rolle. De tillader RBM at afkode indbyrdes forhold mellem inputene og hjælper også RBM med at beslutte, hvilke inputværdier der er mest vigtige for at detektere de rigtige output.

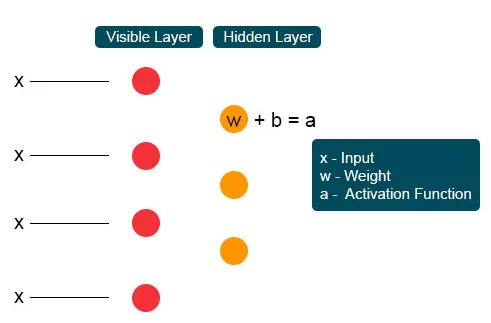

Arbejde med begrænset Boltzmann-maskine

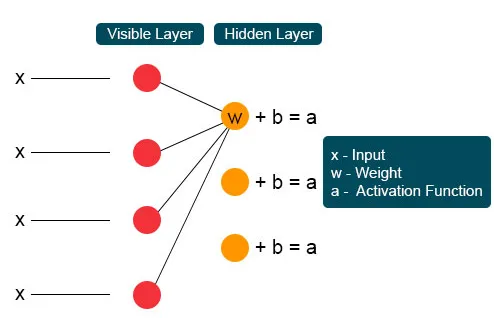

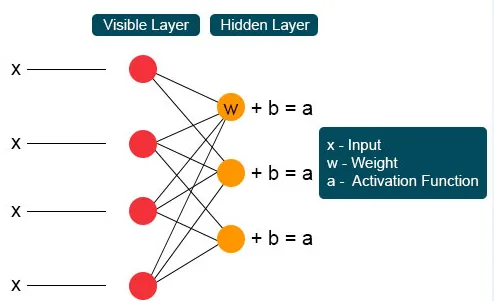

Hver enkelt synlige knude modtager en lavt niveau fra en knude i datasættet. Ved det første knudepunkt i det usynlige lag dannes X af et produkt af vægt og tilsættes til en forspænding. Resultatet af denne proces føres til aktivering, der producerer effekten af det givne indgangssignal eller nodens output.

I den næste proces ville flere indgange samles ved en enkelt skjult node. Hvert X kombineres af den individuelle vægt, tilføjelsen af produktet er bundet til værdier, og resultatet føres igen gennem aktivering for at give node output. Ved hvert usynligt knudepunkt kombineres hvert input X med individuel vægt W. Input X har tre vægte her, hvilket udgør tolv sammen. Vægten dannet mellem laget bliver en matrix, hvor rækker er nøjagtige til at indtaste knuder, og kolonner er tilfredse med outputnoder.

Hver usynlig knude får fire svar ganget med deres vægt. Tilsætningen af denne effekt føjes igen til værdien. Dette fungerer som en katalysator for, at en eller anden aktiveringsproces kan ske, og resultatet føres igen til aktiveringsalgoritmen, der producerer hvert enkelt output for hvert enkelt usynligt input.

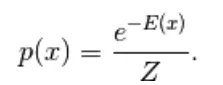

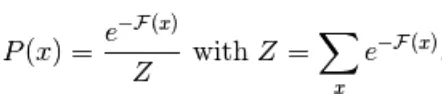

Den første model, der er afledt her, er den energibaserede model. Denne model knytter skalærenergi til enhver konfiguration af variablen. Denne model definerer sandsynlighedsfordelingen gennem en energifunktion som følger,

(1)

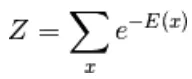

Her er Z den normaliserende faktor. Det er partitionsfunktionen med hensyn til fysiske systemer

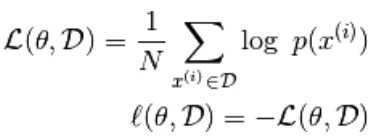

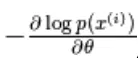

I denne energibaserede funktion følger en logistisk regression, at det første trin vil definere log-. sandsynlighed og den næste definerer tabsfunktion som en negativ sandsynlighed.

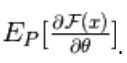

ved hjælp af den stokastiske gradient  hvor

hvor  er parametrene,

er parametrene,

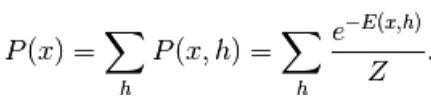

den energibaserede model med en skjult enhed defineres som 'h'

Den observerede del betegnes som 'x'

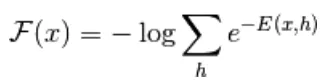

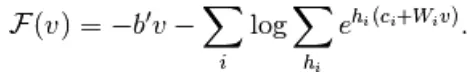

Fra ligning (1) defineres ligningen af fri energi F (x) som følger

(2)

(3)

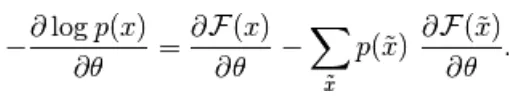

Den negative gradient har følgende form,

(4)

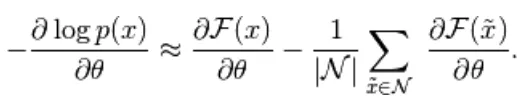

Ovenstående ligning har to former, den positive og negative form. Udtrykket positiv og negativ repræsenteres ikke af tegn på ligningerne. De viser virkningen af sandsynlighedstætheden. Den første del viser sandsynligheden for at reducere den tilsvarende frie energi. Den anden del viser reducerer sandsynligheden for genererede prøver. Derefter bestemmes gradienten som følger,

(5)

Her er N negative partikler. I denne energibaserede model er det vanskeligt at identificere gradienten analytisk, da den inkluderer beregningen af

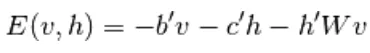

Derfor har vi i denne EBM-model lineær observation, som ikke er i stand til at skildre dataene nøjagtigt. Så i den næste model Begrænset Boltzmann Machine er det skjulte lag mere at have høj nøjagtighed og forhindre datatab. RBM-energifunktionen er defineret som,

(6)

Her er W vægtforbindelse mellem synlige og skjulte lag. b er forskudt på det synlige lag. c er forskudt på det skjulte lag. ved at konvertere til fri energi,

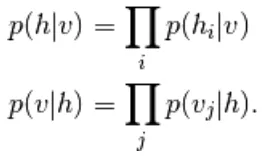

I RBM er enhederne i det synlige og skjulte lag helt uafhængige, hvilket kan skrives som følger,

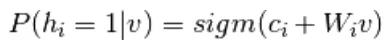

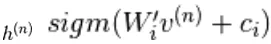

Fra ligning 6 og 2, en probabilistisk version af neuronaktiveringsfunktion,

(7)

(8)

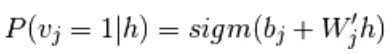

Det er yderligere forenklet til

(9)

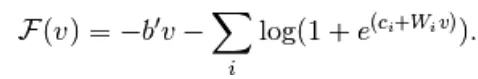

Kombination af ligning 5 og 9,

(10)

Prøveudtagning i begrænset Boltzmann-maskine

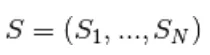

Gibbs-sampling af samlingen af N tilfældige variabler  udføres gennem en sekvens af N-sampling-undertrin i formularen

udføres gennem en sekvens af N-sampling-undertrin i formularen  hvor

hvor

indeholder  de andre tilfældige variabler i

de andre tilfældige variabler i  eksklusive.

eksklusive.

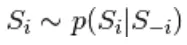

I RBM er S et sæt synlige og skjulte enheder. De to dele er uafhængige, som kan udføre eller blokere Gibbs-sampling. Her udfører synlig enhed sampling og giver fast værdi til skjulte enheder, samtidig skjulte enheder leverede faste værdier til den synlige enhed ved sampling

her,  er sæt af alle skjulte enheder.

er sæt af alle skjulte enheder.  Et eksempel

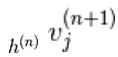

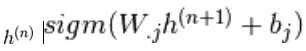

Et eksempel  er tilfældigt valgt til at være 1 (versus 0) med sandsynlighed,

er tilfældigt valgt til at være 1 (versus 0) med sandsynlighed,  og på lignende måde

og på lignende måde  er tilfældigt valgt til at være 1 (versus 0) med sandsynlighed

er tilfældigt valgt til at være 1 (versus 0) med sandsynlighed

Kontrastiv afvigelse

Det bruges som katalysator til at fremskynde prøveudtagningsprocessen

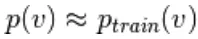

Da vi forventer at være sandt, forventer vi  fordelingsværdien skal være tæt på P, så den danner en konvergens til den endelige fordeling af P

fordelingsværdien skal være tæt på P, så den danner en konvergens til den endelige fordeling af P

Men kontrastiv afvigelse venter ikke på, at kæden konvergerer. Prøve opnås først efter Gibbs proces, så vi indstiller her k = 1, hvor det fungerer overraskende godt.

Vedvarende kontrastiv afvigelse

Dette er en anden metode til tilnærmelseseksempler. Det er en vedvarende tilstand for hver prøvetagningsmetode, det udtrækker nye prøver ved blot at ændre parametrene til K.

Lag med begrænset Boltzmann-maskine

Begrænset Boltzmann-maskine har to lag, lavvandede neurale netværk, der kombineres for at danne en blok af dybt tro-netværk. Det første lag er det synlige lag, og det andet lag er det skjulte lag. Hver enhed henviser til en neuronlignende cirkel kaldet en knude. Knuderne fra det skjulte lag er forbundet med knudepunkter fra det synlige lag. Men to noder med det samme lag er ikke forbundet. Her henviser udtrykket Begrænset til ingen intralaykommunikation. Hver knude behandler input og tager den stokastiske beslutning om at transmittere input eller ej.

eksempler

RBM's vigtige rolle er en sandsynlighedsfordeling. Sprog er unikke i deres bogstaver og lyde. Sandsynlighedsfordelingen af brevet kan være høj eller lav. På engelsk bruges bogstaverne T, E og A i vid udstrækning. Men på islandsk er de almindelige bogstaver A og N. Vi kan ikke forsøge at rekonstruere islandsk med en vægt baseret på engelsk. Det vil føre til divergens.

Det næste eksempel er billeder. Sandsynlighedsfordelingen af deres pixelværdi er forskellig for hver billedtype. Vi kan overveje, at der er to billeder Elephant and Dog for tow input nodes, RBM's fremadgang vil generere spørgsmål som skal jeg generere en stærk pixelknudepunkt for elefantknudepunkt eller hundeknudepunkt ?. Derefter genererer bagudpassage spørgsmål som for elefant, hvordan skal jeg forvente en fordeling af pixels? Derefter med fælles sandsynlighed og aktivering produceret af knudepunkter, vil de konstruere et netværk med fælles forekomst som store ører, gråt ikke-lineært rør, floppy ører, rynke er elefanten. Derfor er RBM processen med dyb læring og visualisering, de danner to vigtige partier og handler efter deres aktiverings- og genopbygningssans.

Fordele ved begrænset Boltzmann-maskine

- Begrænset Boltzmann-maskine anvendes algoritme, der bruges til klassificering, regression, emnemodellering, samarbejdsfiltrering og indlæring af funktioner.

- Begrænset Boltzmann-maskine bruges til neuroimaging, Sparse image rekonstruktion i mineplanlægning og også til radarmålgenkendelse

- RBM i stand til at løse ubalancerede dataproblemer ved hjælp af SMOTE-procedure

- RBM finder manglende værdier ved Gibb's sampling, der anvendes til at dække de ukendte værdier

- RBM overvinder problemet med støjende etiketter ved ikke-korrigerede etiketdata og dets rekonstruktionsfejl

- Ustrukturerede data er afhjulpet af funktionsekstraktor, der omdanner de rå data til skjulte enheder.

Konklusion

Dyb læring er meget magtfuld, hvilket er kunsten at løse komplekse problemer, det er stadig et rum til forbedring og komplekst at implementere. Gratis variabler skal konfigureres med omhu. Ideerne bag det neurale netværk var vanskelige tidligere, men i dag er dyb læring foden for maskinindlæring og kunstig intelligens. Derfor giver RBM et glimt af de enorme dybe læringsalgoritmer. Den beskæftiger sig med den grundlæggende kompositionenhed, der gradvist voksede ud til mange populære arkitekturer og bruges vidt i mange store industrier.

Anbefalet artikel

Dette har været en guide til den begrænsede Boltzmann-maskine. Her diskuterer vi dens arbejde, prøveudtagning, fordele og lag af begrænset Boltzmann-maskine. Du kan også gennemgå vores andre foreslåede artikler for at lære mere _

- Maskinlæringsalgoritmer

- Arkitektur til maskinlæring

- Typer af maskinlæring

- Værktøj til maskinindlæring

- Implementering af neurale netværk