Forskel mellem Små data og big data

Små data er intet andet end de data, der er små nok omfattende for mennesker i en mængde og også til formatering, der gør dem tilgængelige, informative og handlingsmæssige. Den traditionelle databehandling kan ikke omhandle store eller komplekse data, disse data kaldes Big Data. Når datavolumen vokser ud over en bestemt grænse, er traditionelle systemer og metoder ikke nok til at behandle data eller omdanne data til et nyttigt format. Dette er grunden til, at data generelt kategoriseres i to - Small Data vs Big Data

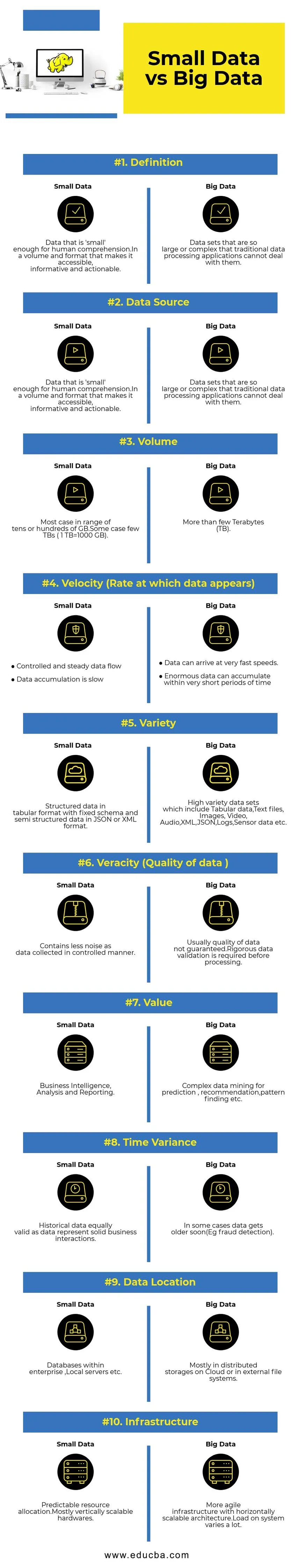

Sammenligning mellem hoved og hoved mellem små data kontra store data (Infographics)

Nedenfor er de 10 øverste forskelle mellem små data og store data

Vigtige forskelle mellem små data kontra store data

- Dataindsamling - Normalt er små data en del af OLTP-systemer og indsamlet på en mere kontrolleret måde og derefter indsat i cachelaget eller databasen. Databaser vil have læst kopier til understøttelse af øjeblikkelige analytiske forespørgsler, hvis det er nødvendigt. Big Data-indsamling pipeline vil have køer som AWS Kinesis eller Google Pub / Sub for at afbalancere data med høj hastighed. Nedstrøms vil have streaming-rørledninger til realtidsanalyse og batchjob til kold databehandling.

- Databehandling - Som de fleste af de små data, der genereres gennem transaktionssystemet, vil analyser ovenpå være batchorienteret det meste af tiden. I nogle sjældne tilfælde køres analytiske forespørgsler direkte oven på transaktionssystemer. Big Data-miljøer vil have både batch- og strømbehandlingsrørledninger. En stream bruges til realtidsanalyse, såsom registrering af kreditkortsvindel eller forudsigelse af aktiekurser. Batchbehandling brugt til implementering af kompleks forretningslogik med data og avancerede algoritmer.

- Skalerbarhed - Små datasystemer skaleres typisk lodret. Lodret skalering øger systemkapaciteten ved at tilføje flere ressourcer til den samme maskine. Lodret skalering er dyrt, men mindre kompleks at administrere. Big Data-systemer afhænger for det meste af horisontalt skalerbar arkitektur, der giver mere smidighed til en mindre pris. Forhindrende virtuelle maskiner, der er tilgængelige i skyen, gør vandret skalerbare systemer endnu mere overkommelige.

- Datamodellering - Små data, der genereres fra transaktionssystemer, vil være i normaliseret form.ETL (Extract Transform Load) datapipelinjer omdanner dem til stjerne- eller snefnugsskema i et datavarehus. Her håndhæves skema altid, mens du skriver data, som er relativt let, da data er mere struktureret. Som nævnt ovenfor er tabeldata kun en brøkdel af Big Data. Her replikeres data meget mere af forskellige årsager som overdragelse af fejl eller på grund af en vis begrænsning af den underliggende databasemotor (for eksempel understøtter nogle databaser kun et sekundært indeks pr. Datasæt). Et skema håndhæves ikke, når du skriver. I stedet valideres et skema under læsning af data.

- Storage & Computation Coupling - I traditionelle databaser, der for det meste håndterer Small Data, er lagring og computing tæt koblet. Indsættelse og hentning af data til og fra databasen kun mulig via den givne grænseflade. Data kan ikke sættes direkte i databasefilsystemet, eller eksisterende data kan ikke spørges ved hjælp af andre DB-motorer. Faktisk hjælper denne arkitektur i høj grad med at sikre dataintegritet. Big Data-systemer har meget løs kobling mellem opbevaring og beregning. Normalt gemmes data i et distribueret datalagringssystem som HDFS, AWS S3 eller Google GCS og beregner motoren til forespørgseldata eller vælger ETL på et senere tidspunkt. For eksempel kan interaktive forespørgsler udføres ved hjælp af Presto (Link) og ETL ved hjælp af Apache Hive på de samme data.

- Data Science - Maskinlæringsalgoritmer kræver inputdata i et godt struktureret og korrekt kodet format, og det meste af tiden inputdata kommer fra begge transaktionssystemer som et datalager og Big Data-lagring som en datasø. Maskinlæringsalgoritmer, der kun kører på Small Data, vil være let, da dataforberedelsestrinnet er smalt. Forberedelse og berigelse af data i Big Data-miljøet tager meget mere tid. Big Data giver mange muligheder for datavidenskabelig eksperimentering på grund af den store mængde og mangfoldighed af data.

- Datasikkerhed - Sikkerhedspraksis for små data, der er hjemmehørende i virksomheds datalager eller transaktionssystemer leveret af tilsvarende databaseudbydere, der muligvis inkluderer brugerrettigheder, datakryptering, hashing osv. At sikre Big Data-systemer er meget mere kompliceret og udfordrende. Bedste sikkerhedspraksis inkluderer kryptering af data ved hvile og transit, isolere klyngenetværk, stærke adgangskontrolregler osv.

Små data vs Big Data sammenligningstabel

| Grundlag for sammenligning | Små data | Big Data |

| Definition | Data, der er 'små' nok til menneskelig forståelse. I et volumen og et format, der gør dem tilgængelige, informative og handlingsmæssige | Datasæt, der er så store eller komplekse, at traditionelle databehandlingsapplikationer ikke kan håndtere dem |

| Datakilde | ● Data fra traditionelle virksomhedssystemer som ○ Planlægning af virksomhedsressourcer ○ Styring af kundeforhold (CRM) ● Finansielle data som hovedboksdata ● Betalingstransaktionsdata fra webstedet | ● Køb data fra salgsstedet ● Clickstream-data fra websteder ● GPS-strømdata - Mobilitetsdata sendt til en server ● Sociale medier - facebook, twitter |

| Bind | De fleste tilfælde inden for et interval af titusiner eller hundreder af GB. Nogle tilfælde få TB'er (1 TB = 1000 GB) | Mere end et par terabyte (TB) |

| Hastighed (hastighed, hvormed data vises) | ● Kontrolleret og stabil dataflyt ● Datakumulering er langsom | ● Data kan nå frem til meget hurtige hastigheder. ● Enorme data kan akkumuleres inden for meget korte tidsperioder |

| Bred vifte | Strukturerede data i tabelformat med fast skema og semistrukturerede data i JSON- eller XML-format | Datasæt af høj variation, der inkluderer tabulære data, tekstfiler, billeder, video, lyd, XML, JSON, logfiler, sensordata osv. |

| Veracity (kvalitet af data) | Indeholder mindre støj som data indsamlet på en kontrolleret måde. | Normalt er kvaliteten af data ikke garanteret. Der kræves streng datavalidering før behandling. |

| Værdi | Business Intelligence, analyse og rapportering | Kompleks dataudvikling til forudsigelse, anbefaling, mønsterfinding osv. |

| Tidsvariation | Historiske data, der er lige så gyldige som data, repræsenterer solide forretningsinteraktioner | I nogle tilfælde bliver data snart ældre (f.eks. Afsløring af svig). |

| Dataplacering | Databaser i en virksomhed, lokale servere osv. | Oftest i distribuerede lagre på Cloud eller i eksterne filsystemer. |

| Infrastruktur | Forudsigelig ressourcetildeling. Mest lodret skalerbar hardware | Mere smidig infrastruktur med en vandret skalerbar arkitektur. Belastningen på systemet varierer meget. |

Konklusion - Small Data vs Big Data

Det ultimative mål for dataanalyse for at få rettidig indsigt til støtte for beslutningstagning. Kategorisering af data i små og store hjælper med at tackle udfordringer med at analysere data fra hver verden separat med rigtige værktøjer. Linjen mellem to kategorier varierer med nye avancerede databehandlingssystemer, hvilket gør endda store dataforespørgsler meget hurtigere og mindre komplekse.

Anbefalede artikler:

Dette har været en guide til Small Data vs Big Data, deres betydning, sammenligning mellem hoved og hoved, nøgleforskelle, sammenligningstabel og konklusion. denne artikel indeholder alle de vigtige forskelle mellem små data og big data. Du kan også se på de følgende artikler for at lære mere -

- Big Data vs Data Science - Hvordan er de forskellige?

- Big Data: Vigtigt af sammenhæng mellem teknologi og forretningsanalyse

- Top 5 Big Data-tendenser, som virksomheder bliver nødt til at mestre

- 16 interessante tip til at slå Big data til Big Success