Introduktion til dataforarbejdning i maskinlæring

Dataforarbejdning i maskinlæring er en måde at konvertere data fra den rå form til en meget mere formateret, ubrugelig eller ønsket form. Det er en integreret opgave med maskinlæring, der udføres af dataforskeren. Da de indsamlede data er i et råt format, er det måske ikke muligt at træne modellen ved hjælp af dem. Det er vigtigt at behandle disse rå data omhyggeligt for at foretage en korrekt fortolkning af dem og til sidst undgå ethvert negativt resultat i forudsigelsen. Kort sagt, kvaliteten af vores indlæringsalgoritme afhænger meget af den type datasæt, vi brugte til at fodre modellen, så dataforarbejdning bruges til at opretholde denne kvalitet.

Data indsamlet til træning af modellen er fra forskellige kilder. Disse indsamlede data er generelt i deres rå format, dvs. de kan have lyde som manglende værdier og relevant information, numre i strengformatet osv. Eller de kan være ustrukturerede. Dataforbehandling øger effektiviteten og nøjagtigheden af maskinlæringsmodellerne. Da det hjælper med at fjerne disse lyde fra og datasættet og give mening til datasættet

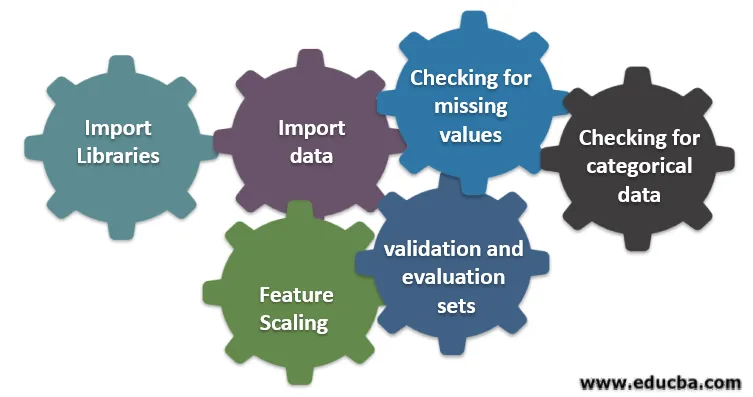

Seks forskellige trin, der er involveret i maskinlæring

Følgende er seks forskellige trin involveret i maskinlæring til udførelse af dataforbehandling:

Trin 1: Importer biblioteker

Trin 2: Importer data

Trin 3: Kontroller, om der mangler værdier

Trin 4: Kontroller for kategoriske data

Trin 5: Funktionsskalering

Trin 6: Opdeling af data i trænings-, validerings- og evalueringssæt

Lad os forstå hvert af disse trin i detaljer:

1. Importer biblioteker

Det allerførste trin er at importere et par af de vigtige biblioteker, der kræves i forforarbejdning af data. Et bibliotek er en samling af moduler, der kan kaldes og bruges. I python har vi en masse biblioteker, der er nyttige i forforarbejdning af data.

Et par af følgende vigtige biblioteker i python er:

- Numpy: Bruges mest biblioteket til implementering eller brug af kompliceret matematisk beregning af maskinlæring. Det er nyttigt til at udføre en operation på multidimensionelle arrays.

- Pandas : Det er et opensource-bibliotek, der leverer høj ydelse og brugervenlig datastruktur og dataanalyseværktøjer i python. Det er designet til at gøre arbejdet med relation og mærkede data let og intuitivt.

- Matplotlib: Det er et visualiseringsbibliotek, der leveres af python til 2D-plotter eller array. Det er bygget på en numpy matrix og designet til at arbejde med en bredere Scipy-stak. Visualisering af datasæt er nyttigt i det scenarie, hvor store data er tilgængelige. Plotter, der er tilgængelige i matplot lib, er linje, bjælke, spredning, histogram osv.

- Seaborn: Det er også et visualiseringsbibliotek, der er givet af python. Det giver et interface på højt niveau til at tegne attraktive og informative statistiske grafer.

2. Importer datasæt

Når bibliotekerne er importeret, er vores næste trin at indlæse de indsamlede data. Pandas-bibliotek bruges til at importere disse datasæt. Oftest findes datasættene i CSV-formater, da de har lav størrelse, hvilket gør det hurtigt til behandling. Så for at indlæse en csv-fil ved hjælp af read_csv-funktionen i pandas bibliotek. Forskellige andre formater af datasættet, der kan ses, er

Når datasættet er indlæst, er vi nødt til at inspicere det og se efter eventuel støj. For at gøre dette er vi nødt til at oprette en funktionsmatrix X og en observationsvektor Y med hensyn til X.

3. Kontroller for manglende værdier

Når du opretter funktionsmatrixen, kan du muligvis finde, at der er nogle manglende værdier. Hvis vi ikke håndterer det, kan det forårsage et problem på træningstidspunktet.

Der er to metoder til håndtering af de manglende værdier:

- Fjernelse af hele rækken, der indeholder den manglende værdi, men der kan være en mulighed for, at du kan ende med at miste nogle vigtige oplysninger. Dette kan være en god tilgang, hvis datasættets størrelse er stor.

- Hvis en numerisk kolonne har en manglende værdi, kan du estimere værdien ved at tage middelværdien, medianen, tilstand osv.

4. Kontroller for kategoriske data

Data i datasættet skal være i en numerisk form for at udføre beregning på det. Da maskinlæringsmodeller indeholder kompleks matematisk beregning, kan vi ikke give dem en ikke-numerisk værdi. Så det er vigtigt at konvertere alle tekstværdier til numeriske værdier. LabelEncoder () -klasse af indlært bruges til at konvertere disse kategoriske værdier til numeriske værdier.

5. Funktionsskalering

Værdierne på rådataene varierer ekstremt, og det kan resultere i partisk træning af modellen eller ende med at øge beregningsomkostningerne. Så det er vigtigt at normalisere dem. Funktionsskalering er en teknik, der bruges til at bringe dataværdien i et kortere interval.

Metoder, der bruges til funktionsskalering er:

- Omkalering (min-maks normalisering)

- Gennemsnitlig normalisering

- Standardisering (Z-score Normalisering)

- Skalering til enhedens længde

6. Opdeling af data i trænings-, validerings- og evalueringssæt

Endelig er vi nødt til at opdele vores data i tre forskellige sæt, træningssæt til at træne modellen, valideringssæt til validering af nøjagtigheden af vores model og endelig testsæt for at teste ydelsen af vores model på generiske data. Før opdelingen af datasættet er det vigtigt at blande datasættet for at undgå forudindtaster. En ideel andel til at opdele datasættet er 60:20:20 dvs. 60% som træningssæt, 20% som test- og valideringssæt. For at opdele datasættet skal du bruge train_test_split af sklearn.model_selection to gange. En gang for at opdele datasættet i tog- og valideringssæt og derefter opdele det resterende togdatasæt i tog- og testsæt.

Konklusion - Forforarbejdning af data i maskinlæring

Forforarbejdning af data er noget, der kræver praksis. Det er ikke som en simpel datastruktur, hvor du lærer og anvender direkte til at løse et problem. For at få god viden om, hvordan du renser et datasæt eller hvordan man visualiserer dit datasæt, skal du arbejde med forskellige datasæt.

Jo mere du bruger disse teknikker, jo bedre forståelse får du om det. Dette var en generel idé om, hvordan databehandling spiller en vigtig rolle i maskinlæring. Sammen med det har vi også set de trin, der er nødvendige til forforarbejdning af data. Så næste gang, før du går til at træne modellen ved hjælp af de indsamlede data, skal du sørge for at anvende forforarbejdning af data.

Anbefalede artikler

Dette er en guide til dataforarbejdning i maskinlæring. Her diskuterer vi introduktionen, seks forskellige trin, der er involveret i maskinlæring. Du kan også gennemgå vores andre foreslåede artikler for at lære mere–

- Betydningen af kunstig intelligens

- IoT-teknologi

- PL / SQL-datatyper

- Hive datatyper

- R Datatyper