Oversigt over tabsfunktioner i maskinlæring

Ligesom lærere guide os, uanset om vi klarer os godt i vores akademikere, udfører tabsfunktioner det samme arbejde. Det er en metode til at evaluere, hvor godt vores algoritme modellerer dataene. Tabsfunktioner er den vigtigste kilde til evaluering i moderne maskinlæring. Når du ændrer din algoritme for at forbedre din model, fortæller tabsfunktionsværdien dig, om du gør fremskridt eller ej. Vores primære mål bør være at reducere tabsfunktionen ved optimering. I denne artikel skal vi diskutere, hvordan tabsfunktioner fungerer og forskellige typer tabsfunktioner.

Hvordan fungerer tabsfunktioner?

Ordet 'Tab' angiver straffen for ikke at nå det forventede output. Hvis afvigelsen i den forudsagte værdi end forventet værdi af vores model er stor, giver tabsfunktionen det højere antal som output, og hvis afvigelsen er lille og meget tættere på den forventede værdi, afgiver den et mindre antal.

Her er et eksempel, når vi forsøger at forudsige huspriser i metrobyer.

| forudsagt

Salgspris (In lakh) | Faktiske

Salgspris (In lakh) | Afvigelse (tab) |

| Bangalore: 45 | 0 (Alle forudsigelser er korrekte) | |

| Pune: 35 | ||

| Chennai: 40 | ||

| Bangalore: 40 | Bangalore: 45 | 5 lakh til Bangalore, 2 lakh for Chennai |

| Pune: 35 | Pune: 35 | |

| Chennai: 38 | Chennai: 40 | |

| Bangalore: 43 | 2 lakh for Bangalore, 5 lakh for, Pune2 lakh for Chennai, | |

| Pune: 30 | ||

| Chennai: 45 |

Det er vigtigt at bemærke, at mængden af afvigelse ikke betyder noget, det, der betyder noget her, er, om den værdi, der er forudsagt af vores model, er rigtig eller forkert. Tabsfunktioner er forskellige baseret på din problemstilling, som maskinlæring anvendes. Omkostningsfunktionen er et andet udtryk, der bruges ombytteligt til tabsfunktionen, men det har en lidt anden betydning. En tabsfunktion er til et enkelt træningseksempel, mens omkostningsfunktion er det gennemsnitlige tab over det komplette togsæt.

Typer af tabsfunktioner i maskinlæring

Nedenfor er de forskellige typer tabsfunktion i maskinlæring, som er som følger:

1) Funktioner med regressionstab:

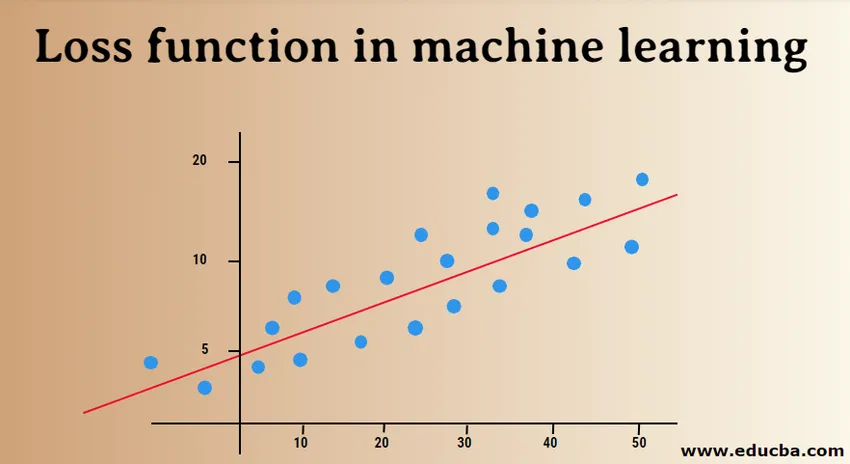

Lineær regression er et grundlæggende begreb for denne funktion. Funktioner med regressionstab etablerer et lineært forhold mellem en afhængig variabel (Y) og uafhængig variabel (X), og derfor forsøger vi at passe den bedste linje i rummet på disse variabler.

Y = X0 + X1 + X2 + X3 + X4 …. + Xn

X = Uafhængige variabler

Y = afhængig variabel

- Gennemsnitligt kvadratisk tab af fejl:

MSE (L2-fejl) måler den gennemsnitlige kvadratiske forskel mellem de faktiske og forudsagte værdier ved hjælp af modellen. Outputet er et enkelt tal, der er knyttet til et sæt værdier. Vores mål er at reducere MSE for at forbedre nøjagtigheden af modellen.

Overvej den lineære ligning, y = mx + c, vi kan udlede MSE som:

MSE = 1 / N ∑i = 1 til n (y (i) - (mx (i) + b)) 2

Her er N det samlede antal datapunkter, 1 / N ∑i = 1 til n er middelværdi og y (i) er den aktuelle værdi og mx (i) + b dens forudsagte værdi.

- Gennemsnitlig firkantet logaritmisk fejltab (MSLE):

MSLE måler forholdet mellem faktisk og forudsagt værdi. Det introducerer en asymmetri i fejlkurven. MSLE bekymrer sig kun om procentvis forskel mellem faktiske og forudsagte værdier. Det kan være et godt valg som en tabsfunktion, når vi vil forudsige huspriser, huspriser og bageri, og dataene er kontinuerlige.

Her kan tabet beregnes som middelværdien af observerede data for de kvadratiske forskelle mellem de logtransformerede faktiske og forudsagte værdier, som kan gives som:

L = 1nnΣi = 1 (log (y (i) + 1) -log (y (i) + 1)) 2

- Gennemsnitlig absolut fejl (MAE):

MAE beregner summen af absolutte forskelle mellem faktiske og forudsagte variabler. Det betyder, at den måler den gennemsnitlige størrelse af fejl i et sæt forudsagte værdier. Det er lettere at bruge den gennemsnitlige firkantede fejl, men at bruge den absolutte fejl er mere robust over for outliers. Outliers er disse værdier, der afviger meget fra andre observerede datapunkter.

MAE kan beregnes som:

L = 1nnΣi = 1||y (i) - y (i) ||

2) Binære klassifikationstabsfunktioner:

Disse tabsfunktioner er lavet til at måle præstationerne i klassificeringsmodellen. I dette tildeles datapunkter en af etiketterne, dvs. enten 0 eller 1. Yderligere kan de klassificeres som:

- Binær krydsantropi

Det er en standardtabsfunktion til binære klassificeringsproblemer. Kryds-entropitab beregner ydeevnen for en klassificeringsmodel, der giver et output med en sandsynlighedsværdi mellem 0 og 1. Kryds-entropitab stiger, når den forudsagte sandsynlighedsværdi afviger fra den faktiske etiket.

- Hængselstab

Hængselstab kan bruges som et alternativ til krydsentropi, som oprindeligt blev udviklet til brug med en understøtningsvektor-maskinalgoritme. Hængselstab fungerer bedst med klassificeringsproblemet, fordi målværdier er i sættet (-1, 1). Det giver mulighed for at tildele mere fejl, når der er en forskel i tegn mellem faktiske og forudsagte værdier. Dette resulterer i bedre ydeevne end krydsentropi.

- Kvadratisk hængselstab

En udvidelse af hængsletab, som simpelthen beregner kvadratet for hængsletabets score. Det reducerer fejlfunktionen og gør det numerisk lettere at arbejde med. Den finder klassificeringsgrænsen, der specificerer den maksimale margen mellem datapunkterne for forskellige klasser. Kvadratisk hængselstap passer perfekt til JA ELLER INGEN slags beslutningsproblemer, hvor sandsynlighedsafvigelse ikke er bekymringen.

3) Multi-class klassifikationstabsfunktioner:

Multiklasse klassifikation er de forudsigelige modeller, hvor datapunkterne er tildelt til mere end to klasser. Hver klasse tildeles en unik værdi fra 0 til (Number_of_classes - 1). Det anbefales stærkt til billed- eller tekstklassificeringsproblemer, hvor enkelt papir kan have flere emner.

- Cross-Entropy i flere klasser

I dette tilfælde er målværdierne i sæt 0 til n dvs. (0, 1, 2, 3 … n). Det beregner en score, der tager en gennemsnitlig forskel mellem faktiske og forudsagte sandsynlighedsværdier, og scoren minimeres for at nå den bedst mulige nøjagtighed. Multiklasse tværantropi er standardtabsfunktionen til tekstklassificeringsproblemer.

- Sparsom multiklasse tværantropi

En varm kodningsproces gør multiklasse krydsentropi vanskeligt at håndtere et stort antal datapunkter. Sparsom krydsentropi løser dette problem ved at udføre beregningen af fejl uden at bruge en varm kodning.

- Kullback Leibler Divergenstab

KL-divergenstab beregner divergensen mellem sandsynlighedsfordeling og basislinjefordeling og finder ud af, hvor meget information der går tabt i form af bits. Outputet er en ikke-negativ værdi, der specificerer, hvor tæt to sandsynlighedsfordelinger er. For at beskrive KL-divergens med hensyn til sandsynlighedssyn anvendes sandsynlighedsforholdet.

I denne artikel forstod vi oprindeligt, hvordan tabsfunktioner fungerer, og derefter fortsatte vi med at udforske en omfattende liste over tabsfunktioner med brugte caseeksempler. Det er dog mere fordelagtigt at forstå det praktisk, så prøv at læse mere og implementere det. Det vil afklare dine tvivl grundigt.

Anbefalede artikler

Dette er en guide til tabsfunktioner i maskinlæring. Her diskuterer vi, hvordan fungerer tabsfunktioner og typerne af tabsfunktioner i maskinlæring. Du kan også se på de følgende artikler for at lære mere -

- Metoder til maskinindlæring

- Introduktion til maskinlæring

- Big Data Technologies

- Big Data Analytics-software

- Lær kategorierne om hyperparameter

- Maskinlæring livscyklus | Top 8 faser