Sådan installeres Hive?

Apache Hadoop er en samling af de rammer, der giver mulighed for behandling af big data distribueret over klyngen. Pr. Apache Hive er et datalager-softwareprojekt bygget oven på Apache Hadoop til levering af dataforespørgsel og analyse. Apache hive giver SQL-lignende interface til forespørgsel og behandling af en stor mængde data kaldet HQL (Hive-forespørgselssprog). Apachehive kører oven på Hadoop-økosystemet, og de data, der er gemt i form af fil, betyder Hadoop distribueret filsystem (HDFS). Apache Hive giver en stor grænseflade for brugeren til at få adgang til og udføre en operation på dataene i form af en tabel, den giver god optimeringsteknik for at forbedre ydelsen. Det er meget udfordrende at gøre forespørgslen hurtigere med big data og tro mig, det betyder noget i et produktionsmiljø.

I backend konverterer compiler HQL-forespørgsel til kortreducerende job og sendes derefter til Hadoop-rammerne til henrettelser.

Forskel mellem Hive og SQL

Apache Hive ligner meget SQL, men som vi ved, kører hive oven på Hadoop-økosystemet og internt konverterer job til MR (Map Reduce jobs), det gør en vis forskel mellem Hive og SQL.

Hive ville ikke være den bedste tilgang til de applikationer, hvor der kræves meget hurtig respons, og det er meget vigtigt at forstå, at Hive er bedre egnet til batchbehandling over meget store sæt uforanderlige data, og vi skal bemærke, at Hive er en almindelig RDBMS og sidst men ikke mindst er apachehive skema i læseorganer (mens du indsætter data i hive-tabellen, vil den ikke bekymre sig om datatypeforstyrrelse, men under læsning af data viser den nulværdi, hvis datatypen ikke stemmer overens med den specifikke kolonnes datatype).

Forudgående krav til installation af Hive

Som jeg sagde tidligere, er det meget vigtigt at forstå Apache-bikupekørsler oven på Hadoop Ecosystem, og Hadoop skulle være i gang med alle dæmoner.

Nogle af de grundlæggende Hadoop-dæmoner er som følger:

- Navneknap

- Dataknudepunkt

- Ressource manager

- Node manager

For at kontrollere Hadoop-version nedenfor er kommandoen:

Skriv → Hadoop-version i kommandoprompten, det giver dig versionen af Hadoop.

Sådan kontrolleres udløseren af Hadoop-klyngerapporten nedenfor:

Skriv → Hadoop dfsadmin - Rapporter i kommandoprompten, det giver dig hele klyngerapporten, hvis din server kører.

Hvis Hadoop ikke er installeret på din maskine, der beder dig om at følge apache-instruktionen for at installere Hadoop på dit system.

Jeg håber, at java allerede er installeret på dit system. for at kontrollere java-version henvises til nedenfor skærmbillede.

Trin til at installere Hive på Ubuntu

Nedenfor er trinnene til at installere Hive på Ubuntu som følger:

Trin 1 : Hive-tjære, vi kan downloade ved hjælp af kommandoen nedenfor i terminalen, som vi også kan downloade direkte fra terminalen.

Kommando: vi får http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz

Trin 2 : Ekstraher tjærefilen ved hjælp af kommandoen nedenfor i terminalen. Vi kan udtrække tjæren over downloadet tarhive-tarefil direkte.

Kommando: tar -xzf apache-hive-2.1.0-bin.tar.gz

Jeg vil foreslå, at du verificerer med ls- kommandoen om udpakket bikivefil.

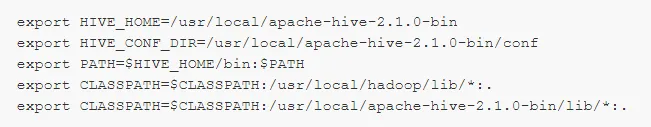

Trin 3: Rediger filen " .bashrc " for at opdatere miljøvariablerne for brugeren.

Kommando: sudo .bashrc

Tilføj følgende i slutningen af filen:

# Indstil HIVE_HOME

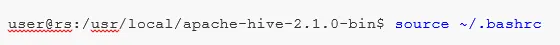

Udfør kommandoen nedenfor for at afslutte ændringsarbejdet i den aktuelle terminal.

Kommando: kilde .bashrc

Trin 5 : Vi er nødt til at oprette Hive-kataloger inden for HDFS-placering, og dette katalog 'lager', det vil være stedet at gemme metadatarelaterede oplysninger om bikupetabeller og data relateret til Hive.

Kommando :

- hdfs dfs -mkdir -p / bruger / hive / lager

- hdfs dfs -mkdir / tmp

Trin 6 : Sådan indstiller du læse- og skrivetilladelse til bikupetabel udfør kommando nedenfor.

Kommando:

I kommandoen nedenfor, der giver skrivetilladelse til brugergruppen:

- hdfs dfs -chmod g + w / bruger / hive / lager

- hdfs dfs -chmod g + w / tmp

Konfiguration af Hive: Det er meget vigtigt at pege på installere hive til at konfigurere med Hadoop. Vi er nødt til at redigere hive-env.sh, en fil, der er placeret i biblioteket $ HIVE_HOME / conf. Følgende kommandoer omdirigerer til mappen Hive conf og kopier skabelonfilen:

Trin 7 : Indstil en Hadoop- sti i hive-env.sh

Rediger filen hive-env.sh ved at tilføje følgende linje:

Nu med denne proces er vi næsten færdige, og installationen af bikuben er afsluttet med succes, det er vigtigt at konfigurere Metastore med den eksterne databaseserver, og som standard bruger Apache Hive framework Derby-databasen. Ved at bruge nedenstående kommando Initialisering af Derby-databasen.

Kommando: bin / schematool -initSchema -dbType derby

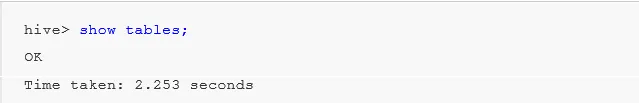

Trin 8 : Start Hive .

Kommando: bikive (skriv korf i terminalen inden for den anden kinketerminal åbnes.)

Arbejde med Hive: Nu ser vi nogle af operationerne i bikuben for at se, hvor mange tabeller vi har i standard databasebrug, se nedenfor skærmbilleder i nedenstående skærmbilleder, det viser ikke nogen tabeller, betyder at vi ikke har nogen tabeller i standarddatabasen .

For at oprette en tabel i bikuben er det meget vigtigt at henvise til den krævede database, ellers vil enhver tabel blive oprettet under standarddatabasen.

Vigtige kommandoer i Hive

1: Vis databaser (det viser alle databaser, der er oprettet indtil nu).

2: Opret databasen, hvis der ikke findes mydb (denne kommando opretter en database med navnet ' mydb', hvis ' mydb' ikke findes, og hvis ' mydb allerede findes, giver den heller ikke nogen fejl')

3: Brug databasen, når vi skal bruge nogle DDl-kommandoer i den bestemte database, vi skal bruge kommandoen "brug database" i vores tilfælde har vi allerede oprettet "mydb" vis kommando ville blive brugt mydb.

Vigtig Hive DDL-kommando

Opret, dråbe, køre, vise, beskrive .

- Opret : - Opret en sætning, der bruges til at oprette en database eller oprette en tabel i hive.

Eksempel: hive> Opret database Company; (database oprette)

Hive> brug Company;

Hive> opret bordmedarbejder (id int, navn streng, løn streng); (dette vil oprette tabelmedarbejder under database Company, fordi vi allerede har udført kommandoen Use database.)

- Beskriv giver information om skemaet i tabellen.

Hive> beskrive medarbejder; (dette giver skemaoplysningerne om medarbejderbordet i detaljer)

- TRUNCATE sletter dataene i tabellen.

Hive> afkort bordmedarbejder;

Vi kan også installere Hive i et vindue, men for bedste praksis foretrækker jeg Ubuntu at bruge, det vil give et bedre overblik over produktionsmiljøet, og dine data vil stige i fremtiden, det vil være let at administrere.

Anbefalede artikler

Dette har været en guide til Install Hive. Her har vi drøftet de forskellige trin til installation af Hive, DDL-kommando osv. Du kan også se på følgende artikler for at lære mere:

- Sådan installeres SQL Server

- Sådan installeres MATLAB

- Hive-kommandoer og funktion

- Grundlæggende spørgsmål om Hive-interview

- Hive Arkitektur | Workflow

- Brug af ORDER BY-funktion i Hive

- Hive installation