Introduktion til Hadoop Schedulers

Når vi taler om Hadoop, er den første ting, der dukker op, big data. Men har vi nogensinde spekuleret på, at Hadoop i sig selv ikke kun er en teknologi, men i stedet omfatter mange værktøjer og teknikker inde i det, så hvordan kan vi nøjagtigt opnå det, der er beregnet til via Hadoop automatisk. Svaret på dette spørgsmål er ved at bruge Hadoop-planlægere.

Det muliggør et højt behandlingsniveau af systemet og er også kendt som det generelle system, der fungerer på distributionsniveauet for et sæt data og information. Det er et multitasking-system, der bruges til at behandle flere datasæt for mange brugere og job samtidig. Tidligere blev kun en scheduler brugt til alle opgaver, men nu er Hadoop-planlægere dem, der bruges sammen med JobTracker-logik og understøttes også af Hadoop.

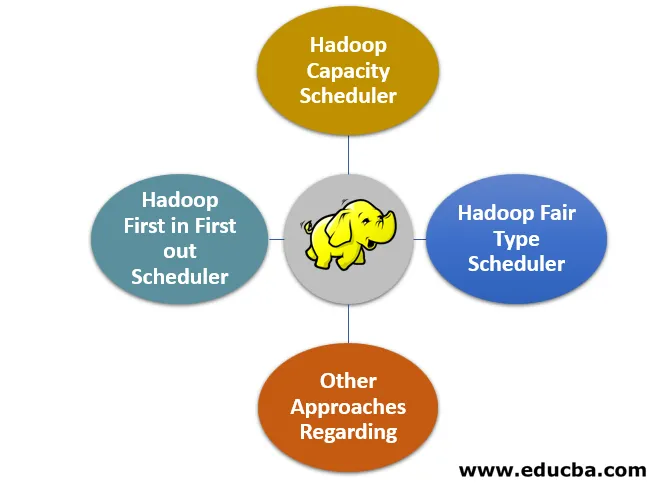

Top 4 Hadoop Schedulers typer

Der er flere typer Hadoop-planlægere, som vi ofte bruger:

1. Hadoop First in First out Scheduler

- Som navnet antyder, er dette en af de ældste jobplanlægere, der fungerer efter princippet om først ind og først ud. Grundlæggende, når vi taler om processen som JobTracker, taler vi om at trække job fra køen, som ofte siges at være arbejdskøen.

- I henhold til den arbejdskø er det job, der er det ældste, dvs. det, der har været det første, det, der også er det første, der bliver udført.

- Dette blev altid antaget at være en meget enklere tilgang end andre planlægningsteknikker, og derfor blev der ikke tænkt meget på at skrabe denne teknik kun for at finde nyere tilgange med bedre planlægningsmuligheder, da de også indeholdt begreber i størrelse og prioritering af jobbet.

2. Hadoop Kapacitetsplanlægning

- Hadoop Capacity scheduler er mere eller mindre som FIFO-metoden bortset fra at den også gør brug af at prioritere jobbet. Denne indtager en lidt anden tilgang, når vi taler om planlægningen af flere brugere.

- Denne er kendt for at planlægge og simulere en separat MapReduce-klynge for hver organisation eller bruger, og som udføres sammen med FIFO-type plan.

3. Hadoop Fair Type Scheduler

- Når der er behov for at tilvejebringe en separat og rimelig mængde klynlekapacitet med tid og periode, bruger vi Hadoop messeplanlægning. Det er nyttigt at få alle klynger, selvom et bestemt job er i kørende tilstand.

- Desuden leveres alle de gratis slots i klyngen til alle job på en sådan måde, at hver bruger får en normaliseret andel af deres klyngs del, efterhånden som flere job bliver nyttige til at blive sendt.

- Hvis der er den pulje, der endnu ikke har modtaget deres del af den fair andel og en normaliseret andel i en rimelig god tid og periode, kommer præference i spil og dermed dræber alle de samlede opgaver og løber med kapacitet til at levere disse puljer slots til at køre under kapacitet.

- Desuden er dette også kendt som bidragsmodulet, hvilket betyder, at ved at kopiere Hadoop's kontrol- og fair scheduler-baserede bibliotek til det lib-baserede bibliotek og placere JAR-filen på det passende sted, kan denne planlægningsteknik aktiveres. Det eneste, der skal gøres, er at indstille egenskaberne for opgaveskedleren til mapred.FairScheduler.

4. Andre tilgange vedrørende planlægning

- Hadoop sikrer at tilbyde en bestemmelse om at levere virtuelle klynger, hvilket betyder, at behovet for at have fysiske faktiske klynger kan minimeres, og denne teknik kaldes HOD (Hadoop on Demand).

- Den bruger den drejningsmomentbaserede ressourceadministrator til at holde knudepunkterne op og dens tildeling efter den virtuelle klyngs krav.

- Det bruges til at initialisere belastningen og systemet, der er baseret på de særlige knudepunkter inde i den virtuelle og ikke fysiske klynge og også sammen med de tildelte noder, først når konfigurationsfilerne er klargjort automatisk.

- HOD-klyngen kunne også bruges på en relativt meget uafhængig måde, når initialiseringen er fundet. I et nøddeskal er en nøddeskalsmodel, der bruges til implementering af disse store Hadoop-klynger, inden for skyinfrastrukturen, og det er hvad der kaldes HOD. Det deler et mindre antal noder relativt og giver derfor en større sikkerhed.

Betydningen af at bruge Hadoop-planlæggere

- Fra typerne af Hadoop-planlæggere skal det være klart, hvor vigtigheden af at bruge disse Hadoop-planlæggere ligger. Hvis du kører en stor klynge, der har forskellige jobtyper, forskellige prioriteter og størrelser sammen med flere klienter, skal du vælge den rigtige type Hadoop-planlægning til at blive vigtig.

- Dette er vigtigt, da det sikrer den garanterede adgang til det uudnyttede kapacitetsniveau og optimal udnyttelse af ressourcerne ved at prioritere jobene effektivt inden for køerne. Selvom denne del af Hadoop-planlæggerne er relativt let, da det at bruge fair schedulere stort set er det rigtige valg, hvis der er en forskel mellem antallet og typer klynger, der kører inden for en enkelt organisation.

- Denne fair planlægning kan stadig bruges til at levere og ikke-ensartet distribuere poolkapacitet af job, og det udføres på en meget enklere og konfigurerbar måde. Den fair planlægning redder os også, når vi taler om tilstedeværelsen af forskellige former for job, da det kan bruges til at give højere responstider for relativt mindre job, der er blandet med de større typer job, og støtten til disse er inkluderet i interaktiv brug af modeller.

- Kapacitetsplanlægere er nyttige, når du er mere bekymret for køerne i stedet for niveauet for oprettede puljer og også det konfigurerbare niveau på kortet og reducerer jobtypeautomater er tilgængelige, og køen har råd til at få en garanteret kapacitet i klyngen.

Konklusion

I dette indlæg læser vi om Hadoop-planlæggerne, deres betydning, introduktion, typer af Hadoop-planlæggere, deres funktioner og lærte også om betydningen af disse Hadoop-planlæggere. Når man forholder sig til big data-økosystemet og miljøet, er Hadoop-planlæggere noget, som man ofte ikke taler om, men har den største betydning og ikke har råd til at blive efterladt som den er. Håber du kunne lide vores artikel.

Anbefalede artikler

Dette er en guide til Hadoop Schedulers. Her diskuterer vi introduktionen og top 4 typer Hadoop scheduler med vigtigheden af at bruge den. Du kan også se på de følgende artikler for at lære mere-

- Svingkomponenter i Java

- JTabbedPane i Java

- Beskyttet nøgleord i Java

- JTextArea i Java