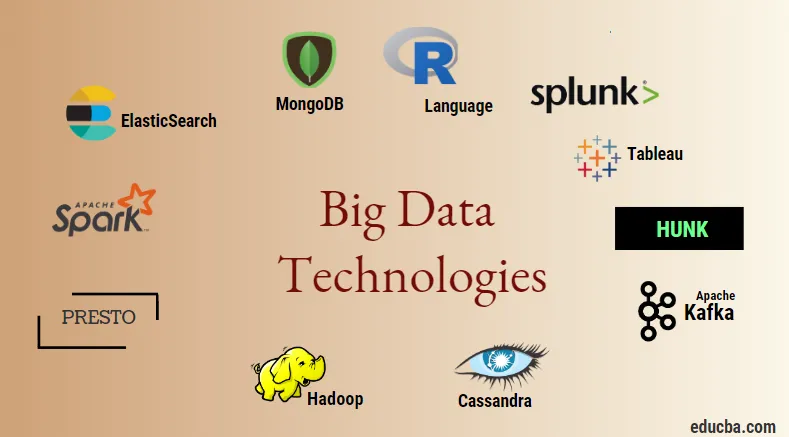

Introduktion til Big Data Technologies

Big datateknologi og Hadoop er et stort buzzword, som det måske lyder. Da der er sket en enorm stigning i data- og informationsdomænet fra alle brancher og domæner, bliver det meget vigtigt at etablere og introducere en effektiv teknik, der tager sig af alle behov og krav fra klienter og store industrier, der er ansvarlige for datagenerering . Tidligere blev dataene håndteret af normale programmeringssprog og simpelt struktureret forespørgselssprog, men nu ser disse systemer og værktøjer ikke ud til at gøre meget i tilfælde af big data. Big datateknologi defineres som teknologien og et softwareprogram, der er designet til analyse, behandling og ekstraktion af informationen fra et stort sæt ekstremt kompleks struktur og store datasæt, hvilket er meget vanskeligt for de traditionelle systemer at håndtere. Big datateknologi bruges til at håndtere både realtids- og batchrelaterede data. Maskinlæring er blevet en meget kritisk komponent i hverdagen og enhver branche, og derfor bliver styring af data gennem big data meget vigtig.

Typer af Big Data Technologies

Før vi starter med listen over teknologier, lad os først se den brede klassificering af alle disse teknologier. De kan hovedsageligt klassificeres i 4 domæner.

- Data opbevaring

- Analytics

- Data mining

- Visualisering

Lad os først dække alle de teknologier, der hører under opbevaringsparaplyen.

1. Hadoop : Når det kommer til big data, er Hadoop den første teknologi, der kommer i spil. Dette er baseret på kortreducerende arkitektur og hjælper med behandlingen af batchrelaterede job og procesbatchinformation. Det var designet til at gemme og behandle dataene i et distribueret databehandlingsmiljø sammen med råvaremateriale og en simpel programmeringsudførelsesmodel. Det kan bruges til at gemme og analysere de data, der findes i forskellige forskellige maskiner med høj opbevaring, hastighed og lave omkostninger. Dette er en af de vigtigste kernekomponenter i big datateknologi, som blev udviklet af Apache-softwaregrundlaget i år 2011 og er skrevet i Java.

1. Hadoop : Når det kommer til big data, er Hadoop den første teknologi, der kommer i spil. Dette er baseret på kortreducerende arkitektur og hjælper med behandlingen af batchrelaterede job og procesbatchinformation. Det var designet til at gemme og behandle dataene i et distribueret databehandlingsmiljø sammen med råvaremateriale og en simpel programmeringsudførelsesmodel. Det kan bruges til at gemme og analysere de data, der findes i forskellige forskellige maskiner med høj opbevaring, hastighed og lave omkostninger. Dette er en af de vigtigste kernekomponenter i big datateknologi, som blev udviklet af Apache-softwaregrundlaget i år 2011 og er skrevet i Java.

2. MongoDB : En anden meget vigtig og kernekomponent i big datateknologi med hensyn til opbevaring er MongoDB NoSQL-databasen. Det er en NoSQL-database, hvilket betyder, at de relationelle egenskaber og andre RDBMS-relaterede egenskaber ikke finder anvendelse på den. Det adskiller sig fra traditionelle RDBMS-databaser, der bruger struktureret forespørgselssprog. Det gør brug af skemadokumenter, og strukturen for datalagring er også anderledes, og derfor er de nyttige til at indeholde en stor mængde data. Det er et tværorienteret dokumentorienteret design- og databaseprogram, der bruger JSON-lignende dokumenter sammen med skema. Dette bliver et meget nyttigt tilfælde af operationelle datalagre i de fleste finansielle institutioner og derved arbejder på at erstatte de traditionelle mainframes. MongoDB håndterer fleksibilitet og også en lang række datatyper i store mængder og blandt distribuerede arkitekturer.

2. MongoDB : En anden meget vigtig og kernekomponent i big datateknologi med hensyn til opbevaring er MongoDB NoSQL-databasen. Det er en NoSQL-database, hvilket betyder, at de relationelle egenskaber og andre RDBMS-relaterede egenskaber ikke finder anvendelse på den. Det adskiller sig fra traditionelle RDBMS-databaser, der bruger struktureret forespørgselssprog. Det gør brug af skemadokumenter, og strukturen for datalagring er også anderledes, og derfor er de nyttige til at indeholde en stor mængde data. Det er et tværorienteret dokumentorienteret design- og databaseprogram, der bruger JSON-lignende dokumenter sammen med skema. Dette bliver et meget nyttigt tilfælde af operationelle datalagre i de fleste finansielle institutioner og derved arbejder på at erstatte de traditionelle mainframes. MongoDB håndterer fleksibilitet og også en lang række datatyper i store mængder og blandt distribuerede arkitekturer.

3. Hunk : Det er nyttigt at få adgang til data via eksterne Hadoop-klynger ved at gøre brug af virtuelle indekser og gør også brug af Splunk-søgningsproces, som kan bruges til analyse af data. Hunk kan bruges til at rapportere og visualisere enorme mængder data fra Hadoop og NoSQL databaser og kilder. Det blev udviklet af team Splunk i året 2013, som blev skrevet i Java.

3. Hunk : Det er nyttigt at få adgang til data via eksterne Hadoop-klynger ved at gøre brug af virtuelle indekser og gør også brug af Splunk-søgningsproces, som kan bruges til analyse af data. Hunk kan bruges til at rapportere og visualisere enorme mængder data fra Hadoop og NoSQL databaser og kilder. Det blev udviklet af team Splunk i året 2013, som blev skrevet i Java.

4. Cassandra : Cassandra danner et øverste valg blandt listen over populære NoSQL-databaser, som er en gratis og en open source-database, som er distribueret og har et bredt søjleopbevaring og effektivt kan håndtere data om store vareklynger, dvs. give høj tilgængelighed sammen med intet eneste fejlfelt. Blandt listen over hovedfunktioner inkluderer dem som distribueret karakter, skalerbarhed, fejltolerant mekanisme, MapReduce support, indstillelig konsistens, egenskab for sprogsprog, understøtter replikering af flere datacentre og eventuel konsistens.

4. Cassandra : Cassandra danner et øverste valg blandt listen over populære NoSQL-databaser, som er en gratis og en open source-database, som er distribueret og har et bredt søjleopbevaring og effektivt kan håndtere data om store vareklynger, dvs. give høj tilgængelighed sammen med intet eneste fejlfelt. Blandt listen over hovedfunktioner inkluderer dem som distribueret karakter, skalerbarhed, fejltolerant mekanisme, MapReduce support, indstillelig konsistens, egenskab for sprogsprog, understøtter replikering af flere datacentre og eventuel konsistens.

Dernæst lader os tale om de forskellige felter inden for big datateknologi, dvs. Data Mining.

5. Presto : Det er en populær open source og en SQL-baseret distribueret forespørgsel Engine, der bruges til at køre interaktive forespørgsler mod datakilderne i alle skalaer, og størrelsen spænder fra Gigabytes til Petabytes. Med dens hjælp kan vi forespørge data i Cassandra, Hive, proprietære datalagre og relationelle databaselagringssystemer. Dette er en java-baseret forespørgselsmotor, der blev udviklet af Apache-stiftelsen i år 2013. Et par sæt virksomheder, der udnytter Presto-værktøjet godt, er Netflix, Airbnb, Checkr, Repro og facebook.

5. Presto : Det er en populær open source og en SQL-baseret distribueret forespørgsel Engine, der bruges til at køre interaktive forespørgsler mod datakilderne i alle skalaer, og størrelsen spænder fra Gigabytes til Petabytes. Med dens hjælp kan vi forespørge data i Cassandra, Hive, proprietære datalagre og relationelle databaselagringssystemer. Dette er en java-baseret forespørgselsmotor, der blev udviklet af Apache-stiftelsen i år 2013. Et par sæt virksomheder, der udnytter Presto-værktøjet godt, er Netflix, Airbnb, Checkr, Repro og facebook.

6. ElasticSearch : Dette er et meget vigtigt værktøj i dag, når det kommer til søgning. Dette udgør en væsentlig komponent i ELK-stakken, dvs. den elastiske søgning, Logstash og Kibana. ElasticSearch er en Lucene bibliotek-baseret søgemaskine, der ligner Solr og bruges til at levere en rent distribueret, fuldtekst søgemaskine, der er i stand til at leje flere lejere. Det har en liste over skema-fri JSON-dokumenter og en HTTP-webgrænseflade. Det er skrevet på sproget JAVA og er udviklet af Elastic company i virksomheden 2012. Navnene på nogle få virksomheder, der bruger elasticsearch, er: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture osv.

6. ElasticSearch : Dette er et meget vigtigt værktøj i dag, når det kommer til søgning. Dette udgør en væsentlig komponent i ELK-stakken, dvs. den elastiske søgning, Logstash og Kibana. ElasticSearch er en Lucene bibliotek-baseret søgemaskine, der ligner Solr og bruges til at levere en rent distribueret, fuldtekst søgemaskine, der er i stand til at leje flere lejere. Det har en liste over skema-fri JSON-dokumenter og en HTTP-webgrænseflade. Det er skrevet på sproget JAVA og er udviklet af Elastic company i virksomheden 2012. Navnene på nogle få virksomheder, der bruger elasticsearch, er: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture osv.

Lad os nu læse om alle de store datateknologier, der er en del af dataanalyse:

7. Apache Kafka : Kendt for sit public-subscribe eller pub-sub, som det populært er kendt som, er et direkte messaging, asynkron messaging-mæglersystem, der bruges til at indtage og udføre databehandling på streaming-data i realtid. Det giver også en bestemmelse af opbevaringsperioden, og dataene kan kanaliseres ved hjælp af en producent-forbrugermekanisme. Det er en af de mest populære streamingplatforme, der ligner virksomhedsmeddelelsessystemet eller en meddelelseskø. Kafka har lanceret mange forbedringer hidtil, og en vigtig art er Kafka-sammenløb, som giver et yderligere niveau af egenskaber til Kafka såsom Schema-registreringsdatabasen, Ktables, KSql osv. Det blev udviklet af Apache Software-samfundet i året 2011 og er skrevet i Java. De virksomheder, der bruger denne teknologi inkluderer Twitter, Spotify, Netflix, Linkedin, Yahoo osv.

7. Apache Kafka : Kendt for sit public-subscribe eller pub-sub, som det populært er kendt som, er et direkte messaging, asynkron messaging-mæglersystem, der bruges til at indtage og udføre databehandling på streaming-data i realtid. Det giver også en bestemmelse af opbevaringsperioden, og dataene kan kanaliseres ved hjælp af en producent-forbrugermekanisme. Det er en af de mest populære streamingplatforme, der ligner virksomhedsmeddelelsessystemet eller en meddelelseskø. Kafka har lanceret mange forbedringer hidtil, og en vigtig art er Kafka-sammenløb, som giver et yderligere niveau af egenskaber til Kafka såsom Schema-registreringsdatabasen, Ktables, KSql osv. Det blev udviklet af Apache Software-samfundet i året 2011 og er skrevet i Java. De virksomheder, der bruger denne teknologi inkluderer Twitter, Spotify, Netflix, Linkedin, Yahoo osv.

8. Splunk : Splunk bruges til at fange, korrelere og indeksere streaming-data i realtid fra et søgbart arkiv, hvorfra det kan generere rapporter, grafer, dashboards, alarmer og datavisualiseringer. Det bruges også til sikkerhed, compliance og applikationsstyring og også til webanalyse, generering af forretningsindsigt og forretningsanalyse. Det blev udviklet af Splunk i Python, XML, Ajax.

8. Splunk : Splunk bruges til at fange, korrelere og indeksere streaming-data i realtid fra et søgbart arkiv, hvorfra det kan generere rapporter, grafer, dashboards, alarmer og datavisualiseringer. Det bruges også til sikkerhed, compliance og applikationsstyring og også til webanalyse, generering af forretningsindsigt og forretningsanalyse. Det blev udviklet af Splunk i Python, XML, Ajax.

9. Apache Spark : Nu kommer den mest kritiske og den mest ventede teknologi inden for store datateknologier, dvs. Apache Spark. Det er muligvis blandt dem, der er mest efterspurgt i dag og bruger Java, Scala eller Python til dens behandling. Dette bruges til at behandle og håndtere streamingdata i realtid ved at gøre brug af Spark Streaming, der bruger batching og vinduesoperationer for at få det til. Spark SQL bruges til at oprette datarammer, datasæt oven på RDD'er og derved give en god smag af transformationer og handlinger, der udgør en integreret komponent i Apache Spark Core. Andre komponenter såsom Spark Mllib, R og grafX er også nyttige i tilfælde af analyse og udførelse af maskinlæring og datavidenskab. Computerteknikken i hukommelsen er det, der gør den forskellig fra andre værktøjer og komponenter og understøtter en lang række applikationer. Det blev primært udviklet af Apache Software-fundamentet på Java-sprog.

9. Apache Spark : Nu kommer den mest kritiske og den mest ventede teknologi inden for store datateknologier, dvs. Apache Spark. Det er muligvis blandt dem, der er mest efterspurgt i dag og bruger Java, Scala eller Python til dens behandling. Dette bruges til at behandle og håndtere streamingdata i realtid ved at gøre brug af Spark Streaming, der bruger batching og vinduesoperationer for at få det til. Spark SQL bruges til at oprette datarammer, datasæt oven på RDD'er og derved give en god smag af transformationer og handlinger, der udgør en integreret komponent i Apache Spark Core. Andre komponenter såsom Spark Mllib, R og grafX er også nyttige i tilfælde af analyse og udførelse af maskinlæring og datavidenskab. Computerteknikken i hukommelsen er det, der gør den forskellig fra andre værktøjer og komponenter og understøtter en lang række applikationer. Det blev primært udviklet af Apache Software-fundamentet på Java-sprog.

10. R-sprog : R er et programmeringssprog og et frit softwaremiljø, der bruges til statistisk computing og også til grafik på et af de vigtigste sprog i R. Dette er et af de mest populære sprog blandt datavidenskabsmænd, datearbejdere og datapraktikere til udvikling af statistisk software og hovedsageligt inden for dataanalyse.

10. R-sprog : R er et programmeringssprog og et frit softwaremiljø, der bruges til statistisk computing og også til grafik på et af de vigtigste sprog i R. Dette er et af de mest populære sprog blandt datavidenskabsmænd, datearbejdere og datapraktikere til udvikling af statistisk software og hovedsageligt inden for dataanalyse.

Lad os nu diskutere teknologierne relateret til datavisualisering.

11. Tableau: Det er det hurtigst og kraftigt voksende datavisualiseringsværktøj, der bruges inden for business intelligence-domænet. Dataanalyse er en meget hurtig maskine, der er mulig ved hjælp af Tableau, og visualiseringer oprettes i form af regneark og kontrolpaneler. Det er udviklet af tableaufirmaet i år 2013 og er skrevet i Python, C ++, Java og C. Virksomheder, der bruger Tableau, er: QlikQ, Oracle Hyperion, Cognos osv.

11. Tableau: Det er det hurtigst og kraftigt voksende datavisualiseringsværktøj, der bruges inden for business intelligence-domænet. Dataanalyse er en meget hurtig maskine, der er mulig ved hjælp af Tableau, og visualiseringer oprettes i form af regneark og kontrolpaneler. Det er udviklet af tableaufirmaet i år 2013 og er skrevet i Python, C ++, Java og C. Virksomheder, der bruger Tableau, er: QlikQ, Oracle Hyperion, Cognos osv.

12. Plotly : Plotly bruges hovedsageligt til at gøre grafer og tilknyttede komponenter hurtigere og mere effektive. Det har et mere rig sæt biblioteker og API'er som MATLAB, Python, R, Arduino, Julia osv. Dette kan bruges interaktivt i Jupyter notebook og Pycharm og kan bruges til at style interaktive grafer. Det blev først udviklet i 2012 og skrevet i javascript. De få virksomheder, der bruger Plotly er paladiner, bitbank osv.

12. Plotly : Plotly bruges hovedsageligt til at gøre grafer og tilknyttede komponenter hurtigere og mere effektive. Det har et mere rig sæt biblioteker og API'er som MATLAB, Python, R, Arduino, Julia osv. Dette kan bruges interaktivt i Jupyter notebook og Pycharm og kan bruges til at style interaktive grafer. Det blev først udviklet i 2012 og skrevet i javascript. De få virksomheder, der bruger Plotly er paladiner, bitbank osv.

Konklusion

I dette indlæg har vi undersøgt top big datateknologier, der er vidt brugt i dag. Håber du kunne lide det. Følg os efter flere indlæg som disse.

Anbefalede artikler

Dette er en guide til Big Data Technologies. Her har vi diskuteret en introduktion og typer af Big Data Technologies. Du kan også gennemgå vores andre foreslåede artikler for at lære mere -

- Hvad er Splunk Tool?

- R vs Python

- Hvad er Matlab?

- Hvad er MongoDB?

- Trin, der skal følges i Mainframe Testing

- Typer af sammenføjninger i Spark SQL (eksempler)

- Lær de forskellige typer Kafka-værktøjer