Oversigt over Data Lake

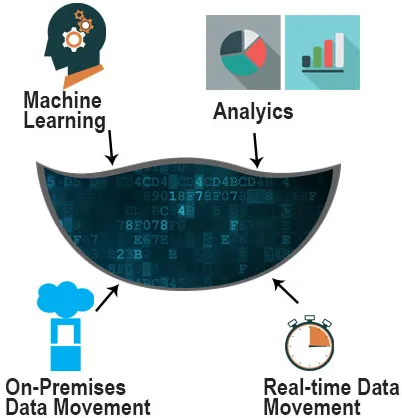

En datasø er et lager, hvor vi kan gemme en stor mængde semistrukturerede, strukturerede og ustrukturerede data. Et unikt ID med et sæt udvidede metadatatags tildeles alle dataelementer i en datasø. Når et forretningsspørgsmål opstår, kan du bede om de relevante data og derefter analysere mindre data for at hjælpe med at besvare spørgsmålet. Søen har en flad arkitektur i modsætning til et hierarkisk datavarehus, hvor data gemmes i filer og mapper. Uden første strukturering af data kan du gemme dine oplysninger, som de er, og vi kan køre forskellige typer analyser, såsom dashboards og visualiseringer til en stor databehandling, analyse i realtid og maskinlæring for at informere bedre beslutninger.

En sø bruges af fagfolk såsom dataforskere, dataudviklere og forretningsanalytikere til at gemme en stor mængde data.

Den bruges i en sø er ikke-relationel og relationel fra IoT-enheder, websteder, mobile applikationer osv. I skemaet er det skrevet på tidspunktet for analyse, dvs. skema ved læsning. Resultatet efter udførelse af forespørgsel er hurtigere.

Hvorfor har vi brug for en datasø?

Ved at bygge en sø kan dataforskere se det uraffinerede syn på data.

Årsagerne til at bruge det er som følger:

Virksomheden, der producerer forretningsfordele ved deres data, overstiger med succes deres jævnaldrende. I en Aberdeen-undersøgelse lå det selskab, der oprettede en Data Lake, 9% over lignende virksomheders organiske omsætningsvækst. Disse ledere var i stand til at udføre nye typer analyser såsom maskinlæring gennem nye kilder, såsom logfiler, clickstream-data, sociale medier og internetforbindelse i søen.

Det understøtter import af data, der kommer i realtid. Data indsamles fra flere ressourcer og flyttes derefter til søen i det originale format. En sø giver højere skalerbarhed af data. Du kan også vide, hvilken type data der er i søen ved indeksering, gennemsøgning, katalogisering af dataene.

Det understøtter datastyring, der styrer tilgængelighed, brugbarhed, sikkerhed og integritet af data.

Det kan hjælpe forsknings- og udviklingsholdene til at teste deres hypotese, forfine antagelser og vurdering af resultater.

Ingen silostruktur er tilgængelig.

Det giver kunderne en 360-graders udsigt og en robust analyse.

Kvaliteten af analysen stiger også med stigningen i datavolumen, datakvalitet og metadata.

- Opbevaringsmotorer som Hadoop har gjort det nemt at gemme forskellig information. Det er ikke nødvendigt at modellere data med en sø til en virksomhedsdækkende ordning.

- Kvaliteten af analyser stiger også med stigningen i datavolumen, datakvalitet og metadata.

- Det tilbyder forretningsdygtighed

- Det er muligt at bruge maskinlæring og kunstig intelligens til at frembringe rentable forudsigelser.

Data lake-arkitektur på Hadoop, AWS og Azure

En datasø har to komponenter: lagring og beregning. Opbevaring og databehandling kan enten findes på stedet eller i skyen. Dette resulterer i designet af en datasøarkitektur i flere mulige kombinationer.

1. Hadoop

En distribueret server Hadoop-klynge løser den store datalagringsproblem. MapReduce er Hadoop-programmeringsmodellen, der bruges til at opdele og behandle information i mindre undergrupper i serverklyngen.

2. AWS

AWS-produktsortimentet til sin datasø-løsning er omfattende. Amazon S3 er i centrum af opbevaringsfunktionsløsningen. Disse dataindtagelsesværktøjer, der giver os mulighed for at overføre enorme mængder data til S3 er Kinesis Stream, Kinesis Firehose, Snowball og Direct Connect.

Ud over Amazon S3 tilbyder NoSQL-databasen, Dynamo DB og Elastic Search en forenklet forespørgselsproces. AWS tilbyder et stort udvalg af produkter med en stejl indlæringskurve. Imidlertid er de omfattende funktioner i løsningen vidt brugt i kommerciel efterretningsapplikationer.

3. Azure

Micro-soft tilbød datasøen. Azure-datasøen har et analyse- og lagringslag kaldes Azure Store (ADLS) og de to komponenter, som det analytiske lag har Azure Analytics og HDInsight. ADLS-standarden blev bygget i HDFS og er opbevaring, der er ubegrænset. Det kan gemme billioner af filer, der er større end en petabyte i størrelse med en enkelt fil. Azure Store gør det muligt for data at blive gemt og sikret og skalerbar i ethvert format.

Fordele

Nogle vigtige punkter er vist nedenfor

- Tilvejebringer ubegrænset værdi for datatype

- Tilpasses til ændringer hurtigt

- Langsigtede ejerskabsomkostninger reduceres

- Det er den største fordel ved at centralisere forskellige indholdskilder

- Brugere fra forskellige afdelinger over hele verden kan have fleksibel datatilgang

- Giver økonomisk skalerbarhed og fleksibilitet

Risiko

- Det kan miste relevans og momentum efter et stykke tid.

- Der er en større risiko ved design

- Det øger også omkostningerne til opbevaring og produkter

- Sikkerhed og adgangskontrol er den største risiko. Undertiden kan data anbringes i en sø uden overvågning, da nogle af dataene muligvis skal beskyttes og reguleres.

Anbefalede artikler

Dette har været en guide til Hvad er en Data Lake? Her diskuterede vi konceptet, hvorfor har vi brug for Data Lake sammen med deres fordele og risici. Du kan også gennemgå vores andre foreslåede artikler for at lære mere-

- Moderne dataintegration

- Hvad er Data Analytics

- Hvad er dataovertrædelse?

- Data Scientist vs Big Data

- Data Lake vs Data Warehouse | Forskelle