Oversigt over Install Hadoop

Den følgende artikel, Install Hadoop giver en oversigt over de mest almindelige Hadoop-rammeprogramnøglemoduler og trinvis installation til Hadoop. Apache Hadoop er en samling software, der muliggør behandling af store datasæt og distribueret lagring på tværs af en klynge af forskellige typer af computersystemet. I øjeblikket forbliver Hadoop den mest udbredte analytiske platform til big data (“Sanchita Lobo, forfatter på Analytics Training Blog, ” nd).

Hadoop Framework

Apache Hadoop-rammen består af følgende nøglemoduler.

- Apache Hadoop Common.

- Apache Hadoop Distribueret filsystem (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (Endnu en Resource Manager).

Apache Hadoop Common

Apache Hadoop Common-modulet består af delte biblioteker, der forbruges på tværs af alle andre moduler, herunder nøglestyring, generiske I / O-pakker, biblioteker til metrisk indsamling og værktøjer til registreringsdatabasen, sikkerhed og streaming.

HDFS

HDFS er baseret på Google-filsystemet og er struktureret til at køre på billig hardware. HDFS er tolerant over for fejl og er designet til applikationer med store datasæt.

MapReduce

MapReduce er en iboende parallel programmeringsmodel til databehandling, og Hadoop kan køre MapReduce-programmer skrevet på forskellige sprog såsom Java. MapReduce fungerer ved at opdele behandlingen i kortfasen og reducere fasen.

Apache Hadoop YARN

Apache Hadoop YARN er en kernekomponent og er ressourcestyring og jobplanlægningsteknologi i Hadoop distribuerede behandlingsrammer.

I denne artikel diskuterer vi installationen og konfigurationen af Hadoop 2.7.4 på en enkelt knude og test konfigurationen ved at køre MapReduce-programmet kaldet wordcount for at tælle antallet af ord i filen. Vi vil yderligere se på nogle vigtige Hadoop File System-kommandoer.

Trin til installation af Hadoop

Det følgende er en oversigt over de opgaver, der er involveret i konfigurationen af Apache Hadoop.

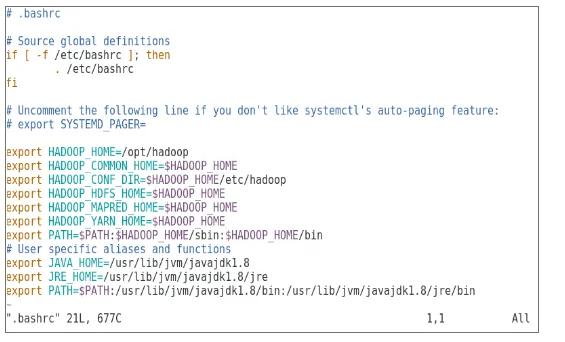

Opgave 1: Den første opgave i Hadoop-installationen omfattede opsætning af en virtuel maskinskabelon, der var konfigureret med Cent OS7. Pakker som Java SDK 1.8 og Runtime Systems, der kræves for at køre Hadoop, blev downloadet, og Java-miljøvariablen til Hadoop blev konfigureret ved at redigere bash_rc.

Opgave 2: Hadoop Release 2.7.4-pakken blev downloadet fra apache-webstedet og blev ekstraheret i opt-mappen. Som derefter blev omdøbt til Hadoop for nem adgang.

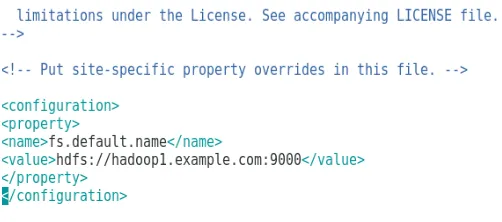

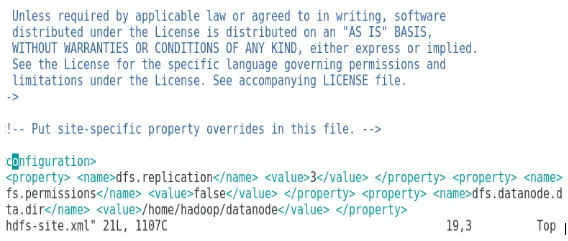

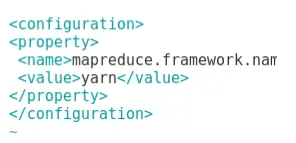

Opgave 3: Når Hadoop-pakkerne blev ekstraheret, inkluderede det næste trin konfiguration af miljøvariablen for Hadoop-bruger efterfulgt af konfiguration af Hadoop-knudepunkt XML-filer. I dette trin blev NameNode konfigureret inden for core-site.xml og DataNode blev konfigureret inden for hdfs-site.xml. Ressource manager og node manager blev konfigureret inden for garn-site.xml.

Opgave 4: firewallen blev deaktiveret for at starte YARN og DFS. JPS-kommando blev brugt til at verificere, om relevante dæmoner kører i baggrunden. Portnummeret til adgang til Hadoop blev konfigureret til http: // localhost: 50070 /

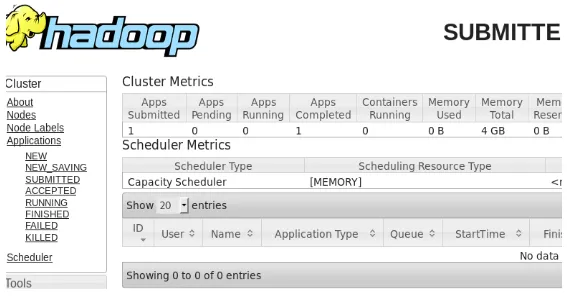

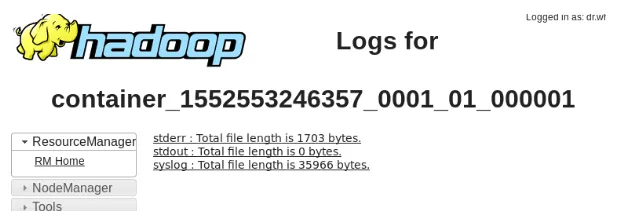

Opgave 5: De næste få trin blev brugt til at verificere og teste Hadoop. Til dette har vi oprettet en midlertidig testfil i inputmappen til WordCount-programmet. Kortreduktionsprogram Hadoop-MapReduce-eksempler2.7.4.jar blev brugt til at tælle antallet af ord i filen. Resultaterne blev evalueret på localhost, og logfiler over den indsendte ansøgning blev analyseret. Alle indsendte MapReduce-applikationer kan ses på online-grænsefladen, idet standardportnummeret er 8088.

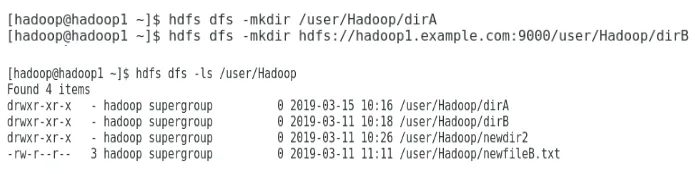

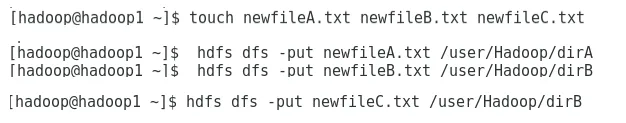

Opgave 6: I den sidste opgave introducerer vi nogle grundlæggende Hadoop File System-kommandoer og kontrollerer deres anvendelser. Vi vil se, hvordan et bibliotek kan oprettes i Hadoop-filsystemet for at liste indholdet af et bibliotek, dets størrelse i bytes. Vi vil yderligere se, hvordan du sletter et specifikt bibliotek og en fil.

Resultater i Hadoop Installation

Følgende viser resultaterne af hver af ovenstående opgaver:

Resultat af opgave 1

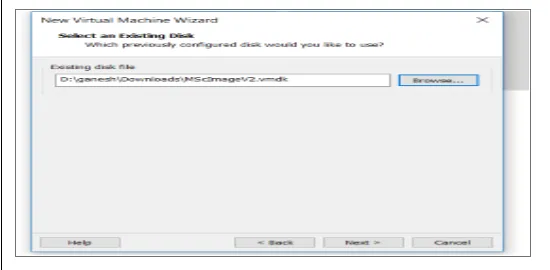

En ny virtuel maskine med et cenOS7-billede er konfigureret til at køre Apache Hadoop. Figur 1 viser, hvordan CenOS 7-billede blev konfigureret i den virtuelle maskine. Figur 1.2 viser JAVA-miljøvariabelskonfigurationen inden for .bash_rc.

Figur 1: Konfiguration af virtuel maskine

Figur 1.2: Java-miljøvariabelkonfiguration

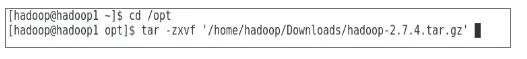

Resultat af opgave 2

Figur 2 viser den udførte opgave for at udpakke Hadoop 2.7.4-pakken i for at vælge mappen.

Figur 2: Ekstraktion af Hadoop 2.7.4-pakken

Resultat af opgave 3

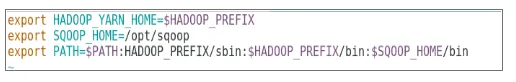

Figur 3 viser konfigurationen for miljøvariablen for Hadoop-bruger, figur 3.1 til 3.4 viser konfigurationen for XML-filer, der kræves til Hadoop-konfiguration.

Figur 3: Konfiguration af miljøvariablen for Hadoop-bruger

Figur 3.1: Konfiguration af core-site.xml

Figur 3.2: Konfiguration af hdfs-site.xml

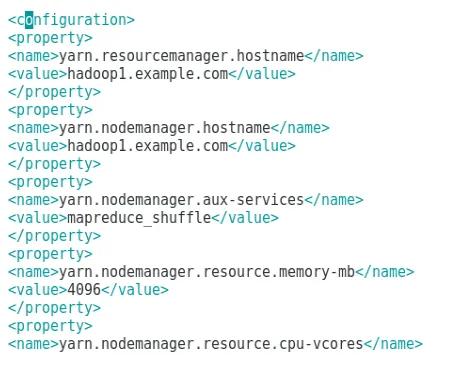

Figur 3.3: Konfiguration af mapred-site.xml-fil

Figur 3.4: Konfiguration af filen garn-site.xml

Resultat af opgave 4

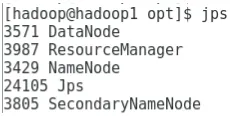

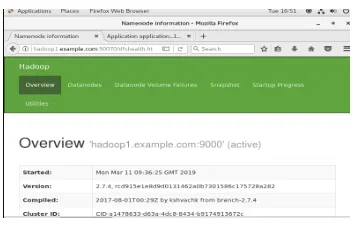

Figur 4 viser brugen af jps-kommando til at kontrollere, at relevante dæmoner kører i baggrunden, og følgende figur viser Hadoops online brugergrænseflade.

Figur 4: jps-kommando for at verificere, at kører dæmoner.

Figur 4.1: Adgang til Hadoop online interface på port http://hadoop1.example.com:50070/

Resultat af opgave 5

Figur 5 viser resultatet for MapReduce-programmet kaldet wordcount, der tæller antallet af ord i filen. De næste par figurer viser YARN-ressourcemanagerens online brugergrænseflade til den indsendte opgave.

Figur 5: MapReduce programresultater

Figur 5.1: Indsendt kortreducerende anvendelse.

Figur 5.2: Logfiler for indsendt MapReduce-ansøgning.

Resultat af opgave 6

Figur 6 viser, hvordan man opretter et bibliotek i Hadoop-filsystemet og udfører en liste over hdfs-bibliotek.

Figur 6: Oprettelse af et bibliotek i Hadoop-filsystemet

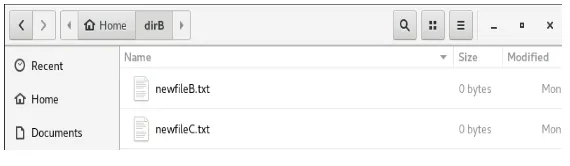

Figur 6.1 viser, hvordan man sætter en fil på Hadoop distribuerede filsystem, og figur 6.2 viser den oprettede fil i dirB-biblioteket.

Figur 6.1: Oprettelse af en fil i HDFS.

Figur 6.2: Ny fil oprettet.

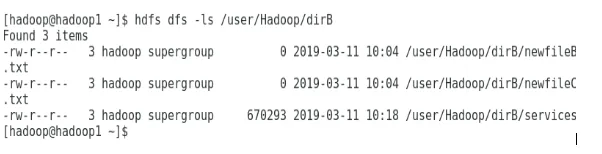

De næste par tal viser, hvordan man viser en liste over indhold i bestemte mapper:

Figur 6.3: Indhold af dirA

Figur 6.4: Indhold af dirB

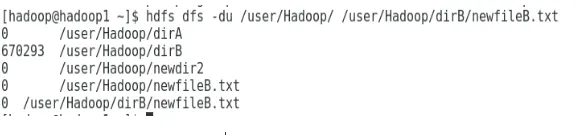

Den næste figur viser, hvordan fil- og katalogstørrelse kan vises:

Figur 6.5: Vis en fil- og katalogstørrelse.

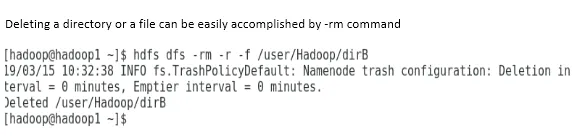

Sletning af et bibliotek eller en fil kan let udføres ved -rm-kommando.

Figur 6.6: Sådan slettes en fil.

Konklusion

Big Data har spillet en meget vigtig rolle i udformningen af dagens verdensmarked. Hadoop-rammerne gør dataanalytikernes liv let, mens det arbejdes med store datasæt. Konfigurationen af Apache Hadoop var ganske enkel, og den online brugergrænseflade gav brugeren flere muligheder for at indstille og administrere applikationen. Hadoop er blevet brugt massivt i organisationer til datalagring, maskinlæringsanalyse og sikkerhedskopiering af data. Håndtering af en stor mængde data har været meget praktisk på grund af Hadoop distribuerede miljø og MapReduce. Hadoop-udviklingen var ret forbløffende sammenlignet med relationelle databaser, da de mangler indstillinger for tuning og ydeevne. Apache Hadoop er en brugervenlig og billig løsning til styring og lagring af store data effektivt. HDFS går også langt med at hjælpe med at lagre data.

Anbefalede artikler

Dette er en guide til installation af Hadoop. Her diskuterer vi introduktionen til Instal Hadoop, trin for trin installation af Hadoop sammen med resultaterne af Hadoop Installation. Du kan også gennemgå vores andre foreslåede artikler for at lære mere -

- Introduktion til Hadoop Streaming

- Hvad er Hadoop Cluster, og hvordan fungerer det?

- Apache Hadoop økosystem og dets komponenter

- Hvad er Hadoop-alternativerne?