Introduktion til maskinindlæringsmetoder

Den følgende artikel, Machine Learning Methods, giver en oversigt over de mest almindeligt anvendte metoder i maskinlæring. Maskinlæring er en teknik, der gør en computer i stand til at 'lære' ting på egen hånd. Algoritmerne forbedrer deres ydeevne, når de tilgængelige data til læring øges. Det er mere data, jo mere nøjagtig ville vores model være.

Hvordan lærer maskiner?

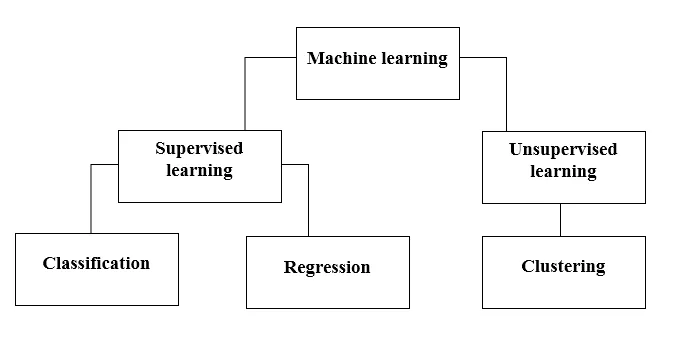

Der er forskellige metoder til at gøre det. Hvilken metode der skal følges fuldstændigt, afhænger af problemklaringen. Afhængigt af datasættet og vores problem er der to forskellige måder at gå dybere på. Den ene er overvåget læring og den anden er uovervåget læring. Følgende diagram forklarer den yderligere klassificering af maskinindlæringsmetoder. Vi vil diskutere dem en efter en.

Se på det følgende diagram!

Lad os forstå, hvad betyder Overvåget læring.

Overvåget læring

Forestil dig, som navnet antyder, en lærer eller en vejleder, der hjælper dig med at lære. Det samme gælder maskiner. Vi træner eller lærer maskinen ved hjælp af data, der er mærket.

Nogle af de fedeste overvågede læringsapplikationer er:

- Følelsesanalyse (Twitter, Facebook, Netflix, YouTube osv.)

- Natural Language Processing

- Billedklassificering

- Forudsigelig analyse

- Mønster genkendelse

- Spamdetektion

- Tale / sekvensbehandling

Vejledt læring er nu yderligere opdelt i klassificering og regression. Lad os forstå dette.

Klassifikation

Klassificering er processen med at finde en model, der hjælper med at opdele dataene i forskellige kategoriske klasser. I denne proces kategoriseres data under forskellige etiketter i henhold til nogle parametre, der er angivet i input, og derefter forudsiges etiketterne for dataene. Kategorisk betyder, at outputvariablen er en kategori, dvs. rød eller sort, spam eller ikke spam, diabetiker eller ikke-diabetiker osv.

Klassificeringsmodeller inkluderer Support vector machine (SVM), K-nærmeste nabo (KNN), Naive Bayes osv.

a) Support vector machine classifier (SVM)

SVM er en overvåget læringsmetode, der ser på dataene og sorterer dem i en af to kategorier. Jeg bruger et hyperplan til at kategorisere dataene. En lineær diskriminerende klassifikator forsøger at tegne en lige linje, der adskiller de to datasæt og derved skabe en model til klassificering. Den forsøger blot at finde en linje eller kurve (i to dimensioner) eller en manifold (i flere dimensioner), der deler klasserne fra hinanden.

Bemærk: Ved klassificering i flere klasser bruger SVM 'en vs hvile', det betyder, at der beregnes forskellige SVM for hver klasse.

b) K-nærmeste naboklassifikator (KNN)

- Hvis du læser omhyggeligt, antyder selve navnet, hvad algoritmen gør. KNN betragter de datapunkter, der er tættere, er meget mere ens med hensyn til funktioner og dermed mere sandsynligt, at de tilhører den samme klasse som naboen. For ethvert nyt datapunkt beregnes afstanden til alle andre datapunkter, og klassen afgøres på baggrund af K nærmeste naboer. Ja, det lyder måske haltende, men for nogle af klassificeringerne fungerer det som noget andet.

- Et datapunkt klassificeres efter det maksimale antal afstemninger for dets naboer, derefter tildeles datapunktet til den nærmeste klasse blandt sine k-naboer.

- I KNN kræves ingen indlæring af modellen, og alt arbejde sker på det tidspunkt, hvor der kræves en forudsigelse. Derfor omtales ofte KNN som en doven læringsalgoritme.

c) Naïve Bayes klassifikator

- Naïve Bayes er en maskinlæringsalgoritme, der anbefales stærkt til tekstklassificeringsproblemer. Det er baseret på Bayes sandsynlighedssætning. Disse klassifikatorer kaldes naive, fordi de antager, at funktionsvariabler er uafhængige af hinanden. Det betyder for eksempel, at vi har en fuld sætning til input, så antager Naïve Bayes, at hvert ord i en sætning er uafhængigt af de andre. Og klassificer dem derefter. Jeg ved, det ser temmelig naivt ud, men det er et godt valg til tekstklassificeringsproblemer, og det er et populært valg for klassificering af spam e-mail.

- Det giver forskellige typer Naive Bayes-algoritmer som BernoulliNB, GaussianNB, MultinomialNB.

- Den betragter alle funktioner som ikke-relaterede, så den kan ikke lære forholdet mellem funktioner. For eksempel, lad os sige, Varun kan lide at spise burgere, han kan også lide at spise pommes frites med koks. Men han kan ikke lide at spise en burger og en kombination af pommes frites med koks sammen. Her kan Naïve Bayes ikke lære forholdet mellem to funktioner, men lærer kun individuel vigtighedsfunktion.

Lad os nu gå videre til den anden side af vores overvågede læringsmetode, som er en regression.

Regression

Regression er processen med at finde en model, der hjælper med at differentiere dataene ved hjælp af kontinuerlige værdier. I dette ordnes arten af de forudsagte data. Nogle af de mest anvendte regressionsmodeller inkluderer Lineær regression, Tilfældig skov (beslutningstræer), neurale netværk.

Lineær regression

- En af de enkleste tilgange i overvåget læring, som er nyttig til at forudsige den kvantitative respons.

- Lineær regression inkluderer at finde den bedst passende lige linje gennem punkterne. Den bedst tilpassede linje kaldes en regressionslinje. Den bedste fit line passerer ikke nøjagtigt gennem alle datapunkter, men prøver i stedet for at det er bedst at komme tæt på dem.

- Det er den bredt anvendte algoritme til kontinuerlige data. Den fokuserer imidlertid kun på middelværdien af den afhængige variabel og begrænser sig selv til et lineært forhold.

- Lineær regression kan bruges til tidsserier, trendprognose. Det kan forudsige fremtidig salg baseret på de tidligere data.

Uovervåget læring

- Uovervåget læring er baseret på den tilgang, der kan tænkes som fraværet af en lærer og derfor af absolutte fejltiltag. Det er nyttigt, når det kræves for at lære klynger eller gruppering af elementer. Elementer kan grupperes (klynges) efter deres lighed.

- I uovervåget læring er data umærket, ikke kategoriseret, og systemets algoritmer fungerer på dataene uden forudgående træning. Ikke-overvågede læringsalgoritmer kan udføre mere komplekse opgaver end overvåget indlæringsalgoritmer.

- Uovervåget læring inkluderer klynger, som kan udføres ved hjælp af K betyder klynge, hierarkisk, gaussisk blanding, skjult Markov-model.

Applikationer, der ikke overvåges, er:

- Påvisning af lighed

- Automatisk mærkning

- Objektsegmentering (som person, dyr, film)

clustering

- Clustering er en uovervåget læringsteknologi, der bruges til dataanalyse på mange områder. Clustering-algoritmen er praktisk, når vi ønsker at få detaljeret indsigt om vores data.

- Et reelt eksempel på gruppering ville være Netflix's geneklynger, der er delt for forskellige målkunder, herunder interesser, demografi, livsstil osv. Nu kan du tænke over, hvor nyttig klynge er, når virksomheder ønsker at forstå deres kundegrundlag og målrette nyt potentiale kunder.

a) K betyder klynge

- K betyder klynge-algoritme forsøger at opdele de givne ukendte data i klynger. Den vælger tilfældigt 'k' klynger centroid, beregner afstanden mellem datapunkter og klynger centroid og tildeler derefter endelig datapunktet til klynge centroid, hvis afstand er mindst af alle klyngscentroider.

- I k-middel defineres grupper af den nærmeste centroid for hver gruppe. Denne centroid fungerer som 'hjerne' af algoritmen, de får de datapunkter, der er tættest på dem, og tilføjer dem derefter til klyngerne.

b) Hierarkisk klynge

Hierarkisk klynge ligner næsten den ved normal klynge, medmindre du vil opbygge et hierarki af klynger. Dette kan være praktisk, når du vil bestemme antallet af klynger. Antag f.eks., At du opretter grupper af forskellige varer i online købmandsforretningen. På den forreste startside ønsker du et par brede emner, og når du først klikker på et af elementerne, specifikke kategorier, åbnes det mere specifikke klynger.

Dimensionalitetsreduktion

Dimensionalitetsreduktion kan betragtes som komprimering af en fil. Det betyder, at man tager de oplysninger, der ikke er relevante, ud. Det reducerer kompleksiteten af data og forsøger at bevare de meningsfulde data. I billedkomprimering reducerer vi f.eks. Dimensionen i det rum, som billedet forbliver som det er uden at ødelægge for meget af det meningsfulde indhold i billedet.

PCA til datavisualisering

Principal component analysis (PCA) er en dimensionreduktionsmetode, der kan være nyttig til at visualisere dine data. PCA bruges til at komprimere højdimensionelle data til lavere-dimensionelle data, det vil sige, vi kan bruge PCA til at reducere fire-dimensionelle data til tre eller to dimensioner, så vi kan visualisere og få en bedre forståelse af dataene.

Anbefalede artikler

Dette er en guide til Machine Learning Methods. Her har vi drøftet en introduktion, Hvordan lærer maskiner? klassificeringer af maskinlæring og et flowchart sammen med en detaljeret forklaring. Du kan også gennemgå vores andre foreslåede artikler for at lære mere -

- Arkitektur til maskinlæring

- Rammer for maskinlæring

- Værktøj til maskinindlæring

- Maskinindlæringsteknikker

- Hyperparameter-maskinlæring

- Hierarkisk klynge-algoritme

- Hierarkisk klynge | Agglomerativ og opdelende klynge