Introduktion til beslutningstræ i maskinlæring

Decision Tree in Machine Learning har fået et bredt felt i den moderne verden. Der er mange algoritmer i ML, der bruges i vores daglige liv. En af de vigtige algoritmer er Decision Tree, der bruges til klassificering og også en løsning til regressionsproblemer. Da det er en forudsigelig model, foretages beslutningstræeanalyse via algoritmisk tilgang, hvor et datasæt er opdelt i undergrupper pr. Betingelser. Navnet siger, at det er en trælignende model i form af if-then-else-udsagn. Jo dybere er træet og flere er knudepunkterne, jo bedre er modellen.

Typer af beslutningstræer i maskinlæring

Beslutningstræ er en trælignende graf, hvor sorteringen starter fra rodnoden til bladknuden, indtil målet er nået. Det er den mest populære til beslutning og klassificering baseret på overvågede algoritmer. Det er konstrueret ved rekursiv opdeling, hvor hver node fungerer som et testtilstand for nogle attributter, og hver kant, der stammer fra noden, er et muligt svar i testtilfældet. Både rod- og bladknudepunkter er to enheder i algoritmen.

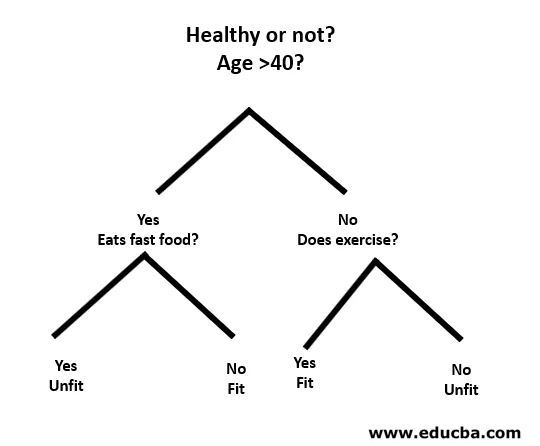

Lad os forstå med hjælp fra et lille eksempel som følger:

Her er rodnoden, om du er mindre end 40 eller ej. I så fald, spiser du derefter fastfood? Hvis ja, så er du uegnet, ellers er du i form. Og hvis du er mere end 40, skal du træne? I så fald er du i form, ellers er du uegnet. Dette var dybest set en binær klassificering.

Der er to typer beslutningstræer:

- Klassificeringstræer: Ovenstående eksempel er et kategoribaseret klassificeringstræ.

- Regressionstræer : I denne type algoritme er beslutningen eller resultatet kontinuerligt. Det har en enkelt numerisk output med flere input eller prediktorer.

I beslutningstræet er den typiske udfordring at identificere attributten ved hver knude. Processen kaldes attributvalg og har nogle mål at bruge til at identificere attributten.

en. Information Gain (IG)

Information Gain måler, hvor meget information en individuel funktion giver om klassen. Det fungerer som den vigtigste nøgle til at konstruere et beslutningstræ. En attribut med den højeste informationsgevinst opdeles først. Så beslutnings træ maksimerer altid informationsgevinsten. Når vi bruger en node til at opdele forekomsterne i mindre undergrupper, ændres entropien.

Entropi: Det er målet for usikkerhed eller urenhed i en tilfældig variabel. Entropy beslutter, hvordan et beslutningstræ opdeler dataene i undergrupper.

Ligningen for informationsgevinst og entropi er som følger:

Informationsgevinst = entropi (forælder) - (vægtet gennemsnit * entropi (børn))

Entropi: ∑p (X) log p (X)

P (X) her er brøkdelen af eksempler i en given klasse.

b. Gini-indeks

Gini-indekset er en beregning, der bestemmer, hvor ofte et tilfældigt valgt element ville blive identificeret forkert. Det fremgår tydeligt, at attribut med et lavt Gini-indeks får den første præference.

Gini-indeks: 1-∑ p (X) 2

Del oprettelse

- For at oprette en split skal vi først beregne Gini-score.

- Dataene er delt ved hjælp af en liste over rækker, der har et indeks for en attribut og en delt værdi af den attribut. Når det højre og venstre datasæt er fundet, kan vi få splitværdien med Gini-score fra den første del. Nu er den opdelte værdi den afgørelse, hvor attributten ligger.

- Den næste del evaluerer alle opdelinger. Den bedst mulige værdi beregnes ved at vurdere omkostningen for opdelingen. Den bedste opdeling bruges som en knude til beslutningstræet.

Opbygning af et træ - beslutningstræ i maskinlæring

Der er to trin til opbygning af et beslutningstræ.

1. Oprettelse af terminalnode

Mens vi opretter terminalnoden, er det vigtigste at bemærke, om vi er nødt til at stoppe med at dyrke træer eller gå videre. Følgende måder kan bruges til dette:

- Maksimal trædybde: Når træet når det maksimale antal knudepunkter, stopper udførelsen der.

- Minimum nodeposter: Det kan defineres som et minimum af mønstre, som en knude kræver. Derefter kan vi stoppe med at tilføje terminalnoder med det samme, og vi får disse minimumsknudeposter.

2. Rekursiv opdeling

Når noden først er oprettet, kan vi oprette en børneknud rekursivt ved at dele datasættet og kalde den samme funktion flere gange.

Forudsigelse

Når et træ er bygget, udføres forudsigelsen ved hjælp af en rekursiv funktion. Den samme forudsigelsesproces følges igen med venstre eller højre underordnede knudepunkter og så videre.

Fordele og ulemper ved beslutningstræet

Nedenfor gives nogle fordele og ulemper:

Fordele

Beslutningstræet har nogle fordele ved maskinlæring som følger:

- Omfattende: Den tager hensyn til hvert muligt resultat af en beslutning og sporer hver knude til konklusionen i overensstemmelse hermed.

- Specifik: Beslutningstræer tildeler en bestemt værdi til hvert problem, beslutning og resultat (er). Det reducerer usikkerhed og tvetydighed og øger også klarheden.

- Enkelhed: Decision Tree er en af de lettere og pålidelige algoritmer, da det ikke har nogen komplekse formler eller datastrukturer. Kun enkle statistikker og matematik er nødvendige til beregning.

- Alsidig: Beslutningstræer kan konstrueres manuelt ved hjælp af matematik og kan også bruges sammen med andre computerprogrammer.

Ulemper

Beslutningstræet har nogle ulemper ved maskinlæring som følger:

- Beslutningstræer er mindre passende til estimering og økonomiske opgaver, hvor vi har brug for en passende værdi (r).

- Det er en fejlbenyttet klassificeringsalgoritme sammenlignet med andre beregningsalgoritmer.

- Det er beregningsmæssigt dyrt. Ved hver knudepunkt skal kandidatopdelingen sorteres, inden den bedømmes bedst. Der er andre alternativer, som mange forretningsenheder følger for økonomiske opgaver, da Decision Tree er for dyrt til evaluering.

- Mens der arbejdes med kontinuerlige variabler, er beslutningstræet ikke egnet som den bedste løsning, da det har en tendens til at miste information under kategorisering af variabler.

- Det er undertiden ustabilt, da små variationer i datasættet kan føre til dannelse af et nyt træ.

Konklusion - Beslutningstræ i maskinlæring

Som en af de vigtigste og overvågede algoritmer spiller Decision Tree en afgørende rolle i beslutningsanalysen i det virkelige liv. Som en forudsigelig model bruges den på mange områder til sin splittede tilgang, som hjælper med at identificere løsninger baseret på forskellige forhold ved enten klassificering eller regressionsmetode.

Anbefalede artikler

Dette er en guide til beslutningstræ i maskinlæring. Her diskuterer vi introduktionen, typer af beslutningstræer i maskinlæring, opdeling af opdelingen og bygning af et træ. Du kan også gennemgå vores andre foreslåede artikler for at lære mere–

- Python-datatyper

- Tableau datasæt

- Cassandra Datamodellering

- Beslutningstabelprøvning

- Top 8 faser i maskinlæringscyklus