Forskellen mellem Hadoop vs Spark

Hadoop er en open-source ramme, der gør det muligt at gemme og behandle big data i et distribueret miljø på tværs af computerklynger. Hadoop er designet til at skalere fra en enkelt server til tusinder af maskiner, hvor hver maskine tilbyder lokal beregning og opbevaring. Spark er en open-source-klynge-computing designet til hurtig beregning. Det giver en grænseflade til programmering af hele klynger med implicit dataparallelisme og fejltolerance. Hovedfunktionen i Spark er computerstyring i hukommelsen, der øger hastigheden af et program.

Hadoop

- Hadoop er et registreret varemærke tilhørende Apache-softwaregrundlaget. Den bruger en simpel programmeringsmodel til at udføre den krævede operation blandt klynger. Alle moduler i Hadoop er designet med en grundlæggende antagelse om, at hardwarefejl er almindelige forekomster og skal håndteres inden for rammerne.

- Det kører applikationen ved hjælp af MapReduce-algoritmen, hvor data behandles parallelt på forskellige CPU-noder. Med andre ord er Hadoop-rammen i stand nok til at udvikle applikationer, som yderligere er i stand til at køre på klynger af computere, og de kan udføre en komplet statistisk analyse for en enorm mængde data.

- Kernen i Hadoop består af en lagringsdel, der er kendt som Hadoop Distribueret filsystem og en behandlingsdel kaldet programmeringsmodellen MapReduce. Hadoop delte dybest set filer i de store blokke og distribuerer dem over klyngerne, overfører pakke kode til noder for at behandle data parallelt.

- Dette fremgangsmåde datasæt, der skal behandles hurtigere og mere effektivt. Andre Hadoop-moduler er Hadoop-fælles, som er en masse Java-biblioteker og værktøjer, der returneres af Hadoop-moduler. Disse biblioteker indeholder et filsystem og abstraktion af operativsystemniveau, og indeholder også krævede Java-filer og scripts til at starte Hadoop. Hadoop Yarn er også et modul, der bruges til jobplanlægning og styring af klyngeressourcer.

Gnist

- Spark blev bygget på toppen af Hadoop MapReduce-modulet og udvider MapReduce-modellen til effektivt at bruge flere typer beregninger, der inkluderer interaktive forespørgsler og streambehandling. Spark blev introduceret af Apache-softwaregrundlaget for at fremskynde Hadoop computational computing-softwareprocessen.

- Spark har sin egen klyngestyring og er ikke en ændret version af Hadoop. Spark bruger Hadoop på to måder - den ene er lagring og den anden behandler. Da klyngestyring ankommer fra Spark selv, bruger den kun Hadoop til opbevaringsformål.

- Spark er et af Hadoops underprojekter, der blev udviklet i 2009, og senere blev det open source under en BSD-licens. Det har masser af vidunderlige funktioner ved at ændre visse moduler og inkorporere nye moduler. Det hjælper med at køre en applikation i en Hadoop-klynge, flere gange hurtigere i hukommelsen.

- Dette gøres muligt ved at reducere antallet af læse / skrive operationer til disk. Det gemmer mellemliggende behandlingsdata i hukommelsen og gemmer læse / skrivehandlinger. Spark leverer også indbyggede API'er i Java, Python eller Scala. Således kan man skrive applikationer på flere måder. Spark giver ikke kun en kort- og reduktionsstrategi, men understøtter også SQL-forespørgsler, streaming af data, maskinlæring og grafalgoritmer.

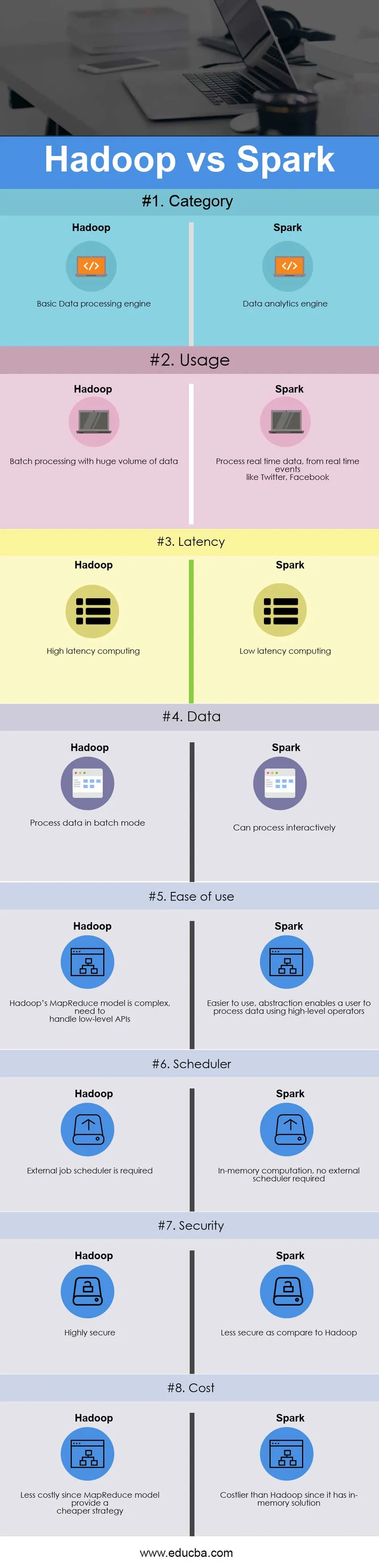

Sammenligning mellem hoved og hoved mellem Hadoop vs Spark (Infographics)

Nedenfor er den øverste 8 forskel mellem Hadoop vs Spark

Vigtigste forskelle mellem Hadoop vs Spark

Både Hadoop vs Spark er populære valg på markedet; lad os diskutere nogle af de største forskelle mellem Hadoop og Spark:

- Hadoop er en open source-ramme, der bruger en MapReduce-algoritme, hvorimod Spark er lynhurtig klynge-computerteknologi, der udvider MapReduce-modellen til effektiv anvendelse med flere typer beregninger.

- Hadoop's MapReduce-model læser og skriver fra en disk, hvilket sænker behandlingshastigheden, hvorimod Spark reducerer antallet af læse / skrivecyklusser til disk og gemmer mellemliggende data i hukommelsen, og dermed hurtigere behandlingshastighed.

- Hadoop kræver, at udviklere håndkoder hver eneste operation, hvorimod Spark er let at programmere med RDD - Resilient Distribueret datasæt.

- Hadoop MapReduce-modellen leverer en batchmotor, der derfor er afhængig af forskellige motorer til andre krav, hvorimod Spark udfører batch, interaktiv, maskinlæring og streaming alt i samme klynge.

- Hadoop er designet til at håndtere batchbehandling effektivt, mens Spark er designet til at håndtere data i realtid effektivt.

- Hadoop er en computer med høj latency computing, som ikke har en interaktiv tilstand, hvorimod Spark er en computer med lav latens og kan behandle data interaktivt.

- Med Hadoop MapReduce kan en udvikler kun behandle data i batch-tilstand, mens Spark kan behandle data i realtid gennem Spark Streaming.

- Hadoop er designet til at håndtere fejl og fejl, det er naturligt elastisk over for fejl, hvilket er et yderst fejltolerant system, mens RDD med Spark tillader gendannelse af partitioner på mislykkede noder.

- Hadoop har f.eks. Brug for en ekstern jobplanlægning - Oozie for at planlægge komplekse strømme, hvorimod Spark har beregning i hukommelsen, så den har sin egen flowplanlægning.

- Hadoop er en billigere mulighed, mens den sammenlignes med hensyn til omkostninger, mens Spark kræver en masse RAM for at køre in-memory, hvilket øger klyngen og dermed omkostningerne.

Hadoop vs gnist sammenligningstabel

Den primære sammenligning mellem Hadoop vs Spark diskuteres nedenfor

| Grundlaget for sammenligning mellem Hadoop vs Spark |

Hadoop |

Gnist |

| Kategori | Grundlæggende databehandlingsmotor | Dataanalysemotor |

| Anvendelse | Batchbehandling med en enorm mængde data | Behandl data i realtid fra realtidsbegivenheder som Twitter, Facebook |

| Reaktionstid | Computering med høj latens | Computering med lav latens |

| Data | Behandl data i batchtilstand | Kan behandle interaktivt |

| Brugervenlighed | Hadoop's MapReduce-model er kompleks, der er behov for at håndtere API'er på lavt niveau | Nemmere at bruge, abstraktion gør det muligt for en bruger at behandle data ved hjælp af operatører på højt niveau |

| Scheduler | Ekstern jobplanlægning er påkrævet | Beregning i hukommelsen, ingen ekstern planlægning krævet |

| Sikkerhed | Meget sikker | Mindre sikker sammenlignet med Hadoop |

| Koste | Mindre dyre, da MapReduce-modellen giver en billigere strategi | Dyrere end Hadoop, da den har en in-memory-løsning |

Konklusion - Hadoop vs Spark

Hadoop MapReduce tillader parallel behandling af enorme mængder data. Det bryder en stor del i mindre, der skal behandles separat på forskellige dataknudepunkter og samler automatisk resultaterne på tværs af flere noder for at returnere et enkelt resultat. Hvis det resulterende datasæt er større end tilgængeligt RAM, kan Hadoop MapReduce overgå Spark.

Spark er på den anden side lettere at bruge end Hadoop, da det kommer med brugervenlige API'er til Scala (dets modersmål), Java, Python og Spark SQL. Da Spark giver en måde at udføre streaming, batch-behandling og maskinlæring i den samme klynge, finder brugerne det let at forenkle deres infrastruktur til databehandling.

Den endelige beslutning om at vælge mellem Hadoop vs Spark afhænger af grundlæggende parameter - krav. Apache Spark er meget mere avanceret klyngedatormotor end Hadoop's MapReduce, da den kan håndtere enhver form for krav, dvs. batch, interaktiv, iterativ, streaming osv., Mens Hadoop kun begrænser sig til batchbehandling. Samtidig er Spark dyrere end Hadoop med sin hukommelsesfunktion, som til sidst kræver en masse RAM. I slutningen af dagen afhænger det hele af en virksomheds budget og funktionelle krav. Jeg håber, nu skal du have fået en mere retfærdig idé om både Hadoop vs Spark.

Anbefalet artikel

Dette har været en guide til den største forskel mellem Hadoop vs Spark. Her diskuterer vi også Hadoop vs Spark nøgleforskelle med infografik og sammenligningstabel. Du kan også se på de følgende artikler fra Hadoop vs Spark for at lære mere.

- Data Warehouse vs Hadoop

- Splunk vs gnist

- Hadoop vs Cassandra - 17 Awesome Differences

- Gris vs gnist - hvilken der er bedre

- Hadoop vs SQL Performance: Forskel