Forskellen mellem Hadoop og SQL

De enorme data, der genereres hvert sekund via sociale medier som Facebook, Twitter, Instagram har banet vejen for udviklingen af Hadoop / Big Data Ecosystem. Udtrykket “3V”, der refererer til Volumen, hastighed og veracitet definerer betydningen af Hadoop for at håndtere streaming-data. I dag genereres data fra flere kilder, som er nødvendige for at blive integreret til forskellige formål som rapportering, dataanalyse og forskning og til centraliseret lagring af data. Når vi gør det, opstår der adskillige problemer med traditionelle tilgange som rum, adgang, integritet, struktur og båndbredde. For at håndtere alle disse problemer leverer Hadoop en ramme, der gør det muligt at behandle dataene i enorm størrelse, give let adgang, høj tilgængelighed og indlæse data dynamisk. Det har et distribueret filsystemramme (HDFS) til opbevaring af data og en indbygget forespørgselsprocessor kaldet “Map Reduce” til analyse og behandling af data, der er gemt i HDFS.

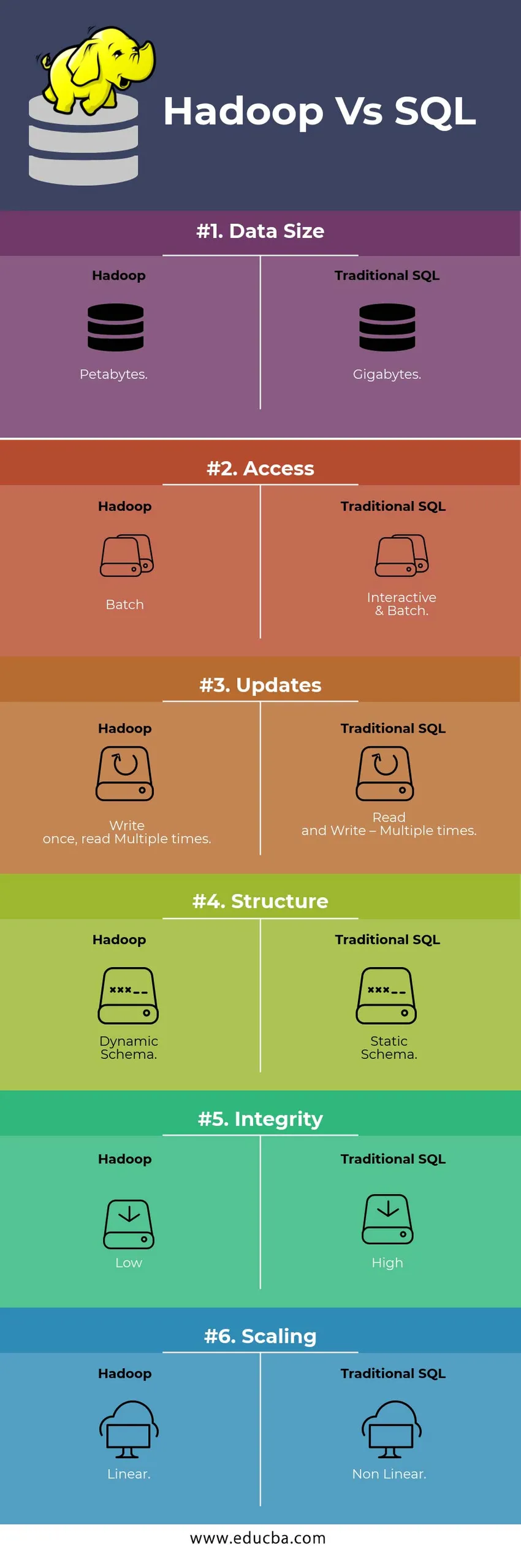

HEAD TO HEAD Sammenligning mellem Hadoop Vs SQL

Nedenfor er Top 6 forskellen mellem Hadoop Vs SQL

Vigtige forskelle mellem Hadoop Vs SQL

Nedenfor er forskellen mellem Hadoop og SQL er som følger

- Skema på WRITE Vs READ

Generelt i en traditionel database, under datastyring / migrering fra en database til en anden, følger det skemaet med Skriv-tilgang. Dette gør datalastprocessen til at blive ophidset / afbrudt og resulterer i afvisning af poster på grund af en forskel i strukturen i kilden og måltabellerne. Mens Hadoop-systemet er alle data lagret i HDFS og dataene er centraliseret.

Hadoop-rammer bruges hovedsageligt til Data Analytics-processen. Således understøtter det alle tre kategorier af data, dvs. strukturerede, semistrukturerede og ustrukturerede data, og det muliggør skema ved læsemetode.

- Strukturerede data har et bestemt format. g .: XML-fil.

- Semi Structures-data er løsere; Det har muligvis ikke et skema. g .: Regneark

- Ustrukturerede data har ikke en bestemt struktur eller et skema. F.eks .: Almindelig tekst eller billede.

Hadoop arbejder effektivt med ustrukturerede data, da det har evnen til at fortolke dataene under behandlingstiden.

| Nærme sig | Fordel | Dis Advantage |

| Skema til skriv | · Foruddefinerede strukturer

· Hurtigere læsning. F.eks .: traditionel RDBMS. | Langsom dataindlæsning

Høj forsinkelse |

| Skema ved læsning | · Dynamisk struktur

· Hurtig skrivning og læsning. F.eks .: Hadoop | Hurtig dataindlæsning

Lav latenstid |

Tabel : Skema på SKRIV VS Skema på LÆS.

- SCALABILITET & OMKOSTNINGER

Hadoop Framework er designet til at behandle en stor mængde data. Hver gang datastørrelsen øges, kan et antal ekstra ressourcer som dataknudepunkt føjes til klyngen meget let end den traditionelle tilgang til statisk hukommelsesallokering. Tid og budget er relativt meget mindre til at implementere dem, og Hadoop leverer også datalokalitet, hvor dataene stilles til rådighed i den node, der udførte jobbet.

- FEJLTOLERANCE

I det traditionelle RDBMS tager det mere tid, omkostninger og ressource at hente de mistede data tilbage, når data går tabt på grund af korruption eller ethvert netværksproblem. Men Hadoop har en mekanisme, hvor dataene har mindst tre niveauer af replikationsfaktor for de data, der er gemt i HDFS. Hvis en af dataknudepunkterne, der indeholder data, mislykkes, kan data let trækkes fra andre dataknudepunkter med stor tilgængelighed af data. Derfor gør dataene let tilgængelige for brugeren uanset fejl.

- FUNKTIONEL PROGRAMMERING

Hadoop understøtter skrivning af funktionel programmering på sprog som java, scala og python. For ethvert program, der kræver yderligere funktionalitet, kan implementeres ved at registrere UDF - Brugerdefinerede funktioner i HDFS. I RDBMS er der ingen mulighed for at skrive UDF, og det øger kompleksiteten ved at skrive SQL. Desuden kan data, der er gemt i HDFS, fås adgang til alle økosystemer i Hadoop som Hive, Pig, Sqoop og HBase. Så hvis UDF er skrevet, kan den bruges af en hvilken som helst af ovennævnte applikationer. Det øger systemets ydelse og understøttelighed.

- OPTIMERING

Hadoop gemmer data i HDFS og Process selvom Map Reduce med enorme optimeringsteknikker. De mest populære teknikker, der bruges til håndtering af data, bruger partitionering og bucketing af de lagrede data. Partitionering er en tilgang til lagring af dataene i HDFS ved at opdele dataene baseret på kolonnen nævnt til partitionering. Når dataene indsprøjtes eller indlæses i HDFS, identificerer de partitionskolonnen og skubber dataene ind i det pågældende partitionskatalog. Så forespørgslen henter resultatsættet ved direkte at hente dataene fra det partitionerede bibliotek. Dette reducerer hele tabellscanningen, forbedrer responstiden og undgår latens.

En anden tilgang kaldes Bucketing af dataene. Dette gør det muligt for analytikeren at nemt fordele dataene mellem dataknudepunkterne. Alle knudepunkter har et lige stort antal distribuerede data. Spændingssøjlen er valgt på en sådan måde, at den har mindst antal kardinaliteter.

Disse tilgange er ikke tilgængelige i den traditionelle metode til SQL.

- DATATYPE

I en traditionel tilgang er den understøttede datatype meget begrænset. Det understøtter kun strukturerede data. Så det tager mere tid at rense og formatere selve skemaet med data. Men Hadoop understøtter kompleks datatype som Array, Struct og Map. Dette tilskynder til at bruge de forskellige typer af et datasæt, der skal bruges til datalast. For Ex: XML-data kan indlæses ved at definere dataene med XML-elementer, der indeholder kompleks datatype.

- DATAKOMPRESSION

Der er meget mindre indbyggede komprimeringsteknikker til rådighed for det traditionelle databasesystem. Men til Hadoop-rammerne er der mange komprimeringsteknikker som gzib, bzip2, LZO og snappy. Standard komprimeringstilstand er LZ4. Selv tabellerne kan komprimeres ved hjælp af komprimeringsteknikker som Parket, ORC. Komprimeringsteknikker hjælper med at få tabellerne til at optage meget mindre plads med at øge gennemstrømningen og hurtigere udførelse af forespørgsler.

Hadoop mod SQL-sammenligningstabel

| Egenskaber | Traditionel SQL | Hadoop |

| Datastørrelse | Gigabytes | petabyte |

| Adgang | Interaktiv & batch | Parti |

| opdateringer | Læs og skriv - Flere gange | Skriv en gang, læst flere gange |

| Struktur | Statisk skema | Dynamisk skema |

| Integritet | Høj | Lav |

| Skalering | Ikke-lineær | Lineær |

Tabel : Sammenligning mellem traditionel Hadoop og SQL Framework.

Konklusion - Hadoop mod SQL

Generelt går Hadoop foran den traditionelle SQL med hensyn til omkostninger, tid, ydelse, pålidelighed, supportbarhed og tilgængelighed af data til den meget store brugergruppe. For effektivt at håndtere den enorme mængde data, der genereres hver dag, hjælper Hadoop-rammerne med til rettidig indfangning, lagring, behandling, filtrering og til sidst opbevaring i dem på et centralt sted.

Anbefalet artikel

- Hadoop vs Hive - Find ud af de bedste forskelle

- Lær den 10 nyttige forskel mellem Hadoop vs Redshift

- HADOOP vs RDBMS | Kend til de 12 nyttige forskelle

- Apache Hadoop vs Apache Spark | Top 10 sammenligninger, du skal vide!

- Hadoop vs Spark: Funktioner