Introduktion til Big Data Architecture

Når det kommer til styring af tunge data og udførelse af komplekse operationer på de massive data, bliver der et behov for at bruge big data-værktøjer og teknikker. Når vi siger at bruge big data-værktøjer og teknikker, mener vi effektivt, at vi beder om at gøre brug af forskellige software og procedurer, der ligger i big data-økosystemet og dets sfære. Der er ingen generisk løsning, der leveres til enhver brugssag, og derfor skal den udformes og fremstilles på en effektiv måde i henhold til en bestemt virksomheds forretningskrav. Således bliver der et behov for at gøre brug af forskellige big data-arkitektur, da kombinationen af forskellige teknologier vil resultere i, at den resulterende brugssag opnås. Ved at etablere en fast arkitektur kan det sikres, at der leveres en levedygtig løsning til den anmodede brugssag.

Hvad er Big Data Architecture?

- Denne arkitektur er designet på en sådan måde, at den håndterer indtagelsesprocessen, behandling af data og analyse af dataene udføres, hvilket er alt for stort eller komplekst til at håndtere de traditionelle databasestyringssystemer.

- Forskellige organisationer har forskellige tærskler for deres organisationer, nogle har det for et par hundrede gigabyte, mens for andre selv nogle terabyte ikke er god nok som en tærskelværdi.

- På grund af denne begivenhed, der sker, hvis man ser på råvaresystemerne og råvarelageret, er værdierne og omkostningerne ved lagring reduceret markant. Der er en lang række data, der kræver forskellige måder at imødekomme.

- Nogle af dem er batchrelaterede data, der kommer på et bestemt tidspunkt, og derfor kræves det, at joberne planlægges på lignende måde, mens andre hører til streamingklassen, hvor der skal bygges en real-time streaming-rørledning til at imødekomme alle de krav. Alle disse udfordringer løses af big data-arkitektur.

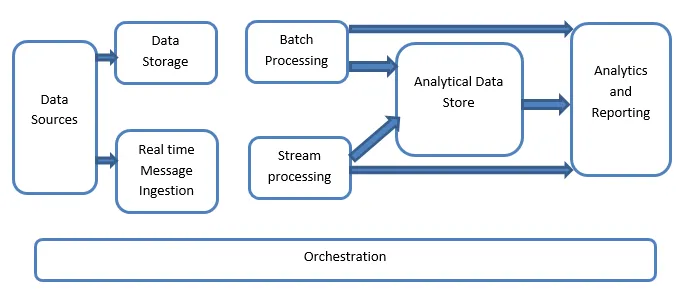

Forklaring af Big Data Architecture:

Big Data-systemer involverer mere end én arbejdsbelastningstyper, og de klassificeres stort set som følger:

- Hvor de store databaserede kilder er i ro, er batchbehandling involveret.

- Big databehandling i bevægelse til realtidsbehandling.

- Udforskning af interaktive big data-værktøjer og teknologier.

- Maskinindlæring og forudsigelig analyse.

1. Datakilder

Datakilderne involverer alle de gyldne kilder, hvorfra dataekstraktionsrørledningen er bygget, og det kan derfor siges at være udgangspunktet for big data-rørledningen.

Eksemplerne inkluderer:

(i) Datastores af applikationer såsom dem som relationelle databaser

(ii) Filerne, der er produceret af en række applikationer og hovedsageligt er en del af statiske filsystemer, såsom webbaserede serverfiler, der genererer logfiler.

(iii) IoT-enheder og andre realtidsbaserede datakilder.

2. Datalagring

Dette inkluderer de data, der styres for de batchbyggede operationer og gemmes i fillagrene, der er distribueret i naturen og også er i stand til at indeholde store volumener med forskellige format, med sikkerhedskopierede store filer. Det kaldes datasøen. Dette udgør generelt den del, hvor vores Hadoop-opbevaring, såsom HDFS, Microsoft Azure, AWS, GCP-lagre leveres sammen med klodsbeholdere.

3. Batchbehandling

Alle data er adskilt i forskellige kategorier eller bunker, der gør brug af langvarige job, der bruges til at filtrere og aggregere og også forberede data o behandlet tilstand til analyse. Disse job bruger normalt kilder, behandler dem og leverer output af de behandlede filer til de nye filer. Batchbehandlingen udføres på forskellige måder ved at gøre brug af Hive-job eller U-SQL-baserede job eller ved at gøre brug af Sqoop eller Pig sammen med de brugerdefinerede kortreduceringsjob, der normalt er skrevet i et hvilket som helst af Java- eller Scala-eller andre sprog som Python.

4. Realtidsbaseret indtagelse af beskeder

Dette inkluderer i modsætning til batchbehandlingen alle realtime-streaming-systemer, der tager højde for de data, der genereres sekventielt og i et fast mønster. Dette er ofte en simpel datamart eller butik, der er ansvarlig for alle de indkommende meddelelser, der slettes inden for den mappe, der nødvendigvis bruges til databehandling. Der er imidlertid flertallet af løsninger, der kræver behovet for en meddelelsesbaseret indtagelseslager, der fungerer som en meddelelsesbuffer og også understøtter den skalabaserede behandling, giver en relativt pålidelig levering sammen med anden messingkø-semantik. Valgmulighederne inkluderer dem som Apache Kafka, Apache Flume, Event hubs fra Azure osv.

5. Streambehandling

Der er en lille forskel mellem indtagelse af realtidsmeddelelse og strømbehandling. Førstnævnte tager de indtagne data i betragtning, som først indsamles og derefter bruges som en public-abonnementsform for et værktøj. På den anden side bruges streambehandling til at håndtere alle streaming-data, der forekommer i vinduer eller strømme, og derefter skriver dataene til output sink. Dette inkluderer Apache Spark, Apache Flink, Storm osv.

6. Analytics-baseret datastore

Dette er datalageret, der bruges til analytiske formål, og derfor spørges og analyseres derefter de allerede behandlede data ved hjælp af analytiske værktøjer, der kan svare til BI-løsningen. Dataene kan også præsenteres ved hjælp af en NoSQL-datavarehagsteknologi som HBase eller enhver interaktiv brug af hive-database, som kan give metadataabstraktion i datalageret. Værktøjer inkluderer Hive, Spark SQL, Hbase osv.

7. Rapportering og analyse

Indsigten skal genereres på de behandlede data, og det gøres effektivt af rapporterings- og analyseværktøjerne, der gør brug af deres indlejrede teknologi og løsning til at generere nyttige grafer, analyse og indsigt, der er nyttige for virksomhederne. Værktøjer inkluderer Cognos, Hyperion osv.

8. Orkestrering

Store databaserede løsninger består af datarelaterede operationer, der er gentagne og har også indkapsling i arbejdsgange, som kan omdanne kildedataene og også flytte data på tværs af kilder samt dræn og belastning i butikker og skubbe ind i analytiske enheder. Eksempler inkluderer Sqoop, oozie, datafabrik osv.

Konklusion

I dette indlæg læser vi om big data-arkitekturen, som er nødvendig for, at disse teknologier kan implementeres i virksomheden eller organisationen. Håber du kunne lide vores artikel.

Anbefalede artikler

Dette har været en guide til Big Data Architecture. Her diskuterer vi, hvad der er big data? og også har vi forklaret arkitekturen for big data sammen med blokdiagrammet. Du kan også gennemgå vores andre foreslåede artikler for at lære mere -

- Big Data Technologies

- Big Data Analytics

- Karrierer inden for Big Data

- Spørgsmål om Big Data-interview

- Top 8 enheder af IoT, du burde vide

- Typer af sammenføjninger i Spark SQL (eksempler)