Hvad er gris?

Pig er en open source-motor, som er en del af Hadoop-økosystemteknologierne. Gris er god til at arbejde med data, der er ud over traditionelle databaser eller datalager. Dette kan håndtere manglende, ufuldstændige eller inkonsekvente data, som ikke har noget skema. Grisen har sit eget sprog til at udtrykke datamanipulationer, som er svine-latin.

Forståelse af gris

Gris er en teknologi, der giver dig mulighed for at skrive et højt niveau, men ekstremt granulære scripts, som giver dig mulighed for at arbejde med data, hvor skemaet enten er ukendt eller inkonsekvent. Pig er en open source-teknologi, der kører på toppen af Hadoop og er en del af det ekstremt levende og populære Hadoop-økosystem.

Gris fungerer godt med ustrukturerede og ufuldstændige data, så du ikke behøver at have det traditionelle layout af regler og kolonner til alt.

Det er veldefineret, og det kan direkte arbejde på filer i HDFS (Hadoop Distribueret filsystem).

Grisen er din valgte teknologi, når du vil hente data fra kilden til et datavarehus.

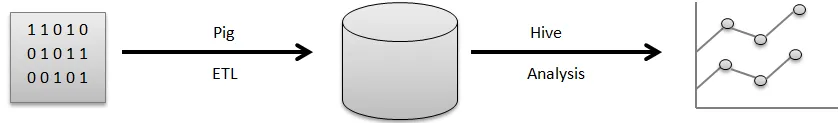

For eksempel en visuel pipeline af, hvordan data typisk flyder, før du kan bruge dem til at generere de pæne diagrammer, du bruger til at tage forretningsbeslutninger.

De rå data kommer fra en række forskellige kilder, såsom sensorer, mobiltelefoner osv. Du bruger derefter svin til at udføre en ETL-operation. ETL står for at udtrække, transformere og indlæse, når disse operationer er udført, gemmes de oprensede data i en anden database. Et eksempel på en sådan database er HDFS, som er en del af Hadoop. Hive er et datalager, der kører oven på et filsystem som dette. Hive er det, du vil bruge til analyse, til at generere rapporter og til at udtrække indsigt.

ETL er et meget vigtigt trin i databehandlingen for at rense dataene op og i den rigtige form, der skal gemmes i en database. Uddrag refererer til driften af at trække ustrukturerede, inkonsekvente data med manglende felt og værdier fra den originale kilde. Transform står for den række af operationer, som du anvender på dataene for at rydde op eller hente dem.

Forberegning af nyttig samlet information, behandling af felter til at matche et bestemt format, alt dette er en del af dataoprydning af transformfelterne.

Endelig udfører grisen belastningsoperationen, hvor disse rene data gemmes i en database, hvor de kan analyseres yderligere. Et eksempel på en standardhandling, som Pig udfører, er at rydde op i logfiler.

Forklar svinearkitektur

Der er mange svinedele i arkitekturen, foretrækkes:

- Parser : Parser beskæftiger sig med svinekripter såvel som, kontrollerer, at syntaks af scriptet, skriver kontrol og forskellige assorterede kontroller. Derudover kan deres resultat muligvis være en DAG (Directed Acyclic Graph), som normalt betegner Pig Latin-påstandene sammen med logiske operatører.

De logiske operatører med scriptet vises også som knudepunkterne, såvel som datastrømme vises siden kanter gennem DAG.

- Optimizer: Senere overskrides den logiske plan (DAG) normalt mod den logiske optimizer. Den udfører de logiske optimeringer yderligere inklusive projektion og fremmer lav

- Compiler: Kompilereren kompilerer også den forbedrede logiske plan i en gruppe af MapReduce-værker.

- Udførelsesmotor: I sidste ende vil alle MapReduce-værker blive sendt til Hadoop inden for en sorteret rækkefølge. Til sidst genererer dette de krævede resultater, selvom disse MapReduce-værker udføres med Hadoop.

- MapReduce: MapReduce blev oprindeligt designet i Google som en måde at behandle websider for at tænke Google-søgning. MapReduce distribuerer computing på tværs af flere maskiner i klyngen. MapReduce drager fordel af den iboende parallelitet i databehandlingen. Moderne systemer, såsom sensorer, eller endda Facebook-statusopdateringer genererer millioner af poster med rå data.

En aktivitet med dette niveau kan udarbejdes i to faser:

- Kort

- Reducere

Du bestemmer, hvilken logik du vil implementere inden for disse faser for at behandle dine data.

- HDFS (Hadoop Distribueret filsystem): Hadoop giver mulighed for en eksplosion af datalagring og analyse i en skala i en ubegrænset kapacitet. Udviklere bruger en applikation som Pig, Hive, HBase og Spark til at hente data fra HDFS.

Funktioner

Apache Pig kommer med forskellige funktioner:

- Simplicity of Programming: Pig Latin kan sammenlignes med SQL, og derfor er det ganske enkelt for udviklere at oprette et Pig-script. I tilfælde af at du har forståelse for SQL-sprog, er det utroligt nemt at lære svin-latin sprog, da det er ligesom SQL-sprog.

- Rigt sæt af operatører: Gris indeholder en række rige sæt operatører for at være i stand til at udføre procedurer ligesom sammenføjning, filer, sortering og meget mere.

- Optimeringsmuligheder: Ydelsen med opgaven i Apache Pig kan øjeblikkeligt forbedres af selve opgaven; derfor skal udviklerne bare koncentrere sig om semantikken i dette sprog.

- Udvidbarhed: Brug af tilgængelige operatører kan brugere simpelthen udvikle deres funktioner til at læse, behandle og skrive data.

- Brugerdefinerede funktioner (UDF'er): Ved at bruge en tjeneste, der leveres af Pig til at fremstille UDF'er, kunne vi fremstille brugerdefinerede funktioner på antallet af udviklingssprog, herunder Java, samt påkalde eller indlejre dem alle i svinestripter.

Hvad er svin nyttigt til?

Det bruges til både at undersøge og udføre ansvar inklusive ad-hoc-håndtering. Apache Pig kan bruges beregnet til:

Analyse med enorme rå datasamling foretrækker databehandling for at få søgewebsteder. Såsom Yahoo drager Google fordel af Apache Pig til at evaluere data indsamlet via Google såvel som Yahoo-søgemaskiner. Håndtering af store datasamlinger ligesom web-poster, streaming af onlineinfo osv. Selv Facebooks statusopdateringer genererer millioner af poster med rå data.

Hvordan hjælper denne teknologi dig med at vokse i din karriere?

Mange organisationer implementerer Apache Pig utroligt hurtigt. Dette betyder, at erhverv inden for gris og svinekarriere løfter hver dag. Der er sket enorme fremskridt med udviklingen af Apache Hadoop inden for de sidste par år. Hadoop-elementer ligesom Hive, Pig, HDFS, HBase, MapReduce og så videre.

Selvom Hadoop-tilbud kom ind i deres andet årti på dette tidspunkt endnu, er eksploderet i anerkendelse gennem de foregående tre til fire år. Et stort antal softwarevirksomheder anvender Hadoop-klynger utroligt ofte. Dette kan bestemt være den bedste del af big data. De målrettede eksperter kunne blive erfarne med denne fremragende teknologi.

Konklusion

Apache Pig Expertise er i stort krav på markedet og kan fortsat være til udvidet. Ved blot at forstå begreberne såvel som at få erfaring med de bedste Apache Pig i Hadoop-færdigheder, kan eksperterne måske engagere sig i deres Apache Pig-erhverv.

Anbefalet artikel

Dette har været en guide til Hvad er svin? Her diskuterede vi koncepter, definition og arkitektur med funktionerne i svin. Du kan også gennemgå vores andre foreslåede artikler for at lære mere -

- Sådan installeres Apache

- Spørgsmål om Apache PIG-interview

- Hvad er ASP.Net Web Services?

- Hvad er Blockchain-teknologi?