Hvad er NLP i Python?

Kunstig intelligens har udviklet sig enormt i det sidste årti, og det samme er et af dets underområder - Natural Language Processing. Fremskridt i AI er et resultat af den moderne beregningskapacitet i de moderne systemer og de store mængder ustrukturerede data, der bliver genereret fra et væld af kilder. Natural Language Processing eller NLP er studiet af AI, der gør det muligt for computere at behandle rå ustrukturerede tekstdata og udtrække skjulte indsigter fra det.

Definition

I modsætning til mennesker er computere ikke smarte nok til at behandle ustrukturerede data. Mennesker kunne udlede betydninger fra sådanne data, mens computere kun kunne gøre det med de strukturerede data, der er gemt i databaserne. For at finde mønstre og udlede mening fra naturlige data bruger computere de værktøjer og teknikker, der er involveret i NLP til at behandle sådanne data.

Hvordan fungerer NLP i Python?

Det er meget komplekst at læse og forstå engelsk. Nedenstående sætning er et sådant eksempel, hvor det virkelig er vanskeligt for computeren at forstå den faktiske tanke bag sætningen.

I Machine Learning er der bygget en pipeline til hvert problem, hvor hvert stykke af et problem løses separat ved hjælp af ML. Det endelige resultat ville være kombinationen af flere maskinlæringsmodeller, der er sammenkoblet. Natural Language Processing fungerer på samme måde som det, hvor den engelske sætning er opdelt i bidder.

Der er flere kendsgerninger til stede i dette afsnit. Det ville have været let, hvis computere selv kunne forstå, hvad London er, men til at gøre det, skal computere trænes med grundlæggende koncepter på skriftsprog.

1. Setningssegmentering - Korpuset er opdelt i flere sætninger som nedenfor.

Dette ville gøre vores liv lettere, da det er bedre at behandle en enkelt sætning end et afsnit som helhed. Opdelingen kunne ske på baggrund af tegnsætning eller flere andre komplicerede teknikker, der også fungerer på urensede data.

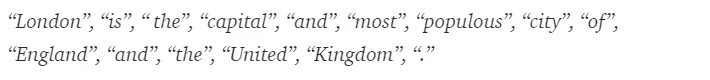

2. Ordtokenisering - En sætning kunne yderligere opdeles i symbolet på ord som vist nedenfor.

Efter tokenisering er ovenstående sætning opdelt i -

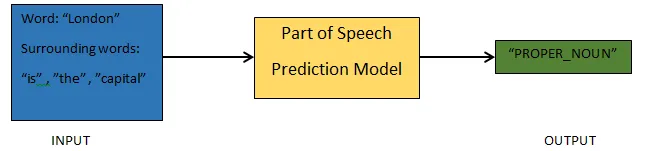

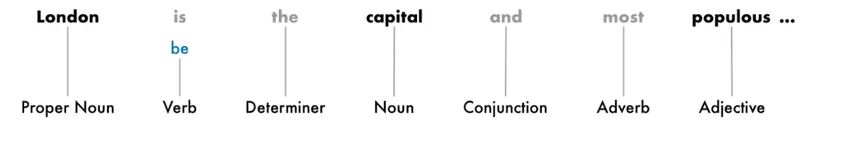

3. Dele af tale forudsigelse - Denne proces handler om at generere dele af talen for hvert token. Dette vil gøre det muligt for os at forstå betydningen af sætningen og det emne, der omtales i sætningen.

4. Lemmatisering - Et ord i en sætning kan forekomme i forskellige former. Lemmatisering sporer et ord tilbage til dets rod, dvs. lemmaet for hvert ord.

5. Stop ordidentifikation - Der er mange fyldstoford som 'den', 'a' i en sætning. Disse ord fungerer som støj i en tekst, hvis betydning vi prøver at udtrække. Det er derfor nødvendigt at filtrere disse stopord for at opbygge en bedre model.

Baseret på applikationen kan stopordene variere. Der er dog en foruddefineret liste over stopværker man kunne henvise til.

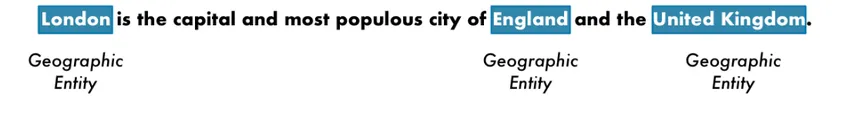

6. Navngivet enhedsgenkendelse - NER er processen med at finde enheder som navn, sted, person, organisation osv. Fra en sætning.

Konteksten med udseendet af et ord i en sætning bruges her. For at hente strukturerede data ud af en tekst har NER-systemer mange anvendelser.

Eksempel på NLP i Python

De fleste virksomheder er nu villige til at behandle ustrukturerede data for væksten i deres forretning. NLP har en bred vifte af anvendelser, og af de mest almindelige anvendelsessager er Tekstklassificering.

Klassificeringen af tekst i forskellige kategorier kaldes automatisk tekstklassificering. Registrering af spam eller skinke i en e-mail, kategorisering af nyhedsartikler, er nogle af de almindelige eksempler på tekstklassificering. De data, der bruges til dette formål, skal mærkes.

De få trin i en tekstklassificeringspipeline, der skal følges, er -

- Indlæsningen og forbehandlingen af dataene er det første trin, og derefter vil de blive opdelt i tog og valideringssæt.

- Feature Engineering-trinet involverer at udtrække de nyttige funktioner eller oprette yderligere meningsfulde funktioner, der kan hjælpe med at udvikle en bedre forudsigelsesmodel.

- For at opbygge modellen bruges det mærkede datasæt til at træne modellen.

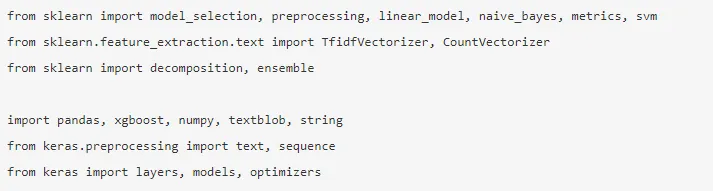

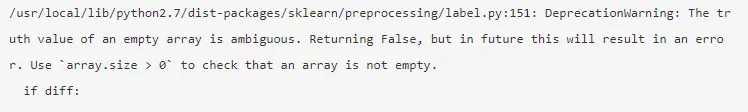

Pandas, Scikit-learning, XGBoost, TextBlog, Keras er få af de nødvendige biblioteker, vi har brug for at installere. Derefter importerede vi bibliotekerne til datasætforberedelse, funktionsudvikling osv.

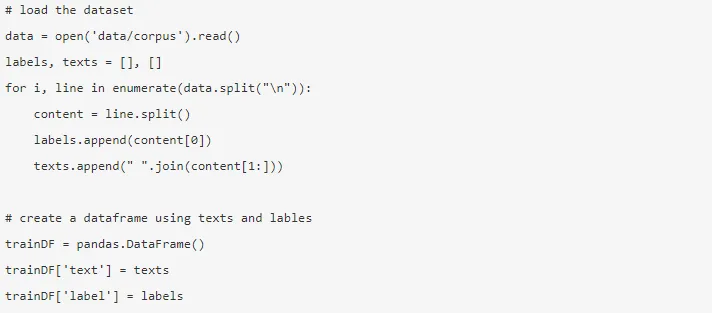

Dataene er enorme med næsten 3, 6 millioner anmeldelser kunne downloades herfra. En brøkdel af dataene bruges. Det downloades og læses i en Pandas-dataramme.

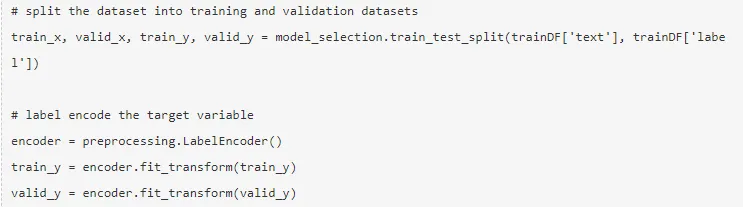

Målvariablen er kodet, og dataene opdeles i tog og testsæt.

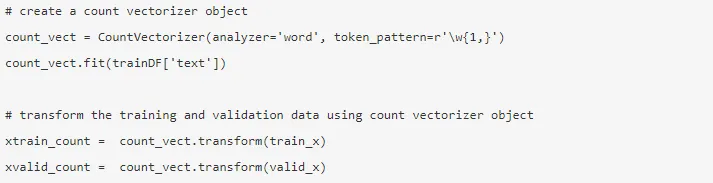

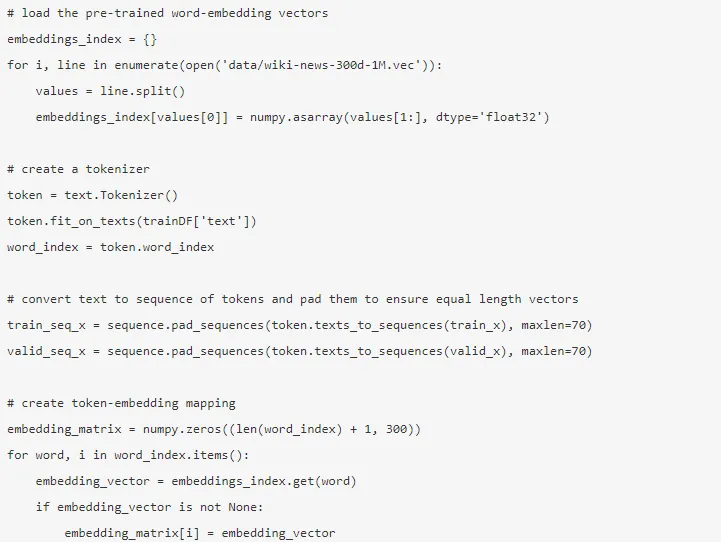

Funktionsteknik udføres ved hjælp af nedenstående forskellige metoder.

1. Tælvektorer - Repræsentationen af et dokument, et udtryk og dets frekvens fra et korpus opnås af tællevektorerne.

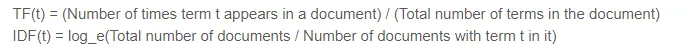

2. TF-IDF-vektorer - I et dokument er den relative betydning af et udtryk repræsenteret af udtrykket Frekvens (TF) og indverset dokumentfrekvens (IDF). TF-IDF kunne beregnes ved -

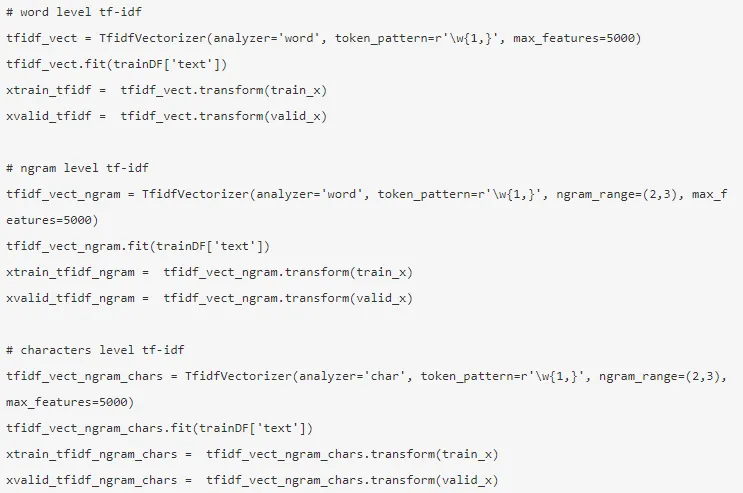

TF-IDF-vektorerne kunne genereres ved hjælp af Word-niveau, der viser score for hvert sigt, og N-gramniveauet, som er kombinationen af n-termer.

3. Ordindlejring - Repræsentationen af dokumenter og ord i form af en tæt vektor kaldes ordindlejring. Der er foruddannet indlejring såsom handske, Word2Vec, som kunne bruges, eller det kan også trænes.

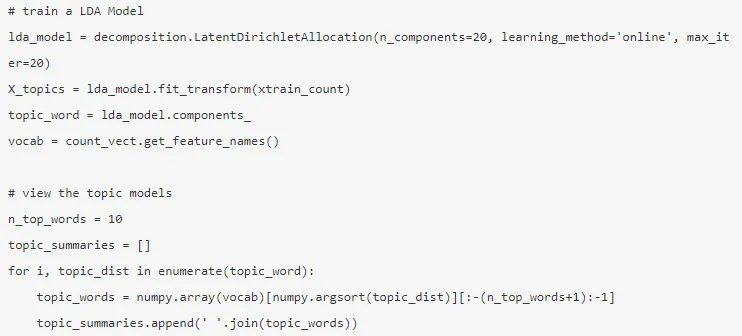

4. Emnemodeller - Det er gruppen af ord fra et dokument, der bærer mest information. Den latente Dirichlet-tildeling bruges her til emnemodellering.

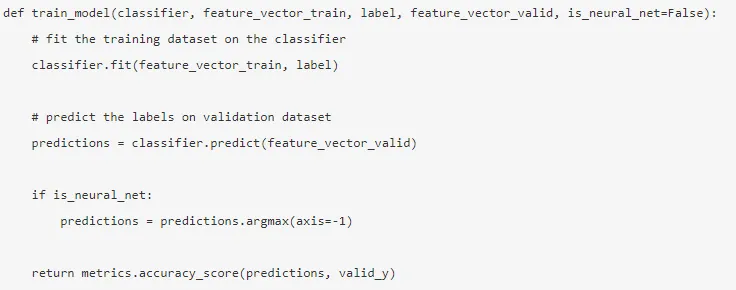

Tilstanden er bygget efter, at funktionen er udført, og de relevante funktioner er blevet uddraget.

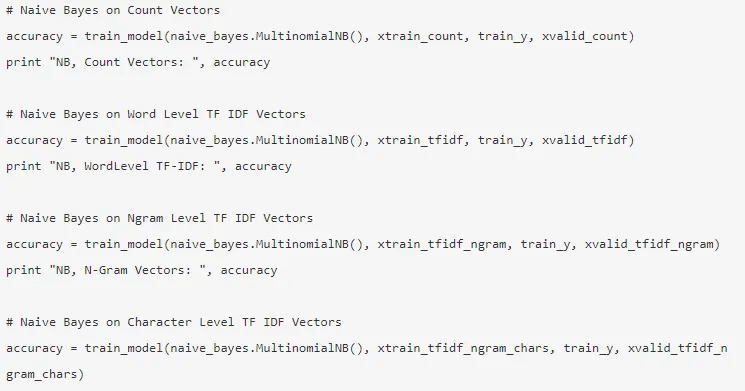

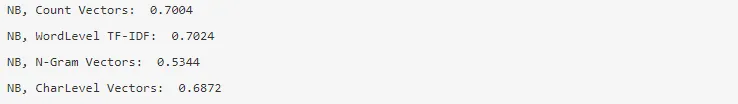

5. Naïve Bayes - Det er baseret på Bayes sætning, og algoritmen mener, at der ikke er noget forhold mellem funktionerne i et datasæt.

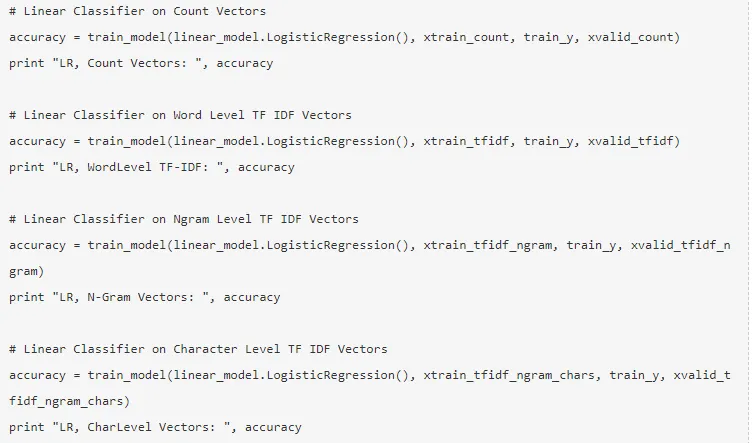

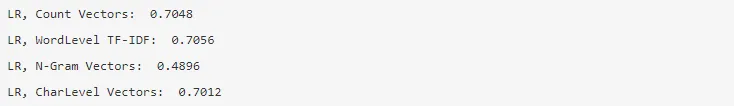

6. Logistisk regression - Det måler det lineære forhold mellem funktionerne, og målvariablen måles baseret på en sigmoid-funktion, der estimerer sandsynlighederne.

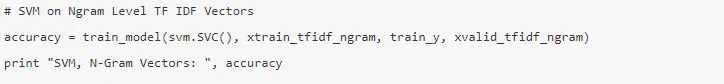

7. Support Vector Machine - Et hyperplan adskiller to klasser i en SVM.

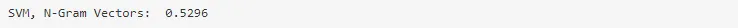

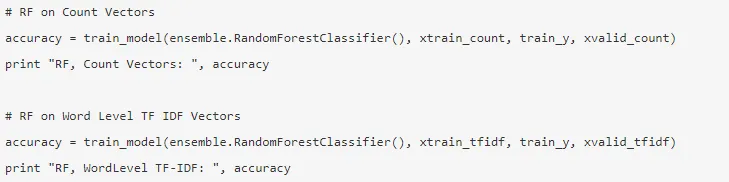

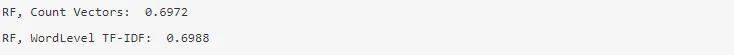

8. Tilfældig skovmodel - En ensemblemodel, hvor reducerer variansen og poser flere beslutningstræer sammen.

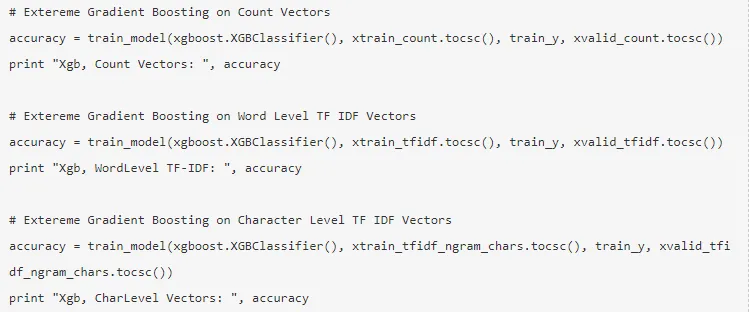

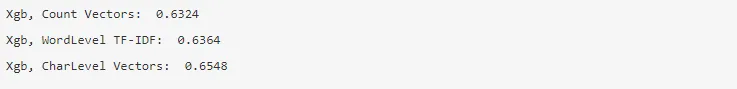

9. XG Boost - Bias reduceres, og svage elever konverteres til stærke.

Hvordan NLP ville hjælpe dig i din karriere?

Natural Language Processing er et blomstrende felt på markedet, og næsten enhver organisation har brug for en NLP Engineer til at hjælpe dem med at behandle rå data. Derfor er det bydende nødvendigt at mestre de krævede færdigheder, da der ikke ville være mangel på job på markedet.

Konklusion: NLP i Python

I denne artikel startede vi med en introduktion til NLP i Python og implementerede derefter en brugssag i Python for at vise, hvordan man arbejder med NLP i Python.

Anbefalede artikler

Dette har været en guide til NLP i Python. Her diskuterede vi eksemplet, Brug sager, og hvordan man arbejder med NLP i Python. Du kan også gennemgå vores andre foreslåede artikler for at lære mere -

- Anvendelser af Python

- Hvad er WBS?

- Python vs Scala

- Hvad er Tableau?