Hvad er Hadoop?

Før du forstå fordelene ved Hadoop, skal du først forstå Hadoop. Hadoop er et stort databehandlingsparadigme, der giver et pålideligt, skalerbart sted til datalagring og -behandling. Hadoop blev skabt af Doug Cutting, og han betragtes som "Hadoop's far". Hadoop var navnet på hans søns legetøjselefant. Hadoop havde sine rødder i Nutch Search Engine Project. Hadoop er en behandlingsramme, der bragte enorme ændringer i den måde, vi behandler dataene på, og hvordan vi lagrer dataene. Sammenlignet med traditionelle behandlingsværktøjer som RDBMS, beviste Hadoop, at vi effektivt kan bekæmpe udfordringerne ved Big data som,

Forskellige data: Hadoop kan gemme og behandle strukturerede såvel som semistrukturerede og ustrukturerede formater af data.

Datavolumen: Hadoop er specielt designet til at håndtere den enorme mængde data i området petabytes.

Datahastigheden : Hadoop kan behandle petabytes med data med høj hastighed sammenlignet med andre behandlingsværktøjer som RDBMS, dvs. behandlingstid i Hadoop er meget mindre.

Fremtrædende træk ved Hadoop

- Hadoop er open source i naturen.

- Det fungerer på en klynge af maskiner. Størrelsen på klyngen afhænger af kravene.

- Det kan køre på normal råvarehardware.

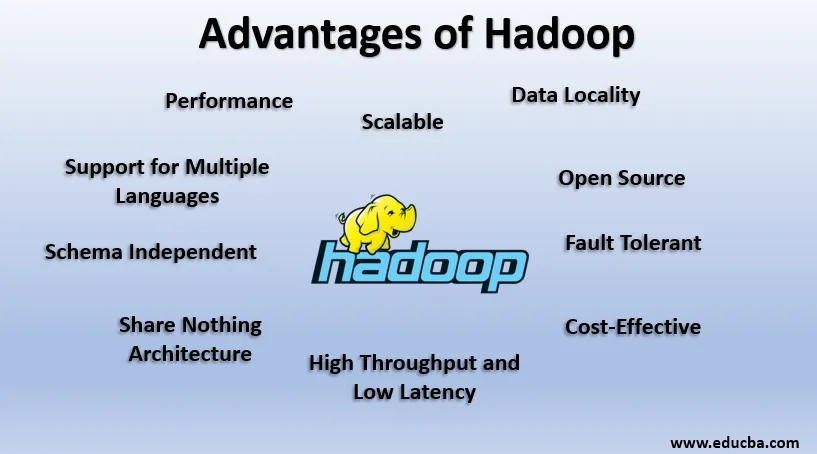

Fordele ved Hadoop

I dette afsnit diskuteres fordelene ved Hadoop. Lad os nu se på dem én efter én:

1. Open Source

Hadoop er open source i naturen, dvs. dens kildekode er frit tilgængelig. Vi kan ændre kildekoden i henhold til vores forretningskrav. Selv proprietære versioner af Hadoop som Cloudera og Horton-værker er også tilgængelige.

2. skalerbar

Hadoop arbejder på klyngen af maskiner. Hadoop er meget skalerbar. Vi kan øge størrelsen på vores klynge ved at tilføje nye knudepunkter pr. Krav uden nedetid. Denne måde at tilføje nye maskiner til klyngen er kendt som Horisontal skalering, mens stigende komponenter som fordobling af harddisk og RAM er kendt som Lodret skalering.

3. Fejltolerant

Fejltolerance er det fremtrædende træk ved Hadoop. Som standard har hver enkelt blok i HDFS en replikationsfaktor på 3. For hver datablok opretter HDFS to yderligere kopier og gemmer dem et andet sted i klyngen. Hvis der mangler nogen blok på grund af maskinfejl, har vi stadig to yderligere kopier af den samme blok, og disse bruges. På denne måde opnås fejltolerance i Hadoop.

4. Uafhængigt skema

Hadoop kan arbejde på forskellige typer data. Den er fleksibel nok til at gemme forskellige formater af data og kan arbejde på både data med skema (struktureret) og skemaløse data (ustruktureret).

5. Høj kapacitet og lav latens

Gennemstrømning betyder mængde arbejde udført pr. Enhedstid og lav latenstid betyder at behandle data uden forsinkelse eller mindre forsinkelse. Eftersom Hadoop er drevet af princippet om distribueret lagring og parallel behandling, udføres behandlingen samtidig på hver datablock og uafhængig af hinanden. I stedet for at flytte data flyttes kode til data i klyngen. Disse to bidrager til High Throughput og Low Latency.

6. Datalokalitet

Hadoop fungerer på princippet om “Flyt koden, ikke data”. I Hadoop forbliver data stationær, og til behandling af data flyttes kode til data i form af opgaver, dette kaldes datalokalitet. Da vi beskæftiger os med data i området petabytes, bliver det både vanskeligt og dyrt at flytte dataene over netværket, Data lokalitet sikrer, at dataforflytning i klyngen er minimal.

7. Ydeevne

I Legacy-systemer som RDBMS behandles data sekventielt, men i Hadoop starter behandlingen på alle blokke på en gang, hvorved der gives parallel behandling. På grund af parallelle behandlingsteknikker er ydelsen af Hadoop meget højere end Legacy-systemer som RDBMS. I 2008 besejrede Hadoop endda den hurtigste supercomputer til stede på det tidspunkt.

8. Del intet arkitektur

Hver knude i Hadoop-klyngen er uafhængig af hinanden. De deler ikke ressourcer eller opbevaring, denne arkitektur er kendt som Share Nothing Architecture (SN). Hvis en knude i klyngen mislykkes, nedbringer den ikke hele klyngen, da hver knude fungerer uafhængigt, hvilket eliminerer et enkelt mislykkelsespunkt.

9. Support til flere sprog

Selvom Hadoop for det meste blev udviklet i Java, udvider den understøttelsen til andre sprog som Python, Ruby, Perl og Groovy.

10. Omkostningseffektiv

Hadoop er meget økonomisk. Vi kan opbygge en Hadoop-klynge ved hjælp af normal råvaremaskine og derved reducere hardwareomkostninger. I henhold til Cloud-æraen er Data Management-omkostningerne til Hadoop, dvs. både hardware og software og andre udgifter meget minimale sammenlignet med traditionelle ETL-systemer.

11. Abstraktion

Hadoop leverer abstraktion på forskellige niveauer. Det gør jobbet lettere for udviklere. En stor fil er opdelt i blokke af samme størrelse og gemt forskellige steder i klyngen. Mens vi opretter en kortreducerende opgave, er vi nødt til at bekymre os om placeringen af blokke. Vi giver en komplet fil som input, og Hadoop-rammen tager sig af behandlingen af forskellige blokke af data, der er forskellige steder. Hive er en del af Hadoop Ecosystem, og det er en abstraktion øverst på Hadoop. Da Map-Reduce-opgaver er skrevet i Java, kunne SQL-udviklere over hele kloden ikke drage fordel af Map Reduce. Så Hive introduceres for at løse dette problem. Vi kan skrive SQL-lignende forespørgsler på Hive, som igen udløser Kort reducere job. Så på grund af Hive er SQL-samfundet også i stand til at arbejde med Map Reduce Tasks.

12. Kompatibilitet

I Hadoop er HDFS lagringslaget, og Map Reduce er behandlingsmotoren. Men der er ingen stiv regel om, at Map Reduce skal være standard Processing Engine. Nye behandlingsrammer som Apache Spark og Apache Flink bruger HDFS som et lagringssystem. Selv i Hive kan vi også ændre vores eksekveringsmotor til Apache Tez eller Apache Spark i henhold til vores krav. Apache HBase, som er NoSQL Columnar Database, bruger HDFS til lagringslaget.

13. Support til forskellige filsystemer

Hadoop er meget fleksibel i naturen. Det kan indtage forskellige formater af data som billeder, videoer, filer osv. Det kan også behandle strukturerede og ustrukturerede data. Hadoop understøtter forskellige filsystemer som JSON, XML, Avro, Parket osv.

Arbejde med Hadoop

Nedenfor er de punkter, der viser, hvordan Hadoop fungerer:

1. Distribueret lagring og parallel behandling

Dette er drivprincippet for alle rammer i Hadoop økosystemet inklusive Apache Spark. For først at forstå, hvad Hadoop og Spark fungerer, skal vi først forstå, hvad der er "Distribueret opbevaring og parallel behandling".

2. Distribueret opbevaring

Hadoop gemmer ikke data i en enkelt maskine. I stedet bryder den de enorme data op i blokke af samme størrelse, som er 256 MB som standard, og gemmer disse blokke i forskellige noder i en klynge (arbejderknudepunkter). Det gemmer metadataene for disse blokke i hovednoden. Denne måde at lagre filen på distribuerede placeringer i en klynge kaldes Hadoop distribueret filsystem - HDFS.

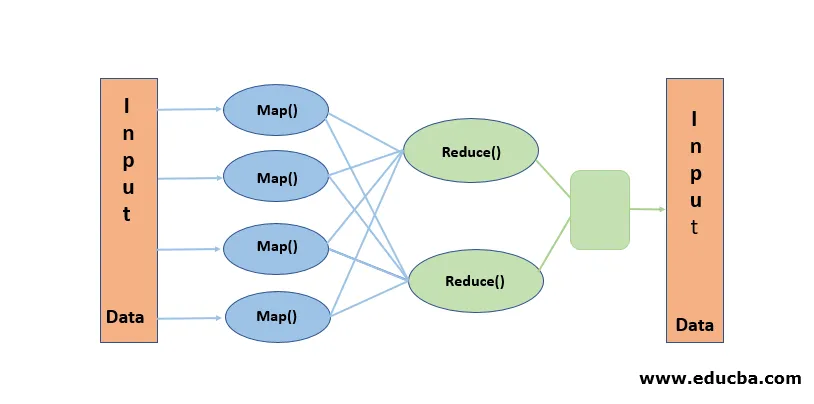

3. Parallel behandling

Det er et Processing-paradigme, hvor behandlingen udføres samtidig på de blokke af data, der er gemt i HDFS. Parallel behandling fungerer på forestillingen om “Flyt koden, ikke data”. Data forbliver stationære i HDFS, men koden flyttes til data til behandling. Enkelt sagt, hvis vores fil er opdelt i 100 blokke, oprettes 100 kopier af jobbet, og de rejser over klyngen til det sted, hvor blokken er bosiddende og behandlingen på 100 blokke starter samtidig (kortfase). Outputdata fra alle blokke indsamles og reduceres til den endelige output (Reducer fase). Kortnedsættelse betragtes som ”Heart of Hadoop”.

Konklusion-Fordele ved Hadoop

I denne Data-tid banede Hadoop vejen for en anden tilgang til udfordringer fra Big data. Når vi siger, Hadoop, vi mener ikke Hadoop alene, det inkluderer Hadoop økosystemværktøjer som Apache Hive, som leverer SQL-lignende operationer oven på Hadoop, Apache Pig, Apache HBase til Columnar lagringsdatabase, Apache Spark til behandling i hukommelsen og mange mere. Selvom Hadoop har sine egne ulemper, er den meget tilpasningsdygtig og udvikler sig konstant med hver udgivelse.

Anbefalede artikler

Dette er en guide til Hadoop's fordele. Her diskuterer vi, hvad der er Hadoop og de bedste fordele ved Hadoop. Du kan også gennemgå vores andre relaterede artikler for at lære mere-

- HADOOP-rammer

- Hvad er Hadoop Cluster?

- Hvad er MapReduce i Hadoop?

- Hadoop-database

- Hvad er Hadoop? | Programmer og funktioner