Introduktion til klassificeringsalgoritmer

Denne artikel om klassificeringsalgoritmer giver en oversigt over forskellige klassificeringsmetoder, der ofte bruges i dataminingsteknikker med forskellige principper. Klassificering er en teknik, der kategoriserer data i et distinkt antal klasser og til gengæld tildeles etiketten til hver klasse. Klassifikationens hovedmål er at identificere klassen til at lancere nye data ved analyse af træningssættet ved at se passende grænser. På en generel måde kaldes klassificering af forudsigelse af målklassen og ovennævnte proces.

F.eks. Registrerer hospitalets ledelse patientens navn, adresse, alder, tidligere historie om patientens helbred for at diagnosticere dem, dette hjælper med at klassificere patienterne. De kan karakteriseres i to faser: en læringsfase og evalueringsfase. Læringsfasemodeller tilnærmelsesbasen donerer en træningsdata, mens evalueringsfasen forudsiger output for de givne data. Vi kunne finde deres applikationer i e-mail spam, banklån forudsigelse, talegenkendelse, sentiment analyse. Teknikken inkluderer matematisk funktion f med input X og output Y.

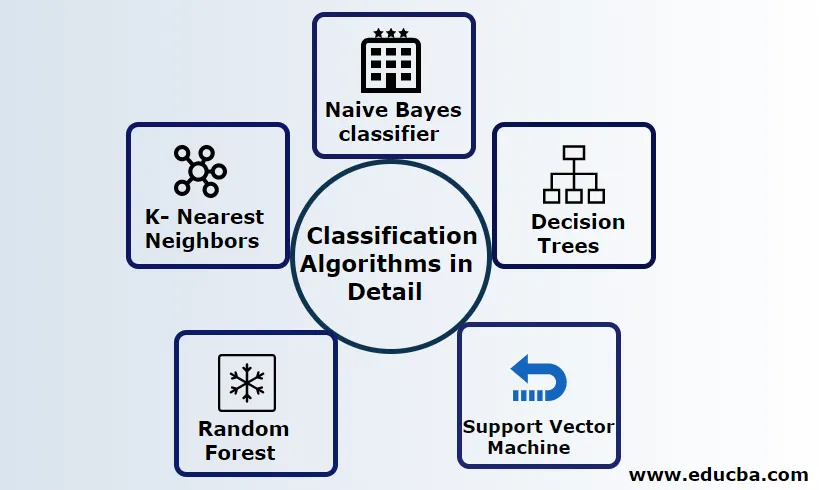

Forklar klassificeringsalgoritmer i detaljer

Klassificering kan udføres på både strukturerede og ustrukturerede data. Klassificering kan kategoriseres i

- Naive Bayes klassifikator

- Beslutningstræer

- Support vektormaskine

- Tilfældig skov

- K - Nærmeste naboer

1) Naive Bayes klassificering

Det er en Bayes 'teorem-baserede algoritme, en af de statistiske klassifikationer og kræver få mængder af træningsdata for at estimere parametrene, også kendt som sandsynlige klassifikatorer. Det betragtes som den hurtigste klassificering, meget skalerbar og håndterer både diskrete og kontinuerlige data. Denne algoritme bruges til at forudsige i realtid. Der er forskellige typer af naive klassifikatorer, multinomiale naive bugter, Bernoulli naive bugter, gaussiske naive.

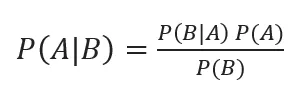

Bayesisk klassificering med posterior sandsynligheder er givet af

Hvor A, B er begivenheder, P (A | B) - Posterior sandsynligheder.

Hvis to værdier er uafhængige af hinanden,

P (A, B) = P (A) P (B)

Naive Bayes kan bygges ved hjælp af python-biblioteket. Naïves forudsigere er uafhængige, skønt de bruges i anbefalingssystemer. De bruges i mange realtidsapplikationer og bruges velbevidst til dokumentklassificering.

Fordele:

Fordelene er, at de kræver meget mindre computerkraft, antaget i flere klasseforudsigelsesproblemer, fungerer nøjagtigt på store datasæt.

Ulempe:

Den største ulempe ved denne klassificer er, at de tildeler nul-sandsynlighed. Og de har funktioner med er uafhængige af hinanden.

2) Beslutningstræ

Det er en top-down tilgangsmodel med strukturen i flow-chart håndterer højdimensionelle data. Resultaterne er forudsagt baseret på den givne inputvariabel. Beslutningstræ sammensat af følgende elementer: En rod, mange knuder, grene, blade. Rodenoden udfører partitionen baseret på attributværdien for klassen, den interne knude tager en attribut til yderligere klassificering, grene træffer en beslutningsregel om at opdele knudepunkterne i bladknudder, til sidst giver bladknudene os det endelige resultat. Beslutningstræets tidskompleksitet afhænger af antallet af poster, attributter for træningsdataene. Hvis beslutningstræet er for langt, er det vanskeligt at få de ønskede resultater.

Fordel: De anvendes til forudsigelig analyse for at løse problemerne og bruges i daglige til daglige aktiviteter til at vælge målet baseret på beslutningsanalyse. Bygger automatisk en model baseret på kildedataene. Bedst til håndtering af manglende værdier.

Ulempe: Træets størrelse er ukontrollerbar, indtil det har nogle stopkriterier. På grund af deres hierarkiske struktur er træet ustabilt.

3) Support Vector Machine

Denne algoritme spiller en vigtig rolle i klassificeringsproblemer og mest populært er en maskinlæring overvågede algoritmer. Det er et vigtigt værktøj brugt af forskeren og dataforskeren. Denne SVM er meget let, og dens proces er at finde et hyperplan i et N-dimensionelt rumdatapunkter. Hyperplaner er beslutningsgrænser, der klassificerer datapunkterne. Al denne vektor falder tættere på hyperplanet, maksimere klassificeringsmargenen. Hvis margenen er maksimal, er den laveste generaliseringsfejl. Deres implementering kan udføres med kernen ved hjælp af python med nogle træningsdatasæt. SVM's hovedmål er at træne et objekt i en bestemt klassificering. SVM er ikke begrænset til at blive en lineær klassificering. SVM foretrækkes mere end nogen klassificeringsmodel på grund af deres kernefunktion, der forbedrer beregningseffektiviteten.

Fordel: De foretrækkes meget på grund af dens mindre computerkraft og effektive nøjagtighed. Effektiv i højdimensionelt rum, god hukommelseseffektivitet.

Ulempe: Begrænsninger i hastighed, kerne og størrelse

4) Tilfældig skov

Det er en kraftfuld maskinlæringsalgoritme, der er baseret på læringsmetoden Ensemble. Den grundlæggende byggesten til tilfældig skov er det beslutnings træ, der bruges til at bygge forudsigelige modeller. Arbejdsdemonstrationen inkluderer at skabe en skov af tilfældige beslutningstræer, og beskæringsprocessen udføres ved at indstille en stoppespaltning for at give et bedre resultat. Tilfældig skov implementeres ved hjælp af en teknik kaldet bagging til beslutningstagning. Denne bagging forhindrer overanvendelse af data ved at reducere bias på lignende måde denne tilfældige kan opnå bedre nøjagtighed. En endelig forudsigelse er taget af et gennemsnit af mange beslutningstræer, dvs. hyppige forudsigelser. Den tilfældige skov inkluderer mange anvendelsessager som aktiemarkedsforudsigelser, bedrageri afsløring, nyheder forudsigelser.

Fordele:

- Kræver ikke nogen stor behandling for at behandle datasættene og en meget nem model at opbygge. Giver større nøjagtighed hjælper med at løse forudsigelige problemer.

- Arbejder godt til håndtering af manglende værdier og registrerer automatisk en outlier.

Ulempe:

- Kræver høje beregningsomkostninger og høj hukommelse.

- Kræver meget mere tidsperiode.

5) K - nærmeste naboer

Her vil vi diskutere K-NN algoritmen med overvåget indlæring til CART. De bruger K-positivt lille heltal; et objekt tildeles klassen baseret på naboerne, eller vi siger at tildele en gruppe ved at observere i hvilken gruppe nabo ligger. Dette vælges ved afstandsmål Euklidisk afstand og en brute kraft. Værdien af K kan findes ved hjælp af Tuning-processen. KNN foretrækker ikke at lære nogen model til at træne et nyt datasæt og bruge normalisering til at omskalere data.

Fordel: Giver effektive resultater, hvis træningsdataene er enorme.

Ulempe: Det største problem er, at hvis variablen er lille, fungerer den godt. For det andet at vælge K-faktor, mens du klassificerer.

Konklusion

Afslutningsvis har vi gennemgået mulighederne i forskellige klassificeringsalgoritmer fungerer stadig som et kraftfuldt værktøj inden for funktionsingeniør, billedklassificering, der spiller en stor ressource til maskinlæring. Klassificeringsalgoritmer er kraftfulde algoritmer, der løser hårde problemer.

Anbefalede artikler

Dette er en guide til klassificeringsalgoritmer i maskinlæring. Her diskuterer vi, at klassificeringen kan udføres på både strukturerede og ustrukturerede data. Du kan også gennemgå vores andre foreslåede artikler -

- Routing-algoritmer

- Clustering algoritme

- Data Mining Process

- Maskinlæringsalgoritmer

- Mest anvendte teknikker til ensemblæring

- C ++ algoritme | Eksempler på C ++ algoritme