Introduktion til Sqoop-kommandoer

I Sqoop-kommandoer behandles hver række som poster, og opgaverne er opdelt i underopgaver af Map Task Intern. Databaserne, der understøttes af sqoop, er MYSQL, Oracle, IBM, PostgreSQL. Sqoop giver en simpel kommandolinje, vi kan hente data fra de forskellige databaser via sqoop-kommandoer. De er skrevet i Java og bruger JDBC til forbindelse til andre databaser.

Det står for 'SQL til Hadoop' og Hadoop til SQL og et open source værktøj. Det er et applikations com-forbindelsesværktøj, der overfører bulkdata mellem det relationelle databasesystem og Hadoop (Hive, kortreduktion, Mahout, Pig, HBase). De giver brugerne mulighed for at specificere målplacering inde i Hadoop og lave sqoop for at flytte data fra RDMS til mål. De leverer optimerede MySQL-stik, der bruger databasespecifik API til at udføre bulkoverførsler fuldstændigt. Brugeren importerer data fra eksterne kilder som Hive eller Hbase. Sqoop har to filformater: afgrænset tekstfilformat og sekvensfilformat.

Her er de grundlæggende kommandoer i Sqoop-kommandoer:

-

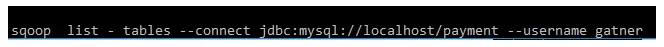

Listetabel:

Denne kommando viser en bestemt tabel i databasen på MYSQL-server.

Eksempel:

-

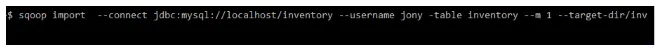

Målmappe:

Denne kommando importerer tabel i et specifikt bibliotek i HDFS. -m angiver mapper-argument. De har en heltalværdi.

Eksempel:

-

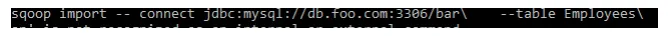

Adgangskodebeskyttelse:

Eksempel:

-

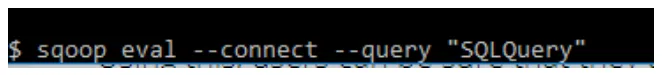

sqoop-eval:

Denne kommando kører hurtigt SQL-forespørgsler i den respektive database.

Eksempel:

-

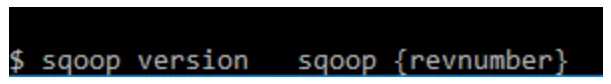

sqoop - version:

Denne kommando viser version af sqoop.

Eksempel:

-

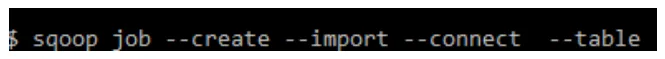

sqoop-job

Denne kommando giver os mulighed for at oprette et job, de parametre, der oprettes, kan tilkaldes når som helst. De tager indstillinger som (–oprettelse, –delet, –show, –afgang).

Eksempel:

-

Indlæser CSV-fil til SQL:

Eksempel:

-

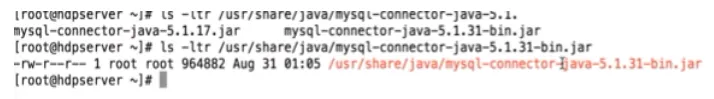

Stik:

Eksempel:

-

kode gen:

Denne Sqoop-kommando opretter java-klassefiler, der indkapsler de importerede poster. Alle java-filer gendannes, og nye versioner af en klasse genereres. De genererer kode for at interagere med databaseposter. Henter en liste over alle kolonner og deres datatyper.

Eksempel:

10.List-database:

Denne Sqoop-kommandolister har al den tilgængelige database på RDBMS-serveren.

eksempel:

Mellemkommandoer for Sqoop-kommandoer:

1.sqoop-meta butik:

Denne kommando er vært for et delt metadata-lager. Flere / fjernbrugere kan køre flere job.

Kommando:

$ sqoop .metastore.client.autoconnect.url

eksempel: jdbc: hsqldb: hsql: // metastore .example.com / sqoop

2. sqoop-hjælp:

Denne kommando viser de tilgængelige værktøjer i sqoop og deres formål.

Kommando:

$ sqoop hjælp

$ bin / sqoop hjælpimport

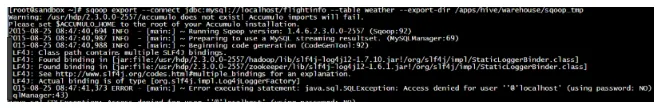

3. Eksport:

Denne kommando eksporterer data fra HDFS til RDMS-databasen. I HDFS gemmes data som poster.

Kommando:

$ sqoop eksport \ –forbindelse jdbc: mysql: // localhost / inventar - brugernavn jony –tabel lib –eksport -dir / bruger / jony / inventar.

4. Indsæt:

Denne kommando indsætter en ny post fra HDFS til RDBMS-tabel.

Kommando

$ sqoop eksport –forbinde JDBC: MySQL: // localhost / sqoop_export - tabel emp_exported –eksport -dir / sqoop / newemp -m -000

5. Opdatering:

Denne Sqoop-kommando opdaterer posterne i RDBMS fra HDFS-data.

Kommando

$ sqoop eksport –forbind JDBC: MySQL: // localhost / sqoop_export - tabel emp_exported –eksport -dir / sqoop / newemp -m -000 –update -key id

6. Batch-option:

Denne kommando indsætter flere rækker sammen, de optimerer indsættelseshastigheden ved hjælp af Sqoop JDBC driver.

Kommando

$ sqoop eksport \ -forbinde JDBC: MySQL: // hostname / –usname -password -export -dir

7. Opdeling:

Når denne kommando bruges, anvendes der-klausulen på hele SQL.

Kommando

$ sqoop import -D mysql: // jdbc: // hvor.clause.location = SPLIT –tabel JUNK – hvor “rownum <= 12”

8. AVRO-fil til HDFS:

De gemmer RDBMS-data som en Avro-fil.

Kommando

$ sqoop import –forbinde JDBC: MySQL: // localhost / Acadgild –username root –password pp.34 –Tabel betaling -m1 – Target -dir / sqoop_data / Payment / avro / == som -avrodatfile.

Avancerede kommandoer for Sqoop-kommandoer:

Importer kommandoer:

Importkommandoer har importkontrolargumenter. de forskellige argumenter er som følger:

- grænse: bruges til at oprette splitter.

- som - tekstfil: importerer almindelig tekstdata

- -kolonner (: importer kolonner til tabel

- -m, - num: til at importere parallelle kortlægningsopgaver

- split-by: Splits kolonne i tabellen

- -z, - komprimering: komprimering af dataene er aktiveret.

Trinvis import Argumenter:

- check - column: Angiver kolonner for at bestemme, hvilke rækker der skal importeres.

- trinvis (tilstand): angiver nye rækker (inkluderer tilføj og sidst ændrer rækker)

Output Line Arguments:

- linjer -termineret -by: De indstiller eol-karakter

- MySQL - afgrænsere: de indstiller \ n felter: linjer:

Importer til Hive

-hive - import: De importerer tabeller til bikube

-hive - partition-key: Navnet på partitionen deles.

-hive - overskrive: De overskriver dataene i den eksisterende tabel.

Importer til Hbase-argumenter:

-accumulo-table: Dette specificerer måltabellen i HBase.

-accumulo-kolonne: Hvis du vil importere den, indstilles målsøjlen.

-accumulo -: For at importere akkumulens navn

–Accumulo -: At importere adgangskode til akkumuloen

Lagring i sekvensfiler:

$ sqoop import -forbindelse jdbc: mysql: //db.foo.com/emp -tabel inventar \ - klasse-navn com.foo.com.Inventory -as - sequencefile

Forespørgselsimport:

Denne kommando specificerer Sql-sætningen med -forespørgselsargumentet.

$ sqoop import \ –forespørgsel 'VÆLG a. *, b. * fra en JOIN b on (a.id = b.id) hvor $ betingelser' \ -split - af / target-dir / user

Trinvis eksport:

$ sqoop eksport –forbindelse –tabel –brugernavn – adgangskode –Crementelt –check-række –last-værdi

Importerer alle tabeller til HDFS:

$ sqoop import -all - tabeller –forbind jdbc: mysql: // localhost / sale_db - brugernavn root.

Importerer data til Hive:

$ sqoop import –forbindelse –tabel –brugernavn – adgangskode –hive -import - hive -tabel

Importerer data til HBase:

kommando:

$ sqoop import –forbindelse –tabel –brugernavn – adgangskode –hive -import - HBase -tabel

Kod nulværdier:

kommando:

$ mysql import \ –forbinde JDBC: MySQL: //mysql.ex.com/sqoop \ –usname sqoop \ -password sqoop \ –tabel lib \ –null -string '

Tip og tricks til brug af Sqoop-kommandoer:

Hvis vi ønsker at udføre datafunktionerne effektivt, skal vi bruge sqoop, bare gennem en enkelt kommandolinie kan vi udføre mange opgaver og underopgaver i den. Sqoop opretter forbindelse til forskellige relationelle databaser gennem stik, de bruger JDBC-driveren til at interagere med den. Da sqoop kører på sin egen kilde, kan vi udføre sqoop uden en installationsproces. Udførelsen af sqoop er let, fordi der udføres dataene parallelt. Ved hjælp af Map reducering kan vi importere og eksportere data, som igen giver parallel udførelse.

Konklusion - Sqoop-kommandoer:

Afslutningsvis regulerer Sqoop Commands processen med at importere og eksportere dataene. Sqoop giver mulighed for at opdatere delene af tabellen med den trinvise belastning. Dataimporten i sqoop er ikke begivenhedsstyret. Og der kommer sqoop2 med aktiveret GUI til let adgang sammen med kommandolinjen. Dataoverførslen er hurtig, mens de overføres parallelt. De spiller en vigtig rolle i Hadoop-miljøet. De gør deres job på egen hånd, ikke nødvendigt, mens de importerer små datasæt.

Anbefalede artikler

Dette har været en guide til Sqoop-kommandoer. Her har vi drøftet grundlæggende såvel som avancerede Sqoop-kommandoer og nogle øjeblikkelige Sqoop-kommandoer. Du kan også se på den følgende artikel for at lære mere -

- Sqoop Interview Spørgsmål og svar

- Snyd ark SQL (kommandoer, gratis tip og tricks)

- Vigtige VBA-kommandoer

- Tableau-kommandoer