Introduktion til Hadoop Framework

Før vi dybt dykker ned i den tekniske ramme for Hadoop, vil vi starte med et simpelt eksempel.

Der er en gård, der høster tomater og lagrer dem i et enkelt lagerområde, nu med den stigende efterspørgsel efter grøntsager begyndte gården at høste kartofler, gulerødder - med stigende efterspørgsel var der en mangel på landmænd, så de ansat flere landmænd. Efter nogen tid opdagede de, at der var en mangel i lagerområdet - så de fordelte grøntsagerne i forskellige opbevaringsområder. Når det kommer til hentning af dataene, fungerer de alle parallelt med deres egen lagerplads.

Så hvordan denne historie er relateret til big data?

Tidligere havde vi begrænsede data med den begrænsede processor og en lagerenhed. Men så steg genereringen af data, hvilket førte til stort volumen og forskellige sorter - struktureret, semistruktureret og ustruktureret. Så løsningen var at bruge distribueret lagerplads til hver processor, hvilket gjorde det nemt at gemme og få adgang til data.

Så nu kan vi erstatte grøntsagerne som forskellige slags data og opbevaringssted som de distribuerede steder, hvor dataene kan opbevares, og forskellige arbejdere, der er hver processor.

Så store data er udfordringen, og Hadoop spiller en del af løsningen.

Hadoop

1. Løsning til STORE DATA: da den omhandler kompleksiteter af høj volumen, hastighed og forskellige data.

2. Sæt af open source-projektet.

3. Gemmer en enorm mængde data pålideligt og tillader enorme distribuerede beregninger.

4. Hadoops nøgleattributter er redundans og pålidelighed (absolut intet datatab).

5. Fokuserer primært på batchbehandling.

6. Kører på råvarehardware - du behøver ikke at købe noget specielt dyre hardware.

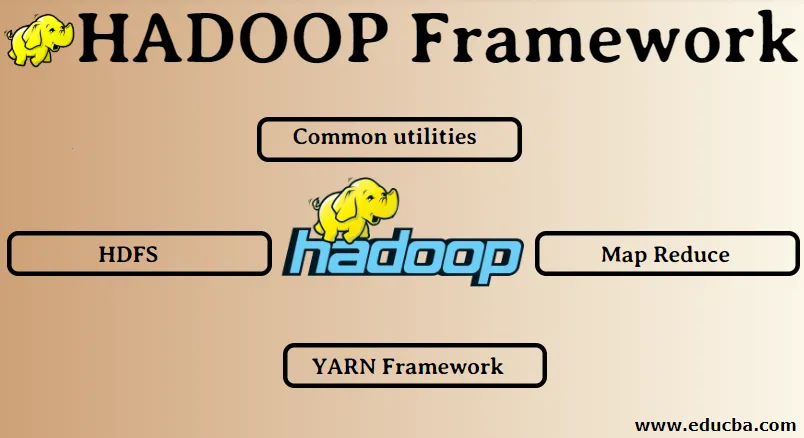

Hadoop Framework:

1. Fælles forsyningsselskaber

2. HDFS

3. Kort reducer

4. Garnramme

1. Almindelige hjælpeprogrammer:

Også kaldet Hadoop fælles. Dette er intet andet end JAVA-biblioteker, filer, scripts og værktøjer, der faktisk kræves af de andre Hadoop-komponenter til at udføre.

2. HDFS: Hadoop Distribueret filsystem

Hvorfor Hadoop har valgt at inkorporere et distribueret filsystem?

Lad os forstå dette med et eksempel: Vi er nødt til at læse 1 TB data, og vi har en maskine med 4 I / O-kanaler, hver kanal har 100 MB / s, det tog 45 minutter at læse hele dataene. Nu læses den samme mængde data af 10 maskiner hver med 4 I / O-kanaler, hver kanal med 100 MB / s. Gæt det, hvor lang tid det tog at læse dataene? 4, 3 minutter. HDFS løser problemet med lagring af big data. De to hovedkomponenter i HDFS er NAVN NODE og DATA NODE. Navneknudepunktet er masteren, vi kan også have en sekundær navneknap i tilfælde af, at den primære navneknudepunkt ophører med at fungere, fungerer den sekundære navneknudepunkt som en sikkerhedskopi. Navneknuden opretholder og administrerer dybest set dataknuderne ved at gemme metadata. Dataknudepunktet er slaven, som dybest set er den lavpris-råvareshardware. Vi kan have flere datanoder. Dataknuden gemmer de faktiske data. Denne dataknudder understøtter replikationsfaktoren, antag at hvis den ene dataknudefald går ned, kan dataene fås adgang til den anden replikerede dataknudepunkt, derfor bliver tilgængeligheden af data forbedret, og tab af data forhindres.

3. Kort reducering:

Det løser problemet med behandling af big data. Lad os forstå begrebet kortreduktioner ved at løse dette virkelige verden problem. ABC-selskab ønsker at beregne sit samlede salg, bymæssigt. Nu her fungerer hash-tabelkonceptet ikke, fordi dataene er i terabyte, så vi vil bruge Map-Reduce-konceptet.

Der er to faser: a) MAP. b) REDUSER

a) Kort : Først vil vi opdele dataene i mindre bidder kaldet kortlæggere på grundlag af nøgle / værdiparret. Så her vil nøglen være bynavnet og værdien være det samlede salg. Hver kortlægger får hver måneds data, der giver et bynavn og tilsvarende salg.

b) Reducer: Det får disse bunker med data, og hver reducer er ansvarlig for byer i nord / vest / øst / syd. Så arbejdet med reduktionsindretningen vil være at samle disse små bidder og konvertere til større mængder (ved at tilføje dem) til en bestemt by.

4.YARN-ramme: Endnu en ressourceforhandler.

Den oprindelige version af Hadoop havde kun to komponenter: Map Reduce og HDFS. Senere blev det klar over, at Map Reduce ikke kunne løse en masse big data-problemer. Ideen var at tage ansvaret for ressourcestyring og jobplanlægning væk fra den gamle kortreducerende motor og give den til en ny komponent. Så sådan kom YARN ind i billedet. Det er det midterste lag mellem HDFS og Map Reduce, der er ansvarlig for styring af klyngeressourcer.

Det har to nøgleroller at udføre: a) Jobplanlægning. b) Ressourcestyring

a) Jobplanlægning: Når der leveres en stor mængde data til behandling, skal de fordeles og opdeles i forskellige opgaver / job. Nu beslutter JS, hvilket job der skal prioriteres højest, tidsintervallet mellem to job, afhængighed mellem jobene, kontrollerer, at der ikke er nogen overlapning mellem de kørte job.

b) Ressourcestyring: Til behandling af dataene og til lagring af data har vi brug for ressourcer, ikke? Så ressourcemanageren leverer, administrerer og vedligeholder ressourcerne til at gemme og behandle dataene.

Så nu er vi klare over Hadoop-konceptet, og hvordan det løser de udfordringer, der er skabt af STORE DATA !!!

Anbefalede artikler

Dette har været en guide til Hadoop Framework. Her har vi også diskuteret de top 4 Hadoop rammer. Du kan også gennemgå vores andre foreslåede artikler for at lære mere -

- Hadoop-database

- Hadoop økosystem

- Anvendelser af Hadoop

- Hadoop Administrator Jobs

- Hadoop Administrator | Færdigheder & karrierevej