Hvad er Apache Hadoop økosystem?

Apache Hadoop Ecosystem er en ramme eller en open source dataplatform, der er tildelt til at gemme og undersøge de enorme samlinger af data ustruktureret. Overalt i verden er der masser af data, der fremmes fra adskillige digitale platforme med den førende innovative teknologi til big data. Derudover var Apache Hadoop den første, der fik denne strøm af innovation.

Hvad består af Hadoop Dataarkitektur / økosystem?

Hadoop Ecosystem er ikke et programmeringssprog eller en tjeneste, det er en ramme eller platform, der tager sig af big data-problemer. Du kan identificere det som en pakke, der omslutter forskellige tjenester, såsom opbevaring, indtagelse, vedligeholdelse og analyse inde i det. Undersøg derefter og få en kortfattet tanke om, hvordan tjenesterne udelukkende fungerer og i samarbejde. Apache Hadoop-arkitekturen består af forskellige innovationer og Hadoop-elementer, gennem hvilke selv de komplicerede informationsproblemer kan løses effektivt.

Følgende er skildringen af hver del: -

1) Namenode: Det styrer processen med information

2) Datanode: Den komponerer oplysningerne til lokal opbevaring. At gemme al information på et enkelt sted foreslås ikke kontinuerligt, da det kan medføre tab af information i tilfælde af strømstop.

3) Task tracker: De modtager opgaver, der er tildelt slaveknuden

4) Kort: Det tager information fra en strøm, og hver linje håndteres opdelt for at dele den i forskellige felter

5) Formindsk: Her er felterne, der er erhvervet gennem Map, samlet eller forbundet med hinanden

Apache Hadoop økosystem - trin for trin

Hvert element i Hadoop-økosystemet, da specifikke aspekter er indlysende. Det omfattende perspektiv på Hadoop-strukturen tilbyder bemærkelsesværdig kvalitet til Hadoop Distribuerede filsystemer (HDFS), Hadoop YARN, Hadoop MapReduce og Hadoop MapReduce fra Hadoops økosystem. Hadoop giver endda ethvert Java-bibliotek, betydelige Java-poster, refleksion af operativsystemniveauer, fordele og scripts til at betjene Hadoop. Hadoop YARN er en metode til forretningsoversigt og styring af bundtressourcer. I Hadoop-konfiguration giver HDFS en høj kapacitetsgang til applikationsinformation, og Hadoop MapReduce giver YARN-baseret parallel forberedelse af omfattende datasortimenter.

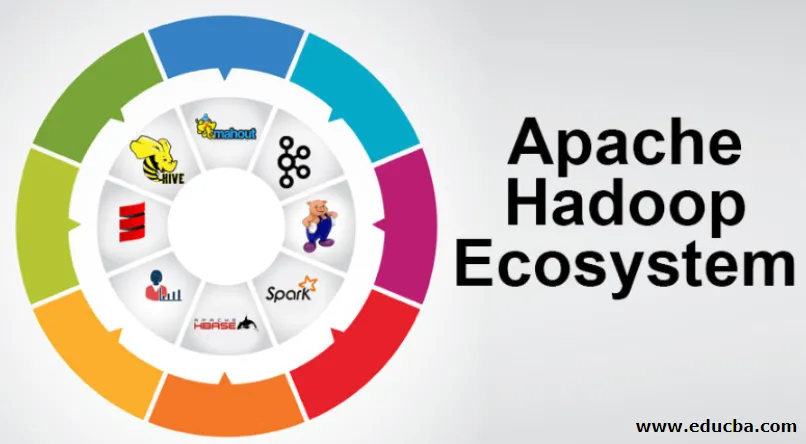

Apache Hadoop økosystemoversigt

Det er et grundlæggende emne at forstå, inden du begynder at arbejde med Hadoop Ecosystem. Nedenfor er de væsentlige komponenter:

- HDFS: Dette er den midterste del af Hadoop økosystem og det kan spare en enorm mængde ustruktureret, struktureret og semistruktureret information.

- Garn: Det ligner sindet i Hadoop-økosystemet, og al håndtering foregår direkte her, som kan inkorporere aktivallokering, planlægningsopgave og forberedelse af handlinger.

- MapReduce: Det er en blanding af to processer, beskrevet som Map and Reduce og består af essens, der forbereder dele, der komponerer enorme informationssamlinger, der bruger parallelle og spredte algoritmer inde i Hadoop-økosystemet.

- Apache Pig: Det er et sprog i proceduren, der bruges til parallelhåndtering af applikationer til at behandle enorme informationssamlinger i Hadoop-tilstand, og dette sprog er en mulighed for Java-programmering.

- HBase: Det er en open source og en ikke-tilknyttet eller NoSQL-database. Det styrker alle informationstyper og kan således håndtere enhver informationstype inden for en Hadoop-ramme.

- Mahout, Spark MLib: Mahout bruges til maskinlæring og giver natur til at oprette applikationer til maskinlæring.

- Zookeeper: For at beskæftige sig med grupperne kan man bruge Zookeeper, det kaldes ellers koordineringsherren, som kan give pålidelige, hurtige og sorterede operationelle administrationer for Hadoop-bunterne.

- Oozie: Apache Oozie driver planlægning af arbejder og fungerer som en alarm- og ur-service i Hadoop-økosystemet.

- Ambari: Det er et selskab fra Apache Software Foundation, og det kan udføre Hadoop-økosystemet gradvist fleksibelt.

Hadoop YARN:

Tænk på YARN som sindet i dit Hadoop-økosystem. Det afspiller hele behandlingen ved at tildele aktiver og planlægningsopgaver.

Det har to bemærkelsesværdige segmenter, der er ResourceManager og NodeManager.

- ResourceManager: - Det er igen en vigtig knude i driftsafdelingen. Det får de forberedende forespørgsler, og derefter sendes de forespørgsler til respektive NodeManagers, hvor den ægte håndtering sker.

- NodeManagers: - Disse er installeret på hver DataNode. Det er ansvarlig for udførelsen af en opgave på hver DataNode.

Hvordan fungerer Apache Hadoop?

- Det er beregnet til at stige op fra individuelle servere til en enorm mængde maskiner, der hver leverer lokal beregning og kapacitet. I stedet for at afhænge af udstyret til at overføre høj tilgængelighed, er biblioteket i sig selv beregnet til at skelne og håndtere skuffelser ved applikationslaget, så det formidles en overordentlig tilgængelig service over en flok pc'er, der hver især kan være tilbøjelige til skuffelser.

- Se dog videre, og der er markant stigende charme på arbejdet. Hadoop er helt modulopbygget, hvilket betyder, at du praktisk talt kan udveksle ethvert af dets segmenter til et alternativt softwareværktøj. Det gør arkitekturen fantastisk tilpasningsdygtig, lige så kraftfuld og effektiv.

Apache Hadoop Spark:

- Apache Spark er et system til realtidsinformationsanalyse i en spredt databehandlingsindstilling. Det implementerer computere i hukommelsen for at opbygge hastigheden i informationshåndtering.

- Det er hurtigere til at håndtere information i stor skala, da den bruger beregninger i hukommelsen og forskellige forbedringer. Langs disse linjer kræver det høj forarbejdningskraft.

Hvordan fungerer Apache Pig?

- Apache Pig er et gavnligt system Yahoo blev udviklet til at undersøge store informationspositioner effektivt og glat. Det giver nogle top-niveau informationsstrøm sprog svin Latin, som er forbedret, udvidelig og enkel at bruge.

- Den usædvanlige komponent i svineprogrammer, hvor deres sammensætning er tilgængelig for betydelig parallelisering, hvilket gør dette enkelt i retning af at tage sig af betydelige informationssamlinger.

Gris Brug sag:

- Oplysninger om privatpersoners sundhedsydelser er private og burde ikke videregives til andre mennesker. Disse data burde være skjult for at opretholde hemmeligholdelse, men informationen om medicinske tjenester er enorm, til det er nødvendigt at anerkende og udelukke individuelle sundhedsoplysninger. Apache Pig kan bruges under sådanne forhold til at genkende sundhedsdata.

Konklusion:

- Det er skitseret at stige op fra kun en server til en enorm mængde maskiner, der alle leverer nærliggende beregning og kapacitet. Se dog videre, og der er meget mere og mere fortryllelse på arbejdet.

- Hadoop er helt modulopbygget, hvilket indebærer, at du praktisk talt kan udveksle en hvilken som helst af dens dele til et alternativt softwareværktøj. Det gør strukturen fantastisk tilpasningsdygtig, lige så kraftfuld og effektiv.

Anbefalede artikler

Dette har været en guide til Apache Hadoop økosystem. Her har vi drøftet, hvad der er Apache Hadoop Ecosystem? oversigt over Hadoop-arkitektur og funktionen af Hadoop-økosystemet. Du kan også gennemgå vores andre foreslåede artikler for at lære mere -

- Hadoop økosystemkomponenter

- Sådan installeres Apache

- Apache gnisttræning

- Karriere i Hadoop