Introduktion til kernemetoder

Kerner eller kernemetoder (også kaldet Kernelfunktioner) er sæt af forskellige typer algoritmer, der bruges til mønsteranalyse. De bruges til at løse et ikke-lineært problem ved hjælp af en lineær klassifikator. Kernemetoder anvendes i SVM (Support Vector Machines), som bruges i klassificerings- og regressionsproblemer. SVM bruger det, der kaldes en "Kernel Trick", hvor dataene transformeres, og der findes en optimal grænse for de mulige output.

Behovet for kernemetode og dens arbejde

Før vi går ind i brugen af Kernel-metoderne, er det vigtigere at forstå supportvektormaskiner eller SVM'er, fordi kerner implementeres i SVM-modeller. Supportvektomaskiner overvåges således, maskinlæringsalgoritmer, der bruges i klassificerings- og regressionsproblemer, såsom klassificering af et æble til klassefrugt, mens en løve klassificeres til klassedyret.

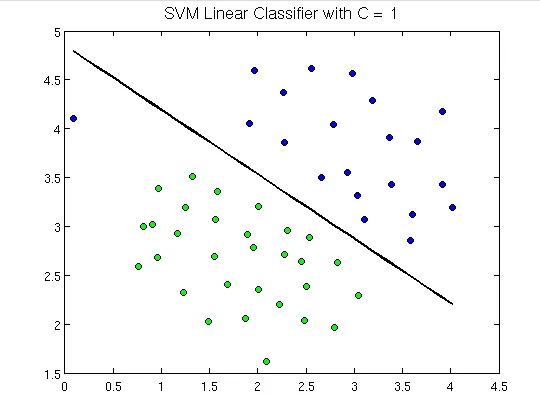

For at demonstrere er nedenfor, hvordan supportvektormaskiner ser ud:

Her kan vi se et hyperplan, der adskiller grønne prikker fra de blå. En hyperplan er en dimension mindre end det omgivende plan. F.eks. I ovenstående figur har vi 2 dimensioner, der repræsenterer det omgivende rum, men den ensomme, der deler eller klassificerer rummet, er en dimension mindre end omgivelsesrummet og kaldes hyperplan.

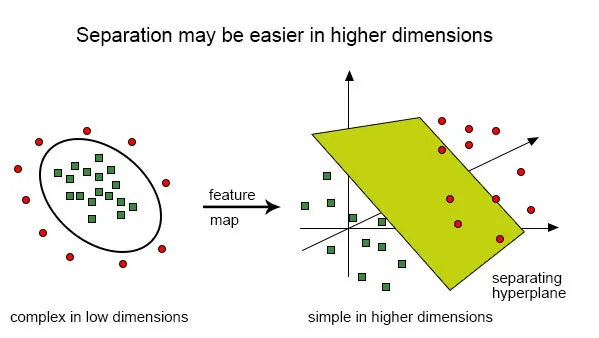

Men hvad nu hvis vi har input som dette:

Det er meget vanskeligt at løse denne klassificering ved hjælp af en lineær klassificering, da der ikke er nogen god lineær linje, der skal være i stand til at klassificere de røde og de grønne prikker, da punkterne er tilfældigt fordelt. Her kommer brugen af kernefunktion, der tager punkterne til højere dimensioner, løser problemet derovre og returnerer output. Tænk på dette på denne måde, vi kan se, at de grønne prikker er lukket i et eller andet perimeterområde, mens de røde ligger uden for det, ligesom der også kan være andre scenarier, hvor grønne prikker muligvis kan distribueres i et trapezformet område.

Så hvad vi gør er at konvertere det todimensionelle plan, som først blev klassificeret af en-dimensionelt hyperplan (“eller en lige linje”) til det tredimensionelle område, og her vil vores klassifikator, dvs. hyperplan, ikke være en lige linje, men en to -dimensionalt plan, der skærer området.

For at få en matematisk forståelse af kerne, lad os forstå Lili Jiangs ligning af kerne, som er:

K (x, y) = hvor,

K er kernefunktionen,

X og Y er de dimensionelle input,

f er kortet fra n-dimensionelt til m-dimensionelt rum og,

er prikproduktet.

Illustration ved hjælp af et eksempel.

Lad os sige, at vi har to punkter, x = (2, 3, 4) og y = (3, 4, 5)

Som vi har set, er K (x, y) =.

Lad os først beregne

f (x) = (x1x1, x1x2, x1x3, x2x1, x2x2, x2x3, x3x1, x3x2, x3x3)

f (y) = (y1y1, y1y2, y1y3, y2y1, y2y2, y2y3, y3y1, y3y2, y3y3)

så,

f (2, 3, 4) = (4, 6, 8, 6, 9, 12, 8, 12, 16) og

f (3, 4, 5) = (9, 12, 15, 12, 16, 20, 15, 20, 25)

så prikproduktet,

f (x). f (y) = f (2, 3, 4). f (3, 4, 5) =

(36 + 72 + 120 + 72 +144 + 240 + 120 + 240 + 400) =

1444

Og,

K (x, y) = (2 * 3 + 3 * 4 + 4 * 5) 2 = (6 + 12 + 20) 2 = 38 * 38 = 1444.

Dette, som vi finder ud af, f (x) .f (y) og K (x, y) giver os det samme resultat, men den førstnævnte metode krævede en masse beregninger (på grund af projicering af 3 dimensioner i 9 dimensioner), mens vi anvendte kerne, det var meget lettere.

Kernetyper og metoder i SVM

Lad os se nogle af kernefunktionerne eller de typer, der bruges i SVM:

1. Liner Kernel - Lad os sige, at vi har to vektorer med navnet x1 og Y1, så er den lineære kerne defineret af dot-produktet fra disse to vektorer:

K (x1, x2) = x1. x2

2. Polynomisk kerne - En polynomisk kerne er defineret ved følgende ligning:

K (x1, x2) = (x1. X2 + 1) d,

Hvor,

d er graden af polynomet og x1 og x2 er vektorer

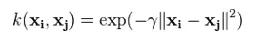

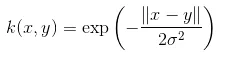

3. Gaussian Kernel - Denne kerne er et eksempel på en radiel basisfunktionskerne. Nedenfor er ligningen for dette:

Den givne sigma spiller en meget vigtig rolle i udførelsen af den Gaussiske kerne og bør hverken overvurderes eller undervurderes, den skal omhyggeligt afstemmes i henhold til problemet.

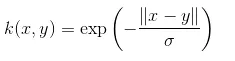

4. Eksponentiel kerne - Dette er i tæt forhold til den forrige kerne, dvs. den Gaussiske kerne med den eneste forskel er - kvadratet til normen fjernes.

Funktionen af den eksponentielle funktion er:

Dette er også en radial basis-kernefunktion.

5. Laplacian Kernel - Denne type kerne er mindre tilbøjelig til ændringer og er helt lig med tidligere diskuterede eksponentielle funktionskerner, ligningen af Laplacian kernel er angivet som:

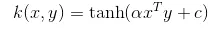

6. Hyperbolic eller Sigmoid Kernel - Denne kerne bruges i neurale netværksområder inden for maskinlæring. Aktiveringsfunktionen for sigmoidkernen er den bipolære sigmoidfunktion. Ligningen for den hyperboliske kernefunktion er:

Denne kerne er meget brugt og populær blandt understøttelsesvektormaskiner.

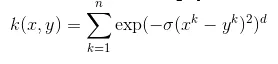

7. Anova radial basiskerne - Denne kerne er kendt for at fungere meget godt i flerdimensionelle regressionsproblemer ligesom de gaussiske og laplaciske kerner. Dette hører også under kategorien kerne med radial basis.

Ligningen for Anova-kerne er:

Der er meget flere typer kernemetode, og vi har drøftet de mest anvendte kerner. Det afhænger rent af den type problem, der vil bestemme, hvilken kernefunktion der skal bruges.

Konklusion

I dette afsnit har vi set definitionen af kernen, og hvordan den fungerer. Vi forsøgte at forklare ved hjælp af diagrammer om brugen af kerner. Vi har derefter forsøgt at give en enkel illustration ved hjælp af matematik om kernefunktionen. I den sidste del har vi set forskellige typer kernefunktioner, der er vidt brugt i dag.

Anbefalede artikler

Dette er en vejledning til kernemetoder. Her diskuterer vi en introduktion, behov, dets arbejde og typer af kernemetoder med den passende ligning. Du kan også gennemgå vores andre foreslåede artikler for at lære mere -

- Dataindvindingsalgoritmer

- K- betyder klynge-algoritme

- Brute Force-algoritme

- Beslutningstræealgoritme

- Kernemetoder i maskinlæring

- Beslutningstræ i maskinlæring