Introduktion til kernemetoder i maskinlæring

Algoritmen, der bruges til mønsteranalyse, kaldes Kernel Method in Machine Learning. I det generelle mønster udføres analyse for at finde relationer i datasæt. Disse relationer kan være klynger, klassificering, hovedkomponenter, korrelation osv. De fleste af disse algoritmer, der løser disse opgaver med at analysere mønsteret, har brug for dataene i rårepræsentant, for at blive eksplicit omdannet til en funktionsvektorrepræsentation. Denne transformation kan udføres via et brugerdefineret funktionskort. Så det kan tages, at kun den brugerspecificerede kerne kræves af kernemetoden.

Terminologien Kernal Method stammer fra det faktum, at de bruger kernefunktion, som giver dem mulighed for at udføre handlingen i højdimensionelt, implicit funktionsrum uden behov for at beregne koordinaterne for dataene i det rum. I stedet beregner de simpelthen det indre produkt mellem billederne af alle datapar i funktionsområdet.

Disse former for operationer er beregningsmæssigt billigere det meste af tiden sammenlignet med den eksplicitte beregning af koordinaterne. Denne teknik kaldes 'kerne trick'. Enhver lineær model kan konverteres til en ikke-lineær model ved at anvende kerne-trick på modellen.

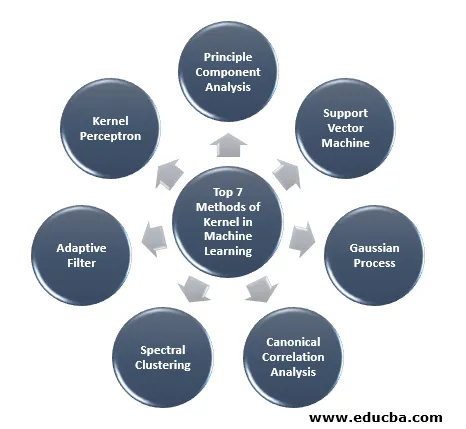

Kernemetode, der er tilgængelig i maskinlæring, er analyse af hovedkomponenter (PCA), spektral klynger, supportvektormaskiner (SVM), kanonisk korrelationsanalyse, kerne perceptron, Gaussiske processer, kamregression, lineære adaptive filtre og mange andre. Lad os have en høj forståelse af et par af disse kernemetoder.

Top 7 metoder til kerneel i maskinlæring

Her er nedenstående Metoder til Kernel i Machine Learning:

1. Principkomponentanalyse

Principal component analysis (PCA) er en teknik til udtrækning af struktur fra muligvis højdimensionelle datasæt. Det udføres let ved hjælp af iterative algoritmer, der estimerer hovedkomponenter eller ved at løse et egenværdiproblem. PCA er en ortogonal transformation af det koordinatsystem, hvor vi beskriver vores data. Det nye koordinatsystem opnås ved projicering på de vigtigste akser i dataene. Et lille antal hovedkomponenter er ofte tilstrækkelige til at redegøre for det meste af strukturen i dataene. En af dens vigtigste applikationer er at udføre sonderende dataanalyse til fremstilling af en forudsigelig model. Det bruges mest til at visualisere sammenhængen mellem populationer og genetisk afstand.

2. Support Vector Machine

SVM kan defineres som en klassifikator til at adskille hyperplan, hvor hyperplan er underområdet til en dimension mindre end det omgivende rum. Dimensionen af dette matematiske rum defineres som det minimale antal koordinater, der kræves for at specificere et hvilket som helst punkt, mens det omgivende rum er det rum, der omgiver det matematiske objekt. Nu kan matematisk objekt forstås som et abstrakt objekt, der ikke findes på ethvert tidspunkt eller sted, men som findes som en type ting.

3. Gaussisk proces

Den Gaussiske proces blev opkaldt efter Cark Friedrich Gauss, fordi den bruger notationen om Gaussisk distribution (normal distribution). Det er en stokastisk proces, der betyder en samling af tilfældige variabler indekseret efter tid eller rum. I Gaussian Process har tilfældige variabler en multivariat normal fordeling, dvs. alle de endelige lineære kombinationer af den er normalt fordelt. Den Gaussiske proces bruger egenskaberne, der er arvet fra en normal fordeling, og er derfor nyttige i statistisk modellering. Maskinlæringsalgoritme, der involverer denne kernemetode, bruger måling af doven læring og ligheden mellem punkter for at forudsige værdien af usete punkter fra træningsdata. Denne forudsigelse er ikke kun estimatet, men usikkerheden på det tidspunkt.

4. Kanonisk korrelationsanalyse

Kanonisk korrelationsanalyse er en måde at udlede information fra matriser på tværs af kovarians på. Det er også kendt som kanonisk variabelanalyse. Antag, at vi har to vektor X, Y af tilfældig variabel, siger to vektorer X = (X1, …, Xn) og vektor Y = (Y1, …, Ym), og variablen har korrelation, så CCA beregner en lineær kombination af X og Y, som har den maksimale korrelation mellem hinanden.

5. Spektral klynger

Ved anvendelse af billedsegmentering er spektralklyngering kendt som segmenteringsbaseret objektkategorisering. I spektral klynger udføres dimensionalitetsreduktion inden klynge i færre dimensioner, dette gøres ved at bruge egenværdien af lighedens matrix af dataene. Det har sine rødder i grafteori, hvor denne tilgang bruges til at identificere samfund af knudepunkter i en graf, der er baseret på kanterne, der forbinder dem. Denne metode er fleksibel nok og tillader os også at klynge data fra ikke-graf.

6. Adaptivt filter

Det adaptive filter bruger et lineært filter, der omfatter en overførselsfunktion, der styres af variable parametre og metoderne, som vil blive brugt til at justere disse parametre i henhold til optimeringsalgoritmen. Kompleksiteten af denne optimeringsalgoritme er grunden til, at alt adaptivt filter er et digitalt filter. Et adaptivt filter er nødvendigt i de applikationer, hvor der ikke er forudgående information om den ønskede behandlingsoperation på forhånd, eller de ændrer sig.

Omkostningsfunktionen bruges i det adaptive filter med lukket sløjfe, da det er nødvendigt for den optimale ydelse af filteret. Det bestemmer, hvordan filteroverførselsfunktionen ændres for at reducere omkostningerne ved den næste iteration. En af de mest almindelige funktioner er den gennemsnitlige firkantede fejl i fejlsignalet.

7. Kernel Perceptron

I maskinindlæring er kernepertronet en type af den populære perceptron-indlæringsalgoritme, der kan lære kernemaskiner, såsom ikke-lineære klassifikatorer, der bruger en kernefunktion til at beregne ligheden af de prøver, der er uset til træningsprøver. Denne algoritme blev opfundet i 1964, hvilket gjorde den til den første kerneklassificeringselev.

De fleste af de diskuterede kernealgoritmer er baseret på konveks optimering eller egenproblemer og er statistisk velbegrundede. Deres statistiske egenskaber analyseres ved hjælp af den statistiske læringsteori.

Når vi taler om applikationsområderne for kernemetoder, er det forskelligartet og inkluderer geostatistik, kriging, omvendt afstandsvejning, 3D-rekonstruktion, bioinformatik, kemoinformatik, informationsekstraktion og håndskriftgenkendelse.

Konklusion

Jeg har opsummeret nogle af terminologierne og typerne af kernemetoder i Machine Learning. På grund af mangel på plads er denne artikel på ingen måde omfattende og er kun beregnet til at give dig forståelse af, hvad kernemetoden er, og en kort oversigt over deres typer. Men hvis du dækker denne artikel, vil du tage det første skridt inden for maskinlæring.

Anbefalede artikler

Dette er en guide til Kernel-metoden i maskinlæring. Her diskuterer vi de 7 typer kernemetoder i maskinlæring. Du kan også se på den følgende artikel.

- Monolitisk kerne

- Klynge i maskinlæring

- Data Science Machine Learning

- Uovervåget maskinlæring

- PHP-filtre | Sådan valideres brugerinput ved hjælp af forskellige filtre?

- Komplet guide til maskinlæring livscyklus